Evaluación de la competencia oral con rúbricas

digitales para el Espacio Iberoamericano del Conocimiento

Assessment oral competence

with digital rubrics for the Ibero-American Knowledge Space

Dr. Carlos Rafael Fernández Medina. Profesor

Auxiliar de Universidad. Universidad Agraria de la Habana. Cuba

Dr. Carlos Rafael Fernández Medina. Profesor

Auxiliar de Universidad. Universidad Agraria de la Habana. Cuba

Dra. Cristina Raquel Luque Guerrero. Profesora

sustituta interina. Universidad de Málaga. España

Dra. Cristina Raquel Luque Guerrero. Profesora

sustituta interina. Universidad de Málaga. España

Dr. Francisco José Ruiz Rey. Profesor

asociado. Universidad de Málaga. España

Dr. Francisco José Ruiz Rey. Profesor

asociado. Universidad de Málaga. España

Dra. Diana Elizabeth Rivera Rogel. Profesora

Titular de Universidad. Universidad Técnica Particular de Loja. Ecuador

Dra. Diana Elizabeth Rivera Rogel. Profesora

Titular de Universidad. Universidad Técnica Particular de Loja. Ecuador

Dra. Lucy Deyanira Andrade Vargas. Profesor

Titular de Universidad. Universidad Técnica Particular de Loja. Ecuador

Dra. Lucy Deyanira Andrade Vargas. Profesor

Titular de Universidad. Universidad Técnica Particular de Loja. Ecuador

Dr. Manuel Cebrián de la Serna. Catedrático de

Universidad. Universidad de Málaga. España

Dr. Manuel Cebrián de la Serna. Catedrático de

Universidad. Universidad de Málaga. España

Recibido:

2020/09/15 Revisado: 2020/09/30 Aceptado: 2021/02/08 Preprint:

2021/07/19 Publicado: 2021/09/01

Cómo citar este artículo:

Fernández-Medina, C.,

Conde, Luque-Guerrero, C., Ruiz-Rey, F., Rivera-Rogel, D., Andrade Vargas, L.,

& Cebrián-De la Serna, M. (2021). Evaluación de la competencia oral con

rúbricas digitales para el Espacio Iberoamericano del Conocimiento [Assessment

oral competence with digital rubrics for the Ibero-American Knowledge Space]. Pixel-Bit. Revista de Medios y Educación,

62, 71-106. https://doi.org/10.12795/pixelbit.83050

RESUMEN

Las instituciones del Espacio Iberoamericano del Conocimiento (EIC) colaboran en proyectos educativos. Siendo la competencia comunicativa imprescindible para el desarrollo profesional y la colaboración del propio EIC. Este trabajo analiza los resultados de un proyecto educativo de colaboración entre ocho universidades y cinco países Iberoamericanos sobre la construcción de una rúbrica común validada con Delphi para evaluar las competencias orales en la exposición de proyectos por los estudiantes. La rúbrica se aplicó en tres grupos de estudiantes de tres instituciones y países distintos (Cuba, Ecuador y España), con modalidades de evaluación formativa (docente, autoevaluación y pares), analizando 788 evaluaciones totales (90 docentes, 61 autoevaluaciones y 637 pares). Los resultados confirman un “alfa de Cronbach” (.934) para las 22 variables analizadas. Con la prueba de Post-Hoc de Tukey en todos los ítems las evaluaciones de pares obtienen peores resultados que evaluación docente, mientras que las autoevaluaciones son mejores. La opinión de los estudiantes con un instrumento validado de satisfacción obteniendo una propuesta significativa de reedición de la rúbrica. El artículo ofrece como producto una rúbrica base validada y experimentada exitosamente en contextos geográficamente diferenciados del EIC.

ABSTRACT

The institutions of the Ibero-American Knowledge Space

(EIC) collaborate in educational projects. Communication skills are essential

for the professional development and collaboration of the EIC itself. This

paper analyzes the results of a collaborative educational project between eight

universities and five Ibero-American countries on the construction of a common

rubric validated with Delphi to assess oral competences in the presentation of

projects by students. The rubric was applied to three groups of students from

three different institutions and countries (Cuba, Ecuador and Spain), with

formative evaluation modalities (teacher, self-evaluation and peers), analyzing

788 total evaluations (90 teachers, 61 self-evaluations and 637 peers). The results

confirm a "Cronbach's alpha" (.934) for the 22 variables analysed.

With Tukey's Post-Hoc test in all items, the peer evaluations are worse than

the teacher evaluations, while the self-evaluations are better. The students'

opinion with a validated satisfaction instrument obtaining a significant

proposal to reissue the rubric. The article offers as a product a base rubric

validated and successfully experienced in geographically differentiated

contexts of the EIC.

PALABRAS CLAVES · KEYWORDS

Expresión oral,

competencias del docente, formación de docente, métodos de evaluación, rúbricas

digitales.

Oral expression, teacher competence, teacher training,

evaluation methods, digital rubric.

1.

Introducción

Las competencias para la comunicación y colaboración

que encontramos en el Marco Europeo de Competencias Digitales para los

Ciudadanos -DigComp-, y las competencias digitales de los docentes en el INTEF

(2017), sitúan a la competencia comunicativa, especialmente la comunicación

oral, y más recientemente de escritura académica y científica (Greenberg, 2015;

Rakedzon & Baram-Tsabari, 2017), como un tema prioritario de atención en la

formación inicial de docentes.

El

desarrollo de competencias para la presentación oral de trabajos por los

estudiantes es un objetivo esencial en la educación superior en todo el mundo,

donde se recogen dichas competencias en el marco curricular de la mayoría de

los planes de estudio (Van Ginkel, Gulikers, Biemans & Mulder, 2015). Aquí

se pone en valor el desarrollo de habilidades comunicativas, el uso correcto

del lenguaje y la expresión oral por los futuros profesionales de educación y

su integración en las actividades académicas, laborales e investigativas. Para

Fernández García, Torío López, Viñuela Hernández, Molina Martín y Bermúdez Rey

(2008), esta es una competencia básica en el ejercicio de todo profesional cuyo

trabajo implique la interacción con personas en contextos diferentes. De ahí la

necesidad de desarrollar esta competencia para perfeccionar, mejorar y conocer

los modos de convertirse en comunicadores eficaces (Fernández López, 2007), en

un mundo cada vez más digital y multicultural.

En

investigaciones consultadas, concluyen que muchos de los estudiantes

universitarios sienten que no tienen habilidades de expresión oral en sus

presentaciones, tanto en situaciones interactivas (conversaciones, diálogos,

debates…), como en situaciones no-interactivas (informes orales,

disertaciones…) (Roldán, 2001). De igual forma Arráez-Aybar et al. (2008)

señala que “la comunicación oral es deficitaria en un amplio número de

universitarios, poco habituados a hablar en público y explicar sus puntos de

vista con un lenguaje adaptado al entorno profesional” (p. 171).

Frente

a esta situación, dos de las cuestiones básicas que se plantea todo docente

cuando pretende mejorar estas competencias en sus estudiantes consiste en: por

un lado, partir de una definición clara, pertinente y precisa de la competencia

que deseamos mejorar; y, por otro lado, establecer una fórmula eficiente que

nos permita evaluar los avances en nuestros estudiantes gracias a las acciones

formativas que se planteen.

En

cuanto al primer aspecto, podemos considerar los trabajos de Van Ginkel,

Gulikers, Biemans y Mulder, (2015) por su síntesis y complejidad, cuando define

la competencia comunicativa como una:

“combinación

de conocimientos, habilidades, y actitudes necesarias para hablar en público,

con el fin de informar, expresarse, establecer relaciones y persuadir, a lo

cual le confiere el valor de interrelación y el dominio de elementos

cognitivos, de comportamiento y afectivos” (p.63).

En

cuanto al segundo tema, una de las metodologías que han mostrado eficacia y

eficiencia para la evaluación formativa de esta competencia han sido el uso de

rúbricas en diferentes materias, áreas y contextos docentes, siendo una

metodología de evaluación a la vez que un instrumento de autogestión de la

propia evaluación que representa una oportunidad para atender la evaluación de

la competencia comunicativa (Gallego-Arrufat & Raposo-Rivas, 2014; Hima

& Saputro, 2017) con muchas diferentes posibilidades para su diseño

(Dawson, 2017).

En

sus aplicaciones en el ámbito de la enseñanza universitaria, las rúbricas se

han convertido en digitales, demostrado altos niveles de aceptación dada su

condición de guías a la vez que “ayudan a asignar distintos pesos a cada tarea

o subtarea realizada en cada actividad. (…) los estudiantes estiman su propia

calificación tanto de las prácticas individuales como de la colaborativa

grupal, y su nivel de competencias adquirido” (Villalustre Martínez & del

Moral Pérez, 2010, p.98). Esta cualidad de las rúbricas digitales permite la

autoevaluación y la evaluación formativa (evaluación de pares, evaluación de

equipos, autoevaluación, evaluación ipsativa…) por su rapidez y

retroalimentación constante, representa una de las metodologías más aceptadas

por los estudiantes, en tanto les sirven para la autoformación orientando su

proceso de aprendizaje (Martínez-Figueira, Tellado-Gónzalez & Rapaso-Rivas,

2013).

Son

resultados de investigaciones sobre la satisfacción de los estudiantes en el

uso de rúbricas digitales las que refuerza estas ventajas, con valoraciones por

los estudiantes como: “…interesante, motivadora, anima a la participación,

fomenta tanto el trabajo cooperativo como la coevaluación (…) consideran un

éxito la experiencia y aprecian la retroalimentación recibida como una guía

para mejorar su próximo desempeño” (Gallego-Arrufat & Raposo-Rivas, 2014,

p.211). También Serrano-Angulo y Cebrián-Robles (2014) presentan altos

resultados de coeficiente de fiabilidad en el uso de rúbricas digitales; así

como, en la comparación de satisfacción con otras herramientas que evidencian

valores por encima de la media.

Uno

de los ejercicios más utilizados para fomentar esta competencia comunicativa

son las exposiciones de trabajos y proyectos en público por los estudiantes.

Para la educación universitaria, las competencias comunicativas son reconocidas

por Murillo-Zamorano y Montanero (2017), como la habilidad para presentar

información en público de forma clara y elocuente ajustada a los diferentes

contextos académicos y profesionales. Estos autores en su investigación

presentan diferentes aspectos a tener en cuenta al evaluar las presentaciones

orales:

·

Contenidos

de la presentación teniendo en cuenta el contexto y la audiencia.

·

Tener

un objetivo claro y una correcta articulación y organización de las ideas.

·

Utilizar

material electrónico y audiovisual de soporte efectivo y adecuado.

·

Uso

apropiado del lenguaje, así como otros elementos como el ritmo, el tono y

volumen.

·

La

articulación y otros aspectos no verbales como gestos y posturas.

En

relación con estas dimensiones y criterios para el desarrollo de la competencia

oral expositiva, en la bibliografía consultada encontramos que García-Ros

(2011) propone cuatro dimensiones a evaluar con 12

criterios relacionados con: el contenido, la aplicación práctica, el apoyo visual

y las habilidades verbales. Por su parte, Verano-Tacoronte et al. (2016)

proponen la adecuación de los contenidos de la presentación y referencias

bibliográficas, también los aspectos formales y su relación con la corrección

de los medios visuales de apoyo, dominio del espacio físico y elocuencia; así

como, la adecuada gestión del tiempo. Y más adelante en otro trabajo,

Galván-Sánchez et al. (2017) utilizan como criterios y variables de evaluación

de la competencia oral: el orden y claridad, uso de soportes audiovisuales y

otros, distribución de tiempo, lenguaje corporal y oral.

Como

se puede apreciar en las propuestas anteriores, y a pesar de ser indicadores

pertinentes, no existe un consenso en cuanto a su número, y más aún de los

criterios para elaborar un instrumento de evaluación para la competencia oral.

No obstante, sí partimos de la concordancia en cuanto a cuáles son los

indicadores básicos. Quedaría, por tanto, construir un instrumento común desde

estos indicadores que se cosifique en criterios claros y precisos, medibles y

cuantificables para contextos geográficos diferenciados y marcos de referencias

como es el Espacio Iberoamericano del Conocimiento.

2.

Metodología

En línea con la necesidad de

diseñar acciones formativas que tengan en cuenta la evaluación de las

competencias comunicativas, especialmente las presentaciones orales. Desde la

Red Iberoamericana de Educación Superior -Resib- [ http://resib.uma.es/

] se planteó la necesidad de construir una

rúbrica validada entre sus miembros para abordar las competencias en la

expresión oral de proyectos y trabajos de los estudiantes en público, que

sirviera de base para su aplicación dentro del Espacio Iberoamericano del

Conocimiento -EIC-. En respuesta a esta necesidad se desarrolló el proyecto

titulado: Experimentación y evaluación de las competencias para la presentación

de trabajos orales con rúbricas digitales -PocoRubric- [https://bit.ly/2ZEWT4Z] (2017-2018) con la participación de ocho

universidades y cinco países Iberoamericanos. En su inicio partimos de la literatura existente y

diseñamos una rúbrica base para un contexto de aplicación en áreas de formación

inicial, como son: las exposiciones de proyectos orales en clase, la defensa de

Trabajos Final del Grado y los Trabajos Final del Máster (Cebrián-Robles,

2017). Tras su validación por métodos Delphi, solo quedaba su aplicación a

contextos y áreas diferentes, además de utilizar distintas metodologías de

formación formativa (evaluación de pares, autoevaluación, evaluación ipsativa,

evaluación de equipos…).

El presente estudio

experimentó y evaluó con diseños cuantitativos y cualitativos la aplicación de

la rúbrica en las exposiciones orales de los estudiantes, y en diferentes

contextos geográficos de tres países diferentes (Cuba, Ecuador y España) en las

titulaciones de Educación y Ciencias Sociales. Tras esta aplicación y

evaluación se procedió a un análisis de la satisfacción por los propios

estudiantes.

El diseño metodológico fue

mixto (cuantitativo y cualitativo) según los objetivos, como fueron: para el

objetivo 1 se desarrolló un diseño de metodología Delphi a doble vuelta; para

el objetivo 2 se analizó el impacto de las evaluaciones (evaluación del

docente, autoevaluación y evaluaciones de pares) que ofreció la rúbrica con un

diseño correlacional de medias según países. Por último, y para el objetivo 3

de satisfacción se aplicó un instrumento validado, junto con un análisis

descriptivo y cualitativo.

·

Diseño

y validación de una rúbrica para evaluar la presentación de proyectos y

trabajos orales por los estudiantes del Espacio Iberoamericano del

Conocimiento.

·

Experimentación

de la rúbrica diseñada para la evaluación formativa (evaluación docente,

autoevaluación y evaluación de pares) en contextos geográficos diferenciados.

·

Valoración

de satisfacción por los estudiantes sobre la rúbrica y metodología

experimentada.

2.2. Validación del diseño de la

rúbrica

La metodología Delphi se ha

utilizado para la elaboración de instrumentos como son las rúbricas (Merma Molina

et al., 2017; Tobón et al., 2018), al ofrecer un acuerdo consensuado en la

identificación, selección y valoración de los indicadores de evaluación, eje

principal de dicho instrumento.

Se utilizó una metodología

Delphi (García Martínez et al., 2012;

Cabero Almenara, 2014; Cabero Almenara et al., 2009; Blanco-López et al., 2015)

a dos vueltas, siguiendo otros trabajos ya realizados en proyectos anteriores y

otros autores (Tejada-Fernández et al., 2015), donde se diseñó una primera

propuesta o primera fase, la cual fue compartida a través de un documento en

Google drive, para a través de sus opiniones realizar los ajustes por

pertinencia, adecuación y exactitud de los indicadores, criterios y evidencias

de la rúbrica. Igualmente, se tuvieron que redefinir el campo semántico de

ciertos términos y palabras utilizadas según cada país. En una segunda fase, y

analizado cuantitativa y cualitativamente los resultados de los expertos,

eliminado las duplicidades y seleccionando los que obtuvieron el 80% de consenso,

quedó como resultado la propuesta que se presenta en la Tabla 1.

La rúbrica de evaluación

definitiva consta de 22 ítems divididos según 4 dimensiones: a) relevancia y

estructura de la información transmitida; b) dominio de la exposición del

mensaje ante el público; c) gestión, motivación y control de la audiencia y d)

calidad de recursos utilizados y manejo del tiempo.

2.3. Contextos

de aplicación de enseñanza iberoamericana

El número de estudiantes de

los tres grupos y países sumaron un total de 90 (17 Cuba, 47 Ecuador y 26

España). La muestra analizada para el estudio de la validez y fiabilidad consta

de 788 resultados de evaluaciones totales de los docentes a las exposiciones

orales de proyectos, como las autoevaluaciones y evaluaciones de pares por los

estudiantes, siendo por metodologías de evaluación 90 evaluaciones de los

docentes, 61 autoevaluaciones y 637 evaluaciones de pares por los estudiantes.

E-rúbrica para

evaluación de presentaciones orales. Fuente: CoRubric.com

|

Competencia 1. Presenta

suficientes contenidos relevantes y bien estructurados |

||||

|

Indicador

1.1. Cantidad y relevancia de la información |

||||

|

Evidencia. 1.1.1. Presenta una información

adecuada y precisa desde el punto de vista científico |

||||

|

Niveles

de logro |

||||

|

1. Ha derivado en un tema diferente al planteado, con

errores conceptuales. |

2. Se ha centrado en aspectos secundarios, ignorando más

de dos aspectos importantes. |

3. Se ha centrado en los aspectos principales, aunque ha

olvidado uno o dos. |

4. Trata todos los elementos más importantes del tema de

manera adecuada e integral. |

|

|

Indicador 1.2. Grado de estructuración del

mensaje |

||||

|

Evidencia 1.2.1. Presenta un mensaje estructurado |

||||

|

Niveles

de logro |

||||

|

1. Mensaje desestructurado. Pasa de un tema a otro. No se

puede seguir. |

2. Sin estructura clara, es difícil de seguir. |

3. Con estructura, aunque no es muy coherente. |

4. Con una estructura coherente y clara (no confusa) |

|

|

Competencia 2. Sabe exponer un

mensaje frente a un público con seguridad |

||||

|

Indicador

2.1. Expresión oral |

||||

|

Evidencia

2.1.1. Mantiene en todo momento una voz clara y buena entonación |

||||

|

Niveles

de logro |

||||

|

1. Ininteligible. Volumen de voz muy bajo y tono monótono.

Mala entonación. |

2. Se le entiende mal. Volumen de voz bajo con mala

entonación y tono dispar. |

3. Se le entiende regular. Volumen de voz normal y/o

regular entonación. |

4. Se le entiende bien. Volumen de voz normal, clara y

buena entonación. |

|

|

Indicador

2.2. Expresión gestual y disposición ante el público |

||||

|

Evidencia

2.2.1. Se mueve por espacio con dominio y relajado |

||||

|

Niveles

de logro |

||||

|

1. Muestra rigidez, gestos nerviosos e incontrolados. No

se mueve. |

2. Muestra rigidez, aunque controla el nerviosismo. No se

mueve. |

3. Por momentos muestra relajación. Se mueve algo. |

4. Se muestra relajado y se mueve libremente con

desenvoltura en el espacio. |

|

|

Indicador

2.3. Grado de seguridad en el manejo de recursos |

||||

|

Evidencia 2.3.1. Utiliza los

recursos tecnológicos de presentación como apoyo a su discurso y mensaje |

||||

|

Niveles

de logro |

||||

|

1. Lee en todo momento desde el papel y apenas tiene

contacto visual con el público. |

2. Lee con mucha frecuencia el papel o la diapositiva y establece

en ocasiones contacto visual con el público. |

3. Depende de las diapositivas o transparencias como

también del papel, usándolos como guion cerrado y estableciendo de manera

frecuente contacto con el público. |

4. Las diapositivas o transparencias son un apoyo, que se

integran en la exposición y la complementan. |

|

|

Competencia 3. Sabe adaptarse al

público y establecer una interacción fluida con la audiencia. |

||||

|

Indicador

3.1. Motiva y capta el interés del público |

||||

|

Evidencia

3.1.1. Propiciar el interés y la participación de la audiencia. |

||||

|

Niveles

de logro |

||||

|

1. No transmite interés, ni anima a participar. |

2. Transmite algo de interés, aunque no anima a

participar. |

3.Transmite algo de interés y anima a participar en alguna

ocasión. |

4. Transmite interés, anima a la participación y lo logra. |

|

|

Indicador

3.2. Gestión y control de la audiencia |

||||

|

Evidencia 3.2.1. Maneja el turno de

preguntas, intervenciones de la audiencia y situaciones imprevistas |

||||

|

Niveles

de logro |

||||

|

1. No responde o desvía la atención, no reacciona a lo

imprevisto. |

2. Responde a las preguntas dudando. No reacciona ante los

imprevistos. |

3. Responde bien a las preguntas, pero utiliza mucho

tiempo. Titubea ante los imprevistos. |

4. Responde a las preguntas de manera correcta y con

cierta solvencia. Supera los imprevistos. |

|

|

Competencia 4. Ser capaz de

utilizar recursos tecnológicos de calidad integrados con el mensaje. |

||||

|

Indicador

4.1. Calidad de los recursos

tecnológicos |

||||

|

Evidencia

4.1.1. Elabora recursos tecnológicos de calidad |

||||

|

Niveles

de logro |

||||

|

1. No se usa ninguna presentación de diapositivas. |

2. Se usan diapositivas que no son atractivas ni claras

(tienen mucho texto y/o esquemas recargados). |

3. Se usa un número adecuado de diapositivas, atractivas,

claras y apropiadas. |

4. Se usan diapositivas atractivas, claras y apropiadas,

junto a otros recursos Multimedia (vídeos, webs…). |

|

|

Indicador 4.2.

Formalidades de la presentación. |

||||

|

Evidencia 4.2.1. Adaptación al tiempo y

otros requisitos de la exposición. |

||||

|

Niveles

de logro |

||||

|

1. No logra terminar la exposición y no deja tiempo para

las intervenciones. |

2. Logra terminar la exposición, aunque termina muy pronto

|

3. Se adapta al tiempo de presentación o intervenciones,

pero no deja suficiente tiempo para las preguntas. |

4. Se adapta al tiempo estipulado y deja suficiente tiempo

para las intervenciones. |

|

2.4. Metodología

de aplicación y recogida de datos

El diseño y aplicación de la

rúbrica fue planteado para el desarrollo de un proceso de evaluación con un

carácter formativo desde la participación activa y colaborativa del estudiante

(Cizek, 2010). Esto supuso en un primer momento antes de que se inicie el

proceso de enseñanza y más aún de evaluación, la puesta en conocimiento de la

rúbrica con los estudiantes el instrumento y metodología a seguir, para que la

rúbrica cumpliera su función de guía para “ayudar a aprender, condicionar un

estudio inteligente y corregir errores a tiempo” (Morales Vallejo, 2009, p.10).

Una vez concluida la evaluación de los docentes y los propios estudiantes

(autoevaluación) se exportaron los datos desde la plataforma de Corubric.com en

formato Excel para su análisis mediante SPSS.

Por último, y concluido todo

el proceso de enseñanza y evaluación, se solicitó a los estudiantes su

satisfacción respecto al proceso para obtener una retroalimentación y trabajar

en mejoras futuras. Para ello, se utilizó un instrumento validado de utilidad y

satisfacción en línea con Google Form (Martínez-Figueira & Raposo-Rivas,

2011), exportando los datos para su posterior análisis con SPSS.

3. Análisis y resultados

Para

el análisis de fiabilidad se propone el coeficiente alfa de Cronbach, esto para

saber hasta qué punto los ítems analizados están midiendo lo mismo. El análisis

se ha realizado en el software estadístico SPSS versión 21.0, para ítems del

cuestionario y con los datos de una muestra de 788 casos. Con respecto a la

consistencia interna se ha obtenido un coeficiente “alfa de Cronbach” para las

22 variables citadas anteriormente de (.934), tal y como se muestra en la Tabla

2.

Tabla

2

E-rúbrica

para evaluación de presentaciones orales. Fuente: CoRubric.com

|

N°. Casos |

N°. de elementos |

Alfa de Cronbach |

|

788 |

22 |

.934 |

Hemos

obtenido un valor del coeficiente “alfa de Cronbach” de .934, valor adecuado

que se encuentra por encima del valor 0,8 considerado como bueno en este tipo

de parámetros (Huh et al., 2006). Por ello, podemos concluir que los ítems del

cuestionario analizados constituyen una herramienta útil para el objetivo de la

investigación, obteniéndose una buena consistencia interna de éstos.

3.1. Validez de constructo

El propósito

fundamental de la validez de constructo es la de validar la teoría subyacente

al sistema de evaluación o medida. “Un instrumento de medida estará ligado al

sistema de constructos dentro del que fue construido; es este tipo de validez

el que nos indicará el grado en que el instrumento de evaluación es una medida

adecuada de constructo y hasta qué punto las hipótesis derivadas de él pueden

confirmarse mediante la utilización del instrumento” (Rosales, 1997, p. 167).

3.1.1. Análisis factorial confirmatorio de los ítems seleccionados

La

evidencia de la validez de constructo se obtiene mediante el análisis de

factores. Tal método agrupa los ítems en función de sus correlaciones, nos indica cuántas dimensiones integran a

una variable y qué ítems conforman a cada dimensión. Los ítems que conforman

una dimensión tienen altas correlaciones entre sí, agrupando estos ítems como

un factor. Los reactivos que no pertenezcan a una dimensión, quiere decir que

están aislados y no miden lo mismo que los demás ítems, por lo tanto deben

eliminarse. A continuación, desarrollamos el análisis factorial y proponemos

una nueva estructura en las dimensiones de nuestro estudio.

3.1.2. Extracción de

factores

El

modelo de extracción de factores implementado es el de componentes principales,

que consiste en llevar a cabo la combinación lineal de todas las variables de

modo que el primer componente principal sea una combinación que explique la

mayor proporción de varianza de la muestra, el segundo, la segunda mayor y así

sucesivamente. El objetivo es encontrar un reducido número de componentes que

expliquen el máximo de varianza total de las variables originales. En la Tabla

1 se observan cuántas dimensiones se forman cuando se analizan las preguntas

que se diseñaron. En nuestro caso, se analizaron 22 ítems para medir 4

factores. El análisis factorial confirmatorio nos recomienda 6 factores con una

varianza acumulada del 90.195%. La columna de componente refleja los 22 ítems

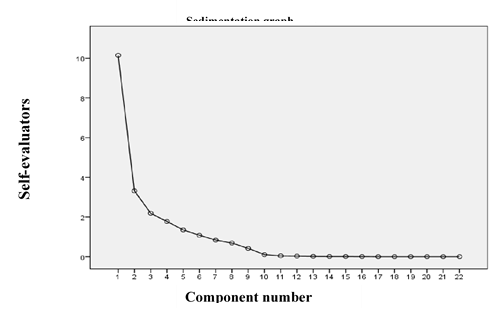

mencionados anteriormente, que igualmente se especifican en la Tabla 3.

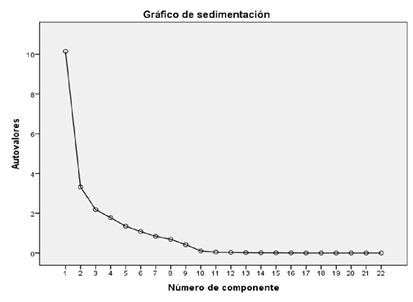

El

criterio de selección de factores ha sido tener autovalor mayor que 1. La

figura 1, muestra la representación gráfica de sedimentación de la magnitud de

los autovalores. En este caso el corte en la tendencia descendente sirve de

regla para la determinación del número óptimo de factores que deben estar

presentes en la solución. Como se puede observar a partir del tercer autovalor

la tendencia de la gráfica se suaviza, por lo que sólo se aceptarían los primeros

seis factores.

Gráfico de

Sedimentación

Varianza total

explica

|

Componente |

Autovalores iniciales |

Sumas de las saturaciones al cuadrado

de la extracción |

Suma de las saturaciones al

cuadrado de la rotación |

||||||

|

Total |

% de la varianza |

% acumulado |

Total |

% de la varianza |

% acumulado |

Total |

% de la varianza |

% acumulado |

|

|

1 |

10.143 |

46.106 |

46.106 |

10.143 |

46.106 |

46.106 |

4.656 |

21.163 |

21.163 |

|

2 |

3.314 |

15.064 |

61.170 |

3.314 |

15.064 |

61.170 |

3.495 |

15.886 |

37.049 |

|

3 |

2.188 |

9.943 |

71.113 |

2.188 |

9.943 |

71.113 |

3.385 |

15.387 |

52.436 |

|

4 |

1.772 |

8.054 |

79.167 |

1.772 |

8.054 |

79.167 |

3.023 |

13.742 |

66.178 |

|

5 |

1.348 |

6.127 |

85.294 |

1.348 |

6.127 |

85.294 |

2.886 |

13.117 |

79.295 |

|

6 |

1.078 |

4.901 |

90.195 |

1.078 |

4.901 |

90.195 |

2.398 |

10.900 |

90.195 |

|

7 |

.836 |

3.800 |

93.995 |

|

|

|

|

|

|

|

8 |

.686 |

3.120 |

97.115 |

|

|

|

|

|

|

|

9 |

.416 |

1.893 |

99.009 |

|

|

|

|

|

|

|

10 |

.104 |

.474 |

99.482 |

|

|

|

|

|

|

|

11 |

.042 |

.192 |

99.675 |

|

|

|

|

|

|

|

12 |

.029 |

.134 |

99.808 |

|

|

|

|

|

|

|

13 |

.016 |

.074 |

99.882 |

|

|

|

|

|

|

|

14 |

.010 |

.047 |

99.930 |

|

|

|

|

|

|

|

15 |

.009 |

.041 |

99.970 |

|

|

|

|

|

|

|

16 |

.006 |

.030 |

100.00 |

|

|

|

|

|

|

|

17 |

1.003E-013 |

1.014E-013 |

100.00 |

|

|

|

|

|

|

|

18 |

1.000E-013 |

1.002E-013 |

100.00 |

|

|

|

|

|

|

|

19 |

1.000E-013 |

1.001E-013 |

100.00 |

|

|

|

|

|

|

|

20 |

1.000E-013 |

1.000E-013 |

100.00 |

|

|

|

|

|

|

|

21 |

1.000E-013 |

1.000E-013 |

100.00 |

|

|

|

|

|

|

|

22 |

-1.000E-013 |

-1.000E-013 |

100.00 |

|

|

|

|

|

|

Nota: Método de extracción: Análisis de

componentes principales

A continuación,

usando el método Varimax, obtenemos la matriz de componentes rotados que nos

ayudó a ver qué variables se pueden considerar en los distintos factores,

además de qué variables podríamos desechar para estudios posteriores. La matriz

de componentes rotados recomienda que se agrupen las variables en seis factores

de la siguiente manera:

·

Factor

1 (relevancia y estructura de la información transmitida): Ítems 1,1.1, 1.1.1,

1.2 y 1.2.1.

·

Factor

2 (dominio de la exposición del mensaje ante el público): Ítems 2, 2.1, 2.1.1,

2.2 y 2.2.1.

·

Factor

3 (manejo de recursos tecnológicos de calidad en el discurso): Ítems 2.3,

2.3.1, 4.1 y 4.1.1.

·

Factor

4 (aspectos relacionados con los tiempos, formalidades e integración de

recursos). Ítems: 4, 4.2 y 4.2.1.

·

Factor

5 (adaptación y motivación de la audiencia). Ítems: 3, 3.1 y 3.1.1.

·

Factor

6 (control de las intervenciones de la audiencia). Ítems: 3.2 y 3.2.1.

3.2. Comparación de medias en función

del país de procedencia

En este

apartado vamos a analizar, a la vista de los datos obtenidos, si las medias de

los grupos formados por los integrantes de las distintas universidades de los

países del estudio muestran diferencias significativas Para ello, utilizamos el

test de ANOVA de un factor y tendremos en cuenta el factor “país de

procedencia” (hemos asignado el valor 1 a España, el valor 2 a Ecuador y el

valor 3 a Cuba). Aceptaremos que las

medias son diferentes y hay diferencias significativas según la universidad de

procedencia si el valor de significación es menor que 0.05 en el análisis de la

ANOVA.

Para

analizar de forma más detallada lo que ocurre en los ítems utilizamos la prueba

Post-Hoc de Tukey (incluido en el análisis de la ANOVA). Se observan

diferencias significativas entre los distintos países en todos los ítems

propuestos, siendo las medias de Cuba superiores a los otros dos países en

todos los ítems. A modo de ejemplo, mencionamos las comparaciones de medias en

algunos de estos ítems (elegimos un ítem de cada una de las dimensiones

propuestas en el cuestionario):

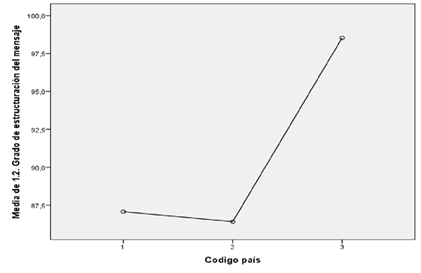

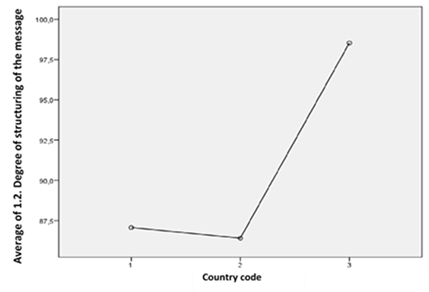

·

Respecto

al ítem 1.2 “grado de estructuración del mensaje”. La prueba Post-Hoc de Tukey

nos indica que hay diferencias significativas entre las parejas de países

España-Cuba y Ecuador-Cuba. Esto se observa claramente también en el siguiente

gráfico de medias en el que el país 3 (Cuba), supera ampliamente a España y

Ecuador.

Ítem 1.2 “grado

de estructuración del mensaje”

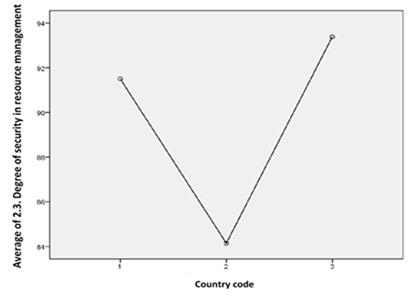

·

Respecto

al ítem 2.3 “grado de seguridad en el manejo de recursos” la prueba Post-Hoc de

Tukey nos indica que hay diferencias significativas entre las parejas de países

España-Ecuador y Ecuador-Cuba. Esto se observa claramente también en el

siguiente gráfico de medias en el que el país 2 (Ecuador), tiene una media

significativamente menor que España y Cuba.

Ítem 2.3 “grado

de seguridad en el manejo de recursos”

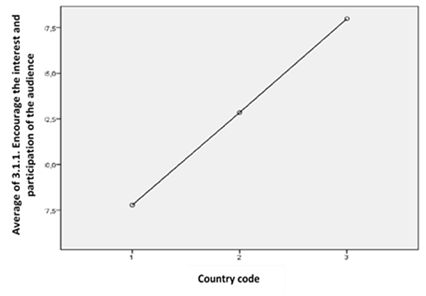

·

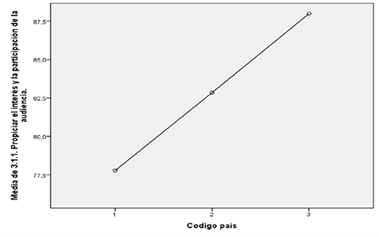

Respecto

al ítem 3.1.1 “propiciar el interés y la participación de la audiencia” la

prueba Post-Hoc de Tukey nos indica que hay diferencias significativas entre

las parejas de países España-Cuba y Ecuador-Cuba. Esto se observa claramente

también en el siguiente gráfico de medias en el que el país 3 (Cuba), tiene una

media significativamente mayor que España.

Ítem 3.1.1

“propiciar el interés y la participación de la audiencia”

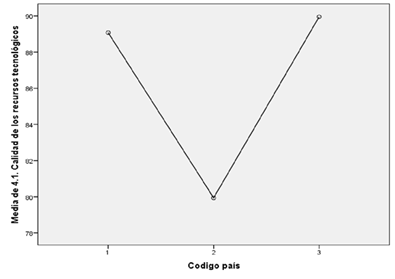

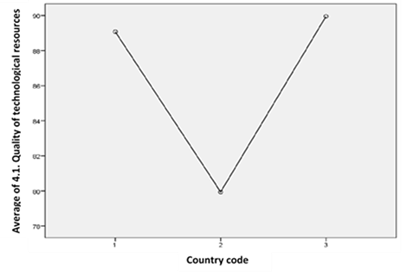

·

Respecto

al ítem 4.1 “calidad de los recursos tecnológicos”, la prueba Post-Hoc de Tukey nos indica que hay diferencias

significativas entre las parejas de países España-Ecuador y Ecuador-Cuba. Esto

se observa claramente también en el siguiente gráfico de medias en el que el

país 2 (Ecuador), tiene una media significativamente menor que España y Cuba.

Ítem 4.1 “calidad

de los recursos tecnológicos”

3.3. Análisis de las diferencias

entre países según evaluaciones docentes, autoevaluaciones docentes, autoevaluaciones

y pares

En

este apartado vamos a analizar, a la vista de los datos obtenidos, si las

medias de los grupos formados por los diferentes tipos de evaluaciones

(evaluación de los docentes, autoevaluación y evaluación por pares por los

estudiantes) en los distintos países muestran diferencias significativas. Para

ello, vamos a utilizar el test de ANOVA de un factor y tendremos en cuenta el

factor “código evaluador” (hemos de reseñar que en España y Ecuador se han

realizado los tres tipos de evaluaciones, mientras que en Cuba se realizaron

sólo evaluaciones de pares y del profesor).

Aceptaremos que las medias son diferentes y hay diferencias

significativas según la universidad de procedencia si el valor de significación

es menor que 0.05 en el análisis de la ANOVA.

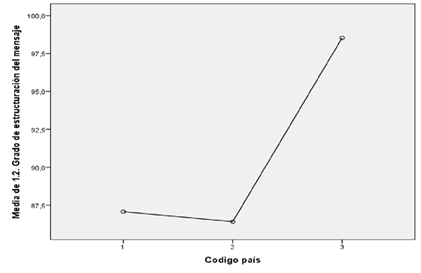

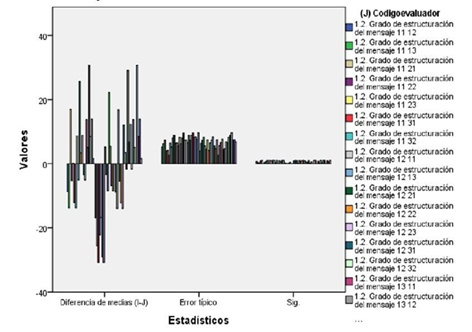

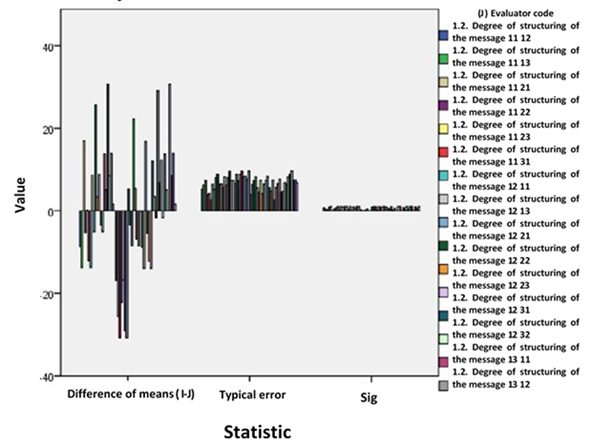

En

suma, hemos de reseñar que en todos los ítems se observa que las evaluaciones

de pares de España y Ecuador obtienen peores resultados que las evaluaciones de

los docentes. En el caso de España, la tendencia es que los pares tienen peores

resultados que las evaluaciones del profesor, mientras que las autoevaluaciones

son las que mejores resultados obtienen.

Ítem 1.2 “grado

de estructuración del mensaje” prueba Post-Hoc de Tukey

3.4. Análisis de la satisfacción de

los estudiantes con la metodología de la rúbrica

Una

vez recogido los datos desde el cuestionario en línea con el instrumento

validado por Martínez-Figueira y Raposo-Rivas, (2011), se comparan los

resultados obtenidos sobre 11 ítems que recogen las posibilidades de uso de la

rúbrica con tres posibilidades de respuestas (Totalmente en desacuerdo, en

desacuerdo, de acuerdo y Totalmente de acuerdo) junto con preguntas abiertas

sobre las ventajas y desventajas de su utilización. En la siguiente tabla se

plasman los porcentajes de estudiantes que estaban de acuerdo o totalmente de

acuerdo con la afirmación sobre la rúbrica, junto con una síntesis de las

respuestas abiertas. Las muestras de estudiantes eran respectivamente 16, 19 y

26 para Cuba, Ecuador y España.

Como

se puede observar en la tabla, aunque las diferencias no son muy

significativas, sí se aprecian ligeras diferencias a la baja con los

estudiantes españoles. También hemos analizado las ventajas y desventajas de la

rúbrica que los estudiantes observan. En este sentido podemos sintetizar lo

siguiente (comentarios comunes en los tres países):

·

El

uso de rúbricas es altamente aceptado porque proporciona retroalimentación y

objetividad en la calificación, además de rapidez y comodidad en su uso.

·

A

modo de desventajas, los estudiantes expresan la complejidad de la rúbrica, la

falta de claridad de algunos ítems y su extensión.

·

Inciden

de nuevo en que la rúbrica proporciona feedback, objetividad y claridad en el

proceso de evaluación, por lo que recomiendan al docente siga usando esta

metodología.

·

También

expresan su deseo que se extienda el uso de rúbricas a contenidos teóricos y

otras actividades formativas.

Respuesta y

comparativa sobre la satisfacción de los estudiantes

|

|

Cuba |

Ecuador |

España |

|

La rúbrica permite una

evaluación más objetiva. |

100,00% |

100,00% |

87,50% |

|

La rúbrica le obliga al docente

a clarificar sus criterios de evaluación. |

93,75% |

94,74% |

96,88% |

|

La rúbrica permite dar a

conocer lo que se espera. |

100,00% |

100,00% |

93,75% |

|

La rúbrica nos proporciona

retroalimentación del desarrollo del trabajo. |

100,00% |

89,47% |

90,63% |

|

La rúbrica nos ayuda a

comprender las cualidades que el trabajo debe poseer. |

100,00% |

94,74% |

90,63% |

|

La rúbrica nos muestra cómo

seremos evaluados |

100,00% |

100,00% |

87,50% |

|

La rúbrica permite

autoevaluarnos. |

100,00% |

94,74% |

96,88% |

|

La rúbrica nos informa de la

ponderación de los componentes en relación a la nota total. |

100,00% |

100,00% |

90,63% |

|

La rúbrica permite constatar el

nivel de competencia adquirida. |

81,25% |

94,74% |

78,13% |

|

La rúbrica permite evaluar a

todos los grupos por igual |

93,75% |

100,00% |

93,75% |

|

La rúbrica evidencia el trabajo

realizado. |

100,00% |

94,74% |

71,88% |

4.

Discusión y conclusiones

El estudio obtuvo como primer objetivo la creación y

validación a doble vuelta por miembros del proyecto del diseño de la rúbrica

para evaluar las competencias orales en las presentaciones de los estudiantes.

Después de dos fases con el método Delphi se obtuvo una rúbrica con más del 80%

de indicadores y elementos consensuados.

Con

la rúbrica digital diseñada en la plataforma Corubric.com[1] se logró agrupar

indicadores y criterios de calidad que tributan, de manera dinámica, a la

evaluación de competencias de presentaciones orales. La rúbrica digital

permitió el acceso desde diferentes regiones y su integración a procesos de

evaluación a distancia, además de su exportación de datos para su análisis.

En el

segundo objetivo, los resultados de la experimentación en las universidades

participantes demuestran que el contenido de la rúbrica creada puede ser

implementada en diferentes contextos, lo cual se pudo constatar en los valores

de significación presentados por la correlación de cada uno de los indicadores

que describen las competencias.

·

En el

análisis de la fiabilidad de éstos el parámetro alfa de Cronbach nos da un

valor de 0.934, siendo un valor muy aceptable cercano a 1, por ello podemos

concluir que los ítems analizados constituyen una herramienta útil para el

objetivo de la investigación, obteniéndose una buena consistencia interna, y

por lo tanto, un instrumento válido y confiable como otros estudios (Hafner

& Hafner, 2003); en nuestro caso, para la evaluación oral (García-Ros,

2011; Bindayel, 2017; Galván-Sánchez et al., 2017; Murillo-Zamorano &

Montanero, 2017) en el contexto geográfico diferenciador IEC.

·

A

pesar de disponer de una rúbrica base común fiable, el análisis factorial

confirmatorio realizado recomienda una nueva reconsideración de las dimensiones

propuestas, pasando de 4 a 6, añadiendo nuevas dimensiones a las propuestas que

se atenderán en un futuro rediseño de la rúbrica.

·

El

test ANOVA de un factor arroja diferencias significativas entre los distintos

países (Cuba, Ecuador y España) en todos los ítems propuestos, lo que indica

que la rúbrica arroja información significativa para que los docentes y

estudiantes conozcan la situación de los grupos según qué dimensiones e

indicadores. Por lo que, la rúbrica diseñada ofreció una oportunidad para la

retroinformación y autoevaluación como coinciden con meta-estudios en la

literatura (Jonsson & Svingby, 2007; De Grez, Valcke & Roozen, 2012).

·

Con

la prueba Post-Hoc de Tukey encontramos que en todos los ítems se observa que

las evaluaciones de pares de España y Ecuador obtienen peores resultados que

las evaluaciones de los docentes, resultados que coinciden con otros estudios

donde los estudiantes en un primer momento de evaluación suelen ser más

exigentes que los docentes, pero con más evaluaciones suelen acercarse y

aproximarse a las del docente y obtienen mejores resultados en los trabajos

presentados por el hecho de ser evaluados por pares (Greenberg, 2015). Por lo

que será interesante ampliar en el futuro el estudio a varias evaluaciones o

evaluaciones progresivas y continua.

·

No

obstante, las autoevaluaciones fueron las que mejores resultados obtuvieron

comparándose con las del docente, entendemos que por las mismas razones que la

evaluación de pares, necesitan más evaluaciones para comprender el sentido de

estas prácticas, y cambiar también los estudiantes el concepto de evaluación

como estrategia para aprender no solo para calificar.

·

En

otros trabajos se ha visto que hay diferencias significativas en la evaluación

entre docentes y estudiantes (Meseguer-Dueñas, Vidaurre, Molina-Mateo, Riera

& Sala, 2018), pero mostraban correlación positiva de forma global solo

cuando se eliminaban ciertos indicadores (p.e. “uso de recursos auxiliares”).

Es decir, dependiendo de la fuente de retroalimentación puede mostrar

diferentes impactos en la competencia oral de presentaciones, como así se

comprobó en el estudio de Van Ginkel et al., (2017); por lo que, después de

nuestro estudio y la literatura especializada, aún queda conocer con más

profundidad la repercusión de las diferentes fuentes de evaluaciones, como el

impacto de las recomendaciones de los docentes frente a las de los estudiantes.

Finalmente,

y para el tercer objetivo, los criterios de satisfacción expresados por los

estudiantes evidencian la aceptación de esta herramienta y metodología, la cual

se les presenta como un proceso de evaluación confiable (Valverde Berrocoso

& Ciudad Gómez, 2014). Los resultados coinciden con los hallados por

Gallego-Arrufat y Raposo-Rivas (2014) en cuanto al sentimiento positivo de los

estudiantes más comprometidos con el proceso de evaluación.

Disponer

de un instrumento validado no es suficiente para garantizar la equidad de los

evaluadores frente a una misma tarea, como nos indica el trabajo de

Fernández-Alonso, Woitschach y Muñiz (2019) cuando señala la necesidad de

utilizar correctores y escalas de dificultad como el modelo de Rasch adecuadas

a los contextos de aplicación. Por lo que, necesitamos en el futuro reeditar la

rúbrica según el análisis factorial, aplicar en más contextos diferentes del

Espacio Iberoamericano del Conocimiento, emplear diferentes metodologías de

evaluación formativa a las planteadas en este estudio (evaluación ipsativa,

evaluación de equipos…) y definir qué correctores aplicar con el modelo de Rasch

según el tipo de tareas.

Assessment oral competence with digital rubrics for the

Ibero-American Knowledge Space

1. Introduction

The competences for communication

and collaboration that we find in the European Framework of Digital Competences

for Citizens -DigComp-, and the digital competences of teachers in the INTEF

(2017), place communicative competence, especially oral communication, and more

recently of academic and scientific writing (Greenberg, 2015; Rakedzon &

Baram-Tsabari, 2017), as a priority topic of attention in the initial training

of teachers.

The development of competences

for the oral presentation of work by students is an essential objective in

higher education worldwide, where these competences are included in the

curricular framework of most study plans (Van Ginkel et al., 2015). Here, the

development of communication skills, the correct use of language and oral

expression by future education professionals and their integration in academic,

work and research activities are valued. For Fernández García et al. (2008),

this is a basic competence in the practice of all professionals whose work

involves interaction with people in different contexts. Hence the need to

develop this competence to perfect, improve and know the ways to become

effective communicators (Fernández López, 2007), in an increasingly digital and

multicultural world.

In researches consulted, they

conclude that many of the university students feel that they do not have oral

expression skills in their presentations, both in interactive situations

(conversations, dialogues, debates ...), and in non-interactive situations

(oral reports, dissertations ...) (Roldán, 2001). Similarly, Arráez-Aybar et

al. (2008) points out that “oral communication is deficient in a large number

of university students, who are not used to speaking in public and explaining

their points of view with a language adapted to the professional environment”

(p. 171).

Faced with this situation, two

of the basic questions that every teacher asks when he tries to improve these

competences in his students consists of: on the one hand, starting from a

clear, pertinent and precise definition of the competence that we wish to

improve; and, on the other hand, establish an efficient formula that allows us

to evaluate the progress of our students thanks to the training actions that

are proposed.

Regarding the first aspect, we

can consider the works of Van Ginkel, Gulikers, Biemans and Mulder, (2015) for

their synthesis and complexity, when they define communicative competence as a

“combination of knowledge, skills, and attitudes necessary to speak in public,

in order to inform, express oneself, establish relationships and persuade, to

which it confers the value of interrelation and mastery of cognitive,

behavioral and affective elements” (p.63).

Regarding the second topic,

one of the methodologies that have shown effectiveness and efficiency for the

formative evaluation of this competence has been the use of rubrics in

different teaching subjects, areas and contexts, being an evaluation

methodology as well as an instrument of self-management of one's own evaluation

that represents an opportunity to attend the evaluation of communicative

competence (Gallego-Arrufat & Raposo-Rivas, 2014; Hima & Saputro, 2017)

with many different possibilities for its design (Dawson, 2017).

In their applications in the

field of university teaching, rubrics have become digital, showing high levels

of acceptance given their status as guides while “helping to assign different

weights to each task or subtask performed in each activity. (…) students

estimate their own qualification of both individual and collaborative group

practices, and their level of acquired competencies” (Villalustre Martínez

& del Moral Pérez, 2010, p.98). This quality of digital rubrics allows

self-evaluation and formative evaluation (peer evaluation, team evaluation,

self-evaluation, ipsative evaluation ...) due to its speed and constant

feedback, it represents one of the methodologies most accepted by students, as

long as they serve them for self-training, guiding their learning process

(Martínez-Figueira, Tellado-Gónzalez & Raposo-Rivas, 2013).

The results of research on the

satisfaction of students in the use of digital rubrics are those that reinforce

these advantages, with evaluations by students such as: “… interesting,

motivating, encourages participation, encourages both cooperative work and

co-evaluation (…) consider the experience a success and appreciate the feedback

received as a guide to improve their next performance” (Gallego-Arrufat &

Raposo-Rivas, 2014, p.211). Also, Serrano-Angulo and Cebrián-Robles (2014)

present high results of reliability coefficient in the use of digital rubrics;

as well as, in the comparison of satisfaction with other tools that show values

above the average.

One of the most used exercises

to promote this communicative competence are the expositions of works and

projects in public by students. For university education, communication skills

are recognized by Murillo-Zamorano and Montanero (2017), as the ability to

present information in public in a clear and eloquent way adjusted to different

academic and professional contexts. These authors in their research present

different aspects to take into account when evaluating oral presentations:

•

Contents of the presentation

taking into account the context and the audience.

•

Have a clear objective and a

correct articulation and organization of ideas.

•

Use electronic and audiovisual

material of effective and adequate support.

•

Appropriate use of language,

as well as other elements such as rhythm, tone and volume.

•

Articulation and other non-verbal

aspects such as gestures and postures.

In relation to these

dimensions and criteria for the development of expository oral competence, in

the consulted bibliography we find that García-Ros (2011) proposes four

dimensions to be evaluated with 12 criteria related to: content, practical

application, visual support and verbal skills. For their part, Verano-Tacoronte

et al. (2016) propose the adaptation of the contents of the presentation and

bibliographic references, as well as the formal aspects and their relationship

with the correction of visual means of support, mastery of physical space and

eloquence; as well as the proper time management. And later in another work,

Galván-Sánchez et al. (2017) use as criteria and variables for evaluating oral

competence: order and clarity, use of audiovisual supports and others,

distribution of time, body and oral language.

As can be seen in the previous

proposals, and despite being pertinent indicators, there is no consensus

regarding their number, and even more so regarding the criteria to develop an

assessment instrument for oral competence. However, we do start from the

agreement as to which are the basic indicators. Therefore, it would be

necessary to build a common instrument from these indicators that is reified

into clear and precise, measurable and quantifiable criteria for differentiated

geographic contexts and reference frameworks such as the Ibero-American

Knowledge Space.

2. Methodology

In line with the need to

design training actions that take into account the evaluation of communication

skills, especially oral presentations. The Ibero-American Higher Education

Network -Resib- [http://resib.uma.es/] raised the need to build a validated

rubric among its members to address skills in oral expression of projects and

work of students in public, which would serve as the basis for its application

within the Ibero-American Space of Knowledge. In response to this need, the

project entitled: Experimentation and evaluation of competences for the

presentation of oral works with digital rubrics -PocoRubric-

[https://bit.ly/2ZEWT4Z] (2017-2018) was developed with the participation of

eight universities and five Ibero-American countries. At the beginning, we

started from the existing literature and designed a base rubric for a context

of application in areas of initial training, such as: the expositions of oral

projects in class, the defense of Final Projects of the Degree and the Final

Projects of the Master (Cebrián -Robles, 2017). After its validation by Delphi

methods, only its application to different contexts and areas remained, in

addition to using different formative training methodologies (peer assessment,

self-assessment, ipsative assessment, team assessment…).

The present study experimented

and evaluated with quantitative and qualitative designs the application of the

rubric in the oral presentations of the students, and in different geographical

contexts of three different countries (Cuba, Ecuador and Spain) in the degrees

of Education and Social Sciences. After this application and evaluation, an

analysis of satisfaction with the students themselves was carried out.

The methodological design was

mixed (quantitative and qualitative) according to the objectives, such as: for

objective 1, a double-round Delphi methodology design was developed; For

objective 2, the impact of the evaluations (teacher evaluation, self-evaluation

and peer evaluations) offered by the rubric with a correlational design of

means according to countries was analyzed. Finally, and for objective 3 of

satisfaction, a validated instrument was applied, together with a descriptive

and qualitative analysis.

2.1.

Objetives of the study

•

Design and validation of a

rubric to evaluate the presentation of projects and oral works by the students

of the Ibero-American Knowledge Space.

•

Experimentation of the rubric

designed for formative evaluation (teacher evaluation, self-evaluation and peer

evaluation) in differentiated geographical contexts.

•

Satisfaction assessment by the

students on the rubric and the experimented methodology.

2.2. Rubric design validation

The Delphi methodology has

been used to develop instruments such as rubrics (Merma Molina, Peña Alfaro

& Peña Alfaro, 2017; Tobón, Pimienta-Prieto, Herrera-Meza, Juárez Hernández

& Hernández-Mosqueda, 2018), by offering a consensus agreement on the

identification, selection and assessment of the evaluation indicators, the main

axis of said instrument.

A Delphi methodology (García

Martínez, Aquino Zúñiga, Guzmán Sala & Medina Meléndez, 2012; Cabero

Almenara, 2014; Cabero Almenara et al., 2009; Blanco-López et al., 2015) was

used in two rounds, following other works already carried out in previous

projects and other authors (Tejada-Fernández, Serrano-Angulo, Ruiz-Bueno &

Cebrián-Robles, 2015), where a first proposal or first phase was designed,

which was shared through a document on Google drive, in order through their

opinions to make adjustments for relevance, adequacy and accuracy of the

indicators, criteria and evidence of the rubric. Likewise, the semantic field

of certain terms and words used according to each country had to be redefined.

In a second phase, and quantitatively and qualitatively analyzed the results of

the experts, eliminating duplications and selecting those that obtained 80%

consensus, the result was the proposal that is presented in Table 1.

The final evaluation rubric

consists of 22 items divided according to 4 dimensions: a) relevance and

structure of the information transmitted; b) domain of the presentation of the

message to the public; c) audience management, motivation and control and d)

quality of resources used and time management.

E-rubric for evaluation of oral presentations. Source: CoRubric.com

|

Competence 1. Presents

enough relevant and well structured content |

||||

|

Indicator 1.1. Quantity and relevance of the

information |

||||

|

Evidence. 1.1.1. Presents adequate and accurate

information from a scientific point of view |

||||

|

Achievement levels |

||||

|

1. It has led to a different issue from the one

raised, with conceptual errors. |

2. It has focused on secondary aspects, ignoring

more than two important aspects. |

3. He has focused on the main points, although

he has forgotten one or two. |

4. It treats all the most important elements of

the subject in an adequate and comprehensive way. |

|

|

Indicator 1.2. Degree of structuring of the

message |

||||

|

Evidence 1.2.1. Present a structured message |

||||

|

Achievement levels |

||||

|

1.Unstructured message. Move from one topic to

another. You

can't go on. |

2.Without clear structure, it is difficult to

follow. |

3. With structure, although it is not very

coherent. |

4. With a coherent and clear structure (not

confusing) |

|

|

Competence 2. Knows how

to present a message in front of an audience with confidence |

||||

|

Indicator 2.1. Oral expression |

||||

|

Evidence 2.1.1. Maintains a clear voice and good

intonation at all times |

||||

|

Achievement levels |

||||

|

1.Unintelligible. Very low voice volume and

monotonous tone. Bad

intonation. |

2.It is misunderstood. Low voice volume with

poor intonation and uneven pitch. |

3. It is understood to be regular. Normal voice

volume and / or regular intonation. |

4. It is well understood. Normal, clear voice

volume and good intonation. |

|

|

Indicator 2.2. Gestural expression and

disposition before the public |

||||

|

Evidence 2.2.1. He moves through space with

dominance and relaxed |

||||

|

Achievement levels |

||||

|

1. Shows stiffness, nervous and uncontrolled

gestures. It

does not move. |

2. It shows stiffness, although it controls

nervousness. It

does not move. |

3. At times it shows relaxation. Something moves. |

4. He is relaxed and moves freely with ease in

space. |

|

|

Indicator 2.3. Degree of security in resource

management |

||||

|

Evidence 2.3.1. Uses presentation technology resources

to support your speech and message |

||||

|

Achievement levels |

||||

|

1. He reads at all times from paper and has

hardly any eye contact with the audience. |

2. Read the paper or slide very often, and

occasionally make eye contact with the audience. |

3. It depends on the slides or transparencies as

well as on the paper, using them as a closed script and establishing frequent

contact with the public. |

4. The slides or transparencies are a support,

which are integrated into the exhibition and complement it. |

|

|

Competence 3. Knows how

to adapt to the public and establish a fluid interaction with the audience. |

||||

|

Indicator 3.1. Motivate and engage the public |

||||

|

Evidence 3.1.1. Encourage the interest and

participation of the audience. |

||||

|

Achievement levels |

||||

|

1. It does not convey interest, nor does it

encourage participation. |

2. It conveys something of interest, although it

does not encourage participation. |

3. Convey something of interest and encourage

participation on occasion. |

4. It conveys interest, encourages participation

and achieves it. |

|

|

Indicator 3.2. Audience management and control |

||||

|

Evidence 3.2.1. Handles question time, audience

interventions and unforeseen situations |

||||

|

Achievement levels |

||||

|

1. Does not respond or divert attention, does

not react to the unexpected. |

2. Answer questions with hesitation. Does not

react to the unexpected. |

3. Answer questions well, but use a lot of time.

He hesitates before the unforeseen. |

4. Answer the questions correctly and with some

solvency. Overcome

the unforeseen. |

|

|

Competence 4. Be able to

use quality technological resources integrated with the message. |

||||

|

Indicator 4.1. Quality of technological

resources |

||||

|

Evidence 4.1.1. Produce quality technological

resources |

||||

|

Achievement levels |

||||

|

1. No slide show is used. |

2. Slides are used that are not attractive or clear

(they have a lot of text and / or ornate diagrams). |

3. An adequate number of slides are used,

attractive, clear and appropriate. |

4. Attractive, clear and appropriate slides are

used, along with other Multimedia resources (videos, websites ...) |

|

|

Indicator 4.2. Presentation formalities. |

||||

|

Evidence 4.2.1. Adaptation to weather and other

requirements of the exhibition. |

||||

|

Achievement levels |

||||

|

1. He fails to finish the exhibition and leaves no

time for interventions. |

2. He manages to finish the exhibition, although

it ends very soon |

3. It adapts to the presentation time or

interventions, but does not leave enough time for questions. |

4. It adapts to the stipulated time and leaves

enough time for interventions. |

|

2.3. Ibero-American teaching application contexts

The number of students from the

three groups and countries totaled 90 (17 Cuba, 47 Ecuador and 26 Spain). The

sample analyzed for the study of validity and reliability consists of 788

results of total evaluations of teachers to the oral presentations of projects,

such as self-evaluations and peer evaluations by students, being by evaluation

methodologies 90 evaluations of teachers, 61 self-assessments and 637 peer

assessments by students.

2.4. Methodology of application and data collection

The

design and application of the rubric was proposed for the development of an

evaluation process with a formative nature from the active and collaborative

participation of the student (Cizek, 2010). This meant, at first, before the

teaching process began and even more so the evaluation process, the

introduction of the rubric with the students, the instrument and methodology to

follow, so that the rubric would fulfill its role as a guide to “help to learn,

condition an intelligent study and correct mistakes in time” (Morales Vallejo,

2009, p.10). Once the evaluation of the teachers and the students themselves

(self-evaluation) was completed, the data was exported from the Corubric.com

platform in Excel format for analysis using SPSS.

Finally,

and after the entire teaching and evaluation process, the students were asked

for their satisfaction regarding the process to obtain feedback and work on

future improvements. To do this, a validated utility and satisfaction

instrument was used online with Google Form (Martínez-Figueira &

Raposo-Rivas, 2011), exporting the data for subsequent analysis with SPSS.

3. Analysis and results

For the reliability analysis,

the Cronbach's alpha coefficient is proposed, this to know to what extent the

items analyzed are measuring the same. The analysis was carried out in the

statistical software SPSS version 21.0, for items of the questionnaire and with

data from a sample of 788 cases. Regarding internal consistency, a “Cronbach's

alpha” coefficient has been obtained for the 22 variables mentioned above of

(.934), as shown in Table 2.

Reliability statistics

|

No. Cases |

No. of elements |

Cronbach's alpha |

|

788 |

22 |

.934 |

We have obtained a value of

the "Cronbach's alpha" coefficient of .934, an adequate value that is

above the 0.8 value considered as good in this type of parameters (Huh, Delorme

& Reid, 2006). Therefore, we can conclude that the analyzed items of the

questionnaire constitute a useful tool for the purpose of the research,

obtaining a good internal consistency of these.

3.1. Construct validity

The fundamental purpose of

construct validity is to validate the theory underlying the evaluation or

measurement system. “A measuring instrument will be linked to the system of

constructs within which it was built; it is this type of validity that will

indicate the degree to which the evaluation instrument is an adequate measure

of the construct and to what extent the hypotheses derived from it can be

confirmed by using the instrument” (Rosales, 1997, p. 167).

3.1.1. Confirmatory

factor analysis of the selected items

The evidence of construct

validity is obtained by factor analysis. This method groups the items according

to their correlations, it tells us how many dimensions make up a variable and

which items make up each dimension. The items that make up a dimension have

high correlations with each other, grouping these items as a factor. The items

that do not belong to a dimension, means that they are isolated and do not

measure the same as the other items, therefore they must be eliminated. Next,

we develop the factor analysis and propose a new structure in the dimensions of

our study.

3.1.2. Factor

extraction

The factor extraction model

implemented is that of principal components, which consists of carrying out the

linear combination of all the variables so that the first principal component

is a combination that explains the highest proportion of variance in the

sample, the second, the second major and so on. The objective is to find a

reduced number of components that explain the maximum total variance of the

original variables. Table 1 shows how many dimensions are formed when the

questions that were designed are analyzed. In our case, 22 items were analyzed

to measure 4 factors. The confirmatory factor analysis recommends 6 factors

with a cumulative variance of 90.195%. The component column reflects the 22

items mentioned above, which are also specified in Table 3.

Total variance explains

|

Component |

Initial eigenvalues |

Sums of the squared saturations of the extraction |

Sum of the squared saturations of the rotation |

||||||

|

Total |

% of the variance |

% accumulated |

Total |

% of the variance |

% accumulated |

Total |

% of the variance |

% accumulated |

|

|

1 |

10.143 |

46.106 |

46.106 |

10.143 |

46.106 |

46.106 |

4.656 |

21.163 |

21.163 |

|

2 |

3.314 |

15.064 |

61.170 |

3.314 |

15.064 |

61.170 |

3.495 |

15.886 |

37.049 |

|

3 |

2.188 |

9.943 |

71.113 |

2.188 |

9.943 |

71.113 |

3.385 |

15.387 |

52.436 |

|

4 |

1.772 |

8.054 |

79.167 |

1.772 |

8.054 |

79.167 |

3.023 |

13.742 |

66.178 |

|

5 |

1.348 |

6.127 |

85.294 |

1.348 |

6.127 |

85.294 |

2.886 |

13.117 |

79.295 |

|

6 |

1.078 |

4.901 |

90.195 |

1.078 |

4.901 |

90.195 |

2.398 |

10.900 |

90.195 |

|

7 |

.836 |

3.800 |

93.995 |

|

|

|

|

|

|

|

8 |

.686 |

3.120 |

97.115 |

|

|

|

|

|

|

|

9 |

.416 |

1.893 |

99.009 |

|

|

|

|

|

|

|

10 |

.104 |

.474 |

99.482 |

|

|

|

|

|

|

|

11 |

.042 |

.192 |

99.675 |

|

|

|

|

|

|

|

12 |

.029 |

.134 |

99.808 |

|

|

|

|

|

|

|

13 |

.016 |

.074 |

99.882 |

|

|

|

|

|

|

|

14 |

.010 |

.047 |

99.930 |

|

|

|

|

|

|

|

15 |

.009 |

.041 |

99.970 |

|

|

|

|

|

|

|

16 |

.006 |

.030 |

100.00 |

|

|

|

|

|

|

|

17 |

1.003E-013 |

1.014E-013 |

100.00 |

|

|

|

|

|

|

|

18 |

1.000E-013 |

1.002E-013 |

100.00 |

|

|

|

|

|

|

|

19 |

1.000E-013 |

1.001E-013 |

100.00 |

|

|

|

|

|

|

|

20 |

1.000E-013 |

1.000E-013 |

100.00 |

|

|

|

|

|

|

|

21 |

1.000E-013 |

1.000E-013 |

100.00 |

|

|

|

|

|

|

|

22 |

-1.000E-013 |

-1.000E-013 |

100.00 |

|

|

|

|

|

|

Note: Extraction method:

Principal component analysis

The factor selection criterion

has been to have an eigenvalue greater than 1. Figure 1 shows the graphical

representation of sedimentation of the magnitude of the eigenvalues. In this

case, the cut in the downward trend serves as a rule for determining the

optimal number of factors that must be present in the solution. As can be seen

from the third eigenvalue, the trend of the graph is smoothed, so that only the

first six factors would be accepted.

Sedimentation

Chart

Next, using the Varimax method, we obtain the matrix

of rotated components that helped us to see which variables can be considered in

the different factors, as well as which variables we could discard for further

studies. The Rotated Component Matrix recommends grouping variables into six

factors as follows:

·

Factor 1 (relevance and

structure of the information transmitted): Items 1,1.1, 1.1.1, 1.2 and 1.2.1.

·

Factor 2 (domain of the

presentation of the message to the public): Items 2, 2.1, 2.1.1, 2.2 and 2.2.1.

·

Factor 3 (management of quality

technological resources in speech): Items 2.3, 2.3.1, 4.1 and 4.1.1.

·

Factor 4 (aspects related to

time, formalities and integration of resources). Items: 4, 4.2 and 4.2.1.

·

Factor 5 (adaptation and

motivation of the audience). Items:

3, 3.1 and 3.1.1.

·

Factor 6 (control of audience

interventions). Items:

3.2 and 3.2.1.

3.2. Comparison of means

according to the country of origin

In this section we are going

to analyze, in view of the data obtained, if the means of the groups formed by

the members of the different universities in the study countries show

significant differences. To do this, we use the one-way ANOVA test and we will

have take into account the factor “country of origin” (we have assigned a value

of 1 to Spain, a value of 2 to Ecuador and a value of 3 to Cuba). We will

accept that the means are different and there are significant differences

according to the university of origin if the significance value is less than

0.05 in the ANOVA analysis.

To analyze in more detail what

happens in the items, we used Tukey's Post-Hoc test (included in the ANOVA

analysis). Significant differences are observed between the different countries

in all the proposed items, the means for Cuba being higher than the other two

countries in all the items. As an example, we mention the comparisons of means

in some of these items (we chose one item from each of the dimensions proposed

in the questionnaire):

·

Regarding item 1.2 “degree of

structuring of the message”. Tukey's Post-Hoc test indicates that there are

significant differences between the pairs of countries Spain-Cuba and

Ecuador-Cuba. This is also clearly observed in the following graph of means in

which country 3 (Cuba) widely exceeds Spain and Ecuador.

Figure 2

item

1.2 "degree of structuring of the message"

·

Regarding item 2.3 “degree of

security in resource management”, the Tukey Post-Hoc test indicates that there

are significant differences between the pairs of countries Spain-Ecuador and

Ecuador-Cuba. This is also clearly observed in the following graph of means in

which country 2 (Ecuador) has a significantly lower average than Spain and