Propósitos de uso de tecnologías digitales en estudiantes

de pedagogía chilenos: Construcción de una escala basada en competencias

digitales

Chilean student teachers’ purposes of use of digital

technologies: Construction of a scale based on digital competences

Dr. Cristian Cerda González. Profesor Asociado. Universidad de La

Frontera. Chile

Dr. Cristian Cerda González. Profesor Asociado. Universidad de La

Frontera. Chile

Dra. Miriam León Herrera. Profesora. Universidad de La

Frontera. Chile

Dra. Miriam León Herrera. Profesora. Universidad de La

Frontera. Chile

Dr. José Luis Saiz Vidallet. Profesor Titular.

Universidad de La

Frontera. Chile

Dr. José Luis Saiz Vidallet. Profesor Titular.

Universidad de La

Frontera. Chile

Mgtr. Lorena Villegas Medrano. Profesora Asistente.

Universidad Católica de Temuco. Chile

Mgtr. Lorena Villegas Medrano. Profesora Asistente.

Universidad Católica de Temuco. Chile

Recibido:

2022/01/29 Revisado 2022/02/01 Aceptado: 2022/03/03 Preprint: 2022/04/29

Publicado: 2022/05/01

Cómo citar este artículo:

Cerda-González, C., León-Herrera,

M., Saiz-Villadet, J.L., & Villegas-Medrano, L. (2022). Propósitos de uso

de tecnologías digitales en estudiantes de pedagogía chilenos: Construcción de

una escala basada en competencias digitales [Chilean student teachers’ purposes

of use of digital technologies: Construction of a scale based on digital

competences]. Pixel-Bit. Revista de

Medios y Educación, 64, 7-25.

https://doi.org/10.12795/pixelbit.93212

RESUMEN

La adquisición de

competencias digitales permite el desarrollo de las personas en diversas áreas

de la sociedad. En el caso de muchos jóvenes, y en especial de los futuros

docentes, dicha adquisición es obtenida a través del uso cotidiano de

tecnologías digitales. Disponer de instrumentos para medir competencias

digitales, considerando diversos propósitos de uso, puede contribuir a

retroalimentar la adquisición de estas competencias en procesos de formación

inicial docente. Esta investigación tuvo como objetivo construir y analizar

psicométricamente la Escala de Propósitos de Uso y Competencias Digitales

(EPUCD). Una muestra de 618 estudiantes de pedagogía de dos universidades

chilenas contestó un cuestionario que mide frecuencia de uso académico,

recreativo, social y económico, utilizando DigComp como marco de competencias

digitales. Los procedimientos estadísticos realizados (AFE, AFC y cálculo

coeficiente de fiabilidad compuesta y varianza extraída media) permitieron

obtener evidencias adecuadas de validez estructural y discriminante y de

consistencia interna de este instrumento. Las aceptables propiedades

psicométricas de la EPUCD permiten que se ponga a disposición de la comunidad

académica un instrumento que contribuya a develar cómo los futuros docentes

hacen uso de las tecnologías digitales, permitiendo de esta forma

retroalimentar el proceso de formación inicial docente.

ABSTRACT

The acquisition of digital

competences enables people’s active development in different areas of society.

In the case of many young people, and especially among future teachers, this

acquisition is obtained through the daily use of digital technologies. Having

instruments to measure digital competences associated to different purposes of

use can contribute to provide feedback on the acquisition of these competences

during initial teacher training processes. The aim of this study was to

construct and psychometrically analyze the Scale of Purposes of Use and Digital

Competences (EPUCD, by its acronym in Spanish). A sample of 618 student

teachers from two Chilean universities answered a questionnaire that measures

academic, entertainment, social and economic uses, considering DigComp as a

digital competence framework. The statistical procedures carried out (EFA, CFA,

composite reliability and average variance extracted) allowed to obtain

appropriate evidences of this instrument’s structural and discriminant validity

and internal consistency. The acceptable psychometric properties of EPUCD allow

to provide an instrument for the academic community that contributes to reveal

how future teachers use these digital technologies, offering feedback on the

initial teacher training process.

PALABRAS CLAVES · KEYWORDS

Competencia digital; tecnología educacional; formación

de docentes; enseñanza superior; medición.

Digital competence; educational technology; teacher education;

higher education; measurement.

1. Introducción

La

competencia digital es clave para que todos los ciudadanos del siglo XXI

garanticen su participación activa en la sociedad. Ser competente digitalmente

involucra usar de modo seguro, crítico y creativo las tecnologías para lograr

objetivos relacionados con el trabajo, empleabilidad, aprendizaje, ocio,

inclusión y/o participación en la sociedad (Ferrari, 2013). Se considera

indispensable que toda persona pueda manejar tecnologías digitales de tal forma

que pueda desenvolverse consciente y responsablemente en diferentes ámbitos de

su vida (Casal et al., 2021). Por lo tanto, es una competencia transversal que

permite el desarrollo activo en la sociedad y que ha sido frecuentemente objeto

de estudio.

Existen

diversas iniciativas que definen y organizan las competencias digitales,

educativas o genéricas, lo que ha llevado a la elaboración y utilización de

distintos conceptos y marcos (Gisbert et al., 2016). Según Cabero-Almenara, Romero-Tena, et al. (2020), diversos expertos en el área coinciden

que los marcos de competencias digitales disponibles, en el contexto educativo,

representan opciones consolidadas que orientan qué debe ser adquirido para ser

competente digitalmente. Entre estos marcos, los citados autores mencionan:

DigCompEdu, estándares ISTE para educadores, marco UNESCO, marco común español

de competencias docentes, marco británico para la enseñanza digital,

competencias TIC para el desarrollo profesional docente colombiano, junto a las

competencias y estándares TIC para la profesión docente en Chile. Por otra

parte, en términos de competencias digitales genéricas, DigComp puede ofrecer

una adecuada herramienta para comprender lo que las personas hacen con estas

tecnologías.

La

Comisión Europea, una de las instituciones preocupada de este tema, estableció

un Marco Europeo de Competencias Digitales para la Ciudadanía (DigComp)

(Ferrari, 2013). DigComp entrega orientaciones respecto a los conocimientos,

habilidades y actitudes para utilizar tecnologías digitales en cinco áreas de

competencias: (i) Información; (ii) Comunicación; (iii) Creación de contenido;

(iv) Seguridad; y (v) Resolución de problemas. Cada una de ellas está integrada

por un conjunto de competencias específicas, 21 en total. Además, versiones

actualizadas de este marco han establecido niveles de desempeños que permiten

la clasificación en categorías básica, intermedia y avanzada (Carretero et al.,

2017). Como se verá más adelante, el presente estudio adoptó el marco DigComp

por cuanto es coherente con la noción que el estudiante de pedagogía aprende a

usar de forma autónoma distintas herramientas digitales, durante su formación,

en función de necesidades y oportunidades emergentes. Pese a esta ventaja,

DigComp no hace referencia explícita a la relación de estas competencias

genéricas con diversos propósitos de uso de las tecnologías digitales.

En

la literatura se han reportado diversos propósitos de uso de estas tecnologías.

Algunos autores hablan de propósito académico cuando se usan las tecnologías

digitales para buscar información, comunicarse académicamente con otros,

realizar trabajos y tareas digitales y crear material digital con fines

educativos (Cerda et al., 2018). Otros se refieren a uso hedonista o de

entretenimiento para incluir acciones como jugar con dispositivos tecnológicos,

mirar televisión o escuchar radio, escuchar música o ver películas en línea

(Labbé et al., 2019; Morales et al., 2020). En tanto, también se habla de un

propósito de uso social pues la tecnología ofrece medios y espacios de

interacción que permiten la socialización (Lira, 2013). Finalmente, se destaca

el uso económico, donde los estudiantes universitarios se han transformado en

consumidores habituales del comercio electrónico (Castillo et al., 2020),

realizando actividades como trámites bancarios,

comprar o vender productos en línea (Matamala & Hinostroza, 2020).

Para todos estos propósitos de usos se hace fundamental ser competente

digitalmente, por lo que la evaluación de la competencia se considera un tema

relevante de abordar.

Existen

diversas formas para medir competencias digitales. Algunos instrumentos

consideran la percepción de los participantes respecto a su nivel de

competencia, por lo que se les pide que se autoevalúen en un nivel inicial,

medio o avanzado (e.g., Fraile et al., 2018). En algunos casos, se debe indicar

grado de acuerdo frente a afirmaciones que representan acciones asociadas a

competencias (e.g., Lorenzo-Lledó et al., 2018). Otras escalas miden la

percepción de frecuencia frente a actividades que reflejan competencias (e.g.,

Flores-Lueg & Roig, 2016; Siiman et al., 2016). También existen

instrumentos que evalúan conocimientos ante situaciones que necesitan ser

resueltas (e.g., Silva et al., 2019) y otros que involucran tareas a

desarrollar en un dispositivo tecnológico (e.g., Jashari et al., 2021). Además,

existen instrumentos que evalúan competencias digitales genéricas en

estudiantes universitarios (e.g., Wild & Schulze, 2021; Cabero-Almenara et

al, 2022), incluso algunos que son específicos para estudiantes de pedagogía

(e.g., Cabero-Almenara, Barroso-Osuna, et al., 2020;

Cantón-Mayo, 2017; Usart et al., 2021) y otros que se basan en el marco europeo

para la competencia digital de educadores (DigCompEdu) (e.g., Redecker, 2017).

Si bien estos instrumentos contribuyen a la medición de competencias digitales

desde diversas aproximaciones, ninguno de ellos considera simultáneamente

propósitos específicos de uso.

Aunque

se observa diversidad en la evaluación de competencias digitales, sigue

existiendo la necesidad de diseñar instrumentos para requerimientos

específicos, como pueden ser los diversos propósitos de uso con que los jóvenes

emplean la tecnología. En la actualidad, se cuenta con instrumentos que miden

competencias digitales genéricas, basados en el DigComp, para docentes en

formación (e.g., Fraile et al., 2018); sin embargo, no se disponen instrumentos

que incorporen distintos propósitos de uso de las tecnologías digitales. Por

otra parte, existen instrumentos que miden algunos propósitos de uso (e.g.,

Cerda et al., 2018), pero no incorporan explícitamente competencias digitales.

Ante este vacío, y dada la diversidad de ámbitos en que se desenvuelven los

estudiantes universitarios, y en específico, los futuros profesores, se

considera necesario aportar en este nicho investigativo. Se puede contribuir a

esta problemática, fortaleciendo la comprensión de este fenómeno desde la

medición de competencias digitales genéricas, pero vinculadas a diversos

propósitos de uso.

Tomando

en cuenta los antecedentes presentados, esta investigación tuvo como objetivo

construir y analizar psicométricamente la Escala de Propósitos de Uso y

Competencias Digitales (EPUCD). En específico, se buscó determinar evidencias

de validez de la estructura interna de la escala para confirmar el patrón de

asociaciones esperados a partir de su elaboración. Además, se planteó examinar

la validez discriminante de la EPUCD para confirmar que los factores no

reflejaran constructos redundantes. Finalmente, se identificó la consistencia

interna de la EPUCD. Sabiendo que una correcta interpretación de las

competencias digitales está ligada a particularidades sociales y culturales

respecto a tecnología y educación (Engen, 2019), se optó por construir la EPUCD

como un instrumento culturalmente pertinente para estudiantes de pedagogía, en

lugar de traducir y/o adaptar alguno de los instrumentos ya existentes.

Disponer

de un instrumento que mida competencias digitales en docentes en formación que

incluya distintos propósitos de uso se considera muy relevante. Asumiendo que

las competencias digitales continúan evolucionando, resulta fundamental incluir

las nuevas transformaciones que ocurran, tanto en la reorientación como en su

nivelación (Garzón-Artacho et al., 2021). En este sentido, incorporar

explícitamente los distintos propósitos de uso de las tecnologías, permitiría a

los investigadores medir de una manera confiable y válida estos distintos

aspectos en estudiantes de pedagogía. Con ello se podría describir los usos,

permitiendo -en futuras investigaciones- establecer relaciones con otras

variables y evaluar en diferentes períodos de tiempo los avances en este tema.

Por otra parte, se podría disponer de información que permitiera a los

formadores de educadores realizar acciones para promover competencias

digitales, especialmente en el uso académico. Investigaciones recientes dan

cuenta que los futuros docentes no tienen la suficiente competencia digital

para una integración efectiva de las tecnologías en su futuro desempeño

profesional (Cañete et al., 2022). Contar con instrumentos para medir

competencias digitales, considerando propósitos de uso, puede contribuir a

precisar el involucramiento que hacen los futuros educadores al emplear estas

tecnologías.

2. Método

Se obtuvo una muestra

intencionada (purposive sample; Etikan & Bala, 2017) de 618

participantes. Los criterios de inclusión fueron: (1) ser estudiante de

pregrado de pedagogía en una de dos universidades (una pública y otra privada)

del centro-sur de Chile y (2) asentir informadamente su participación en el

estudio. La muestra fue dividida aleatoriamente en dos submuestras equivalentes

(n1 = 314 y n2 = 304) las que no difirieron

significativamente (ps > .05) en las cuatro variables

sociodemográficas (ver Tabla 1).

Tabla 1

Perfil sociodemográfico de participantes según submuestras (n = 618)

|

Variables sociodemográficas |

Submuestra 1 n1 = 314 |

Submuestra 2 n2 = 304 |

|

Sexo, f (%) |

|

|

|

Hombre |

117 (37.26) |

107 (35.20) |

|

Mujer |

197 (62.74) |

197 (64.80) |

|

Años

de permanencia en programa, f (%) |

|

|

|

1 |

75 (23.88) |

75 (24.67) |

|

2 |

46 (14.65) |

51 (16.78) |

|

3 |

41 (13.06) |

43 (14.14) |

|

4 |

81 (25.80) |

68 (22.37) |

|

5 |

47 (14.97) |

49 (16.12) |

|

6 o más |

24 (7.64) |

18 (5.92) |

|

Reprobación

de asignaturas, f (%) |

|

|

|

Ninguna |

198 (63.06) |

181 (59.5) |

|

Dos o más |

116 (36.94) |

123 (40.5) |

|

Edad, M (DE) |

21.42 (2.96) |

21.80 (3.37) |

|

|

||

La Escala de Propósitos de Uso y Competencias

Digitales (EPUCD[1]) fue elaborada por el equipo

de esta investigación considerando criterios teóricos y empíricos (Streiner et

al., 2015). Primero, se analizaron las competencias señaladas en DigComp

(Ferrari, 2013; Vuorikari et al., 2016), seleccionándose aquellas susceptibles

de ser medidas con diferentes propósitos de usos en estudiantes de pedagogía.

Segundo, a fin de precisar los distintos propósitos de uso de tecnologías

digitales, nueve estudiantes llevaron un registro diario de acciones con estas

tecnologías, durante una semana, mediante la aplicación Google Keep;

adicionalmente se entrevistaron cinco estudiantes sobre este mismo tema.

Tercero, se consideraron ítems de instrumentos desarrollados previamente por

este equipo (Cerda et al., 2020; Cerda et al., 2018). Como resultado de lo

anterior se elaboraron 88 ítems iniciales que evaluaban cuatro propósitos de

uso en relación a cinco competencias digitales.

Los cuatro propósitos de uso fueron: académico,

recreativo, social, y económico. El propósito académico consideró la búsqueda

de información para actividades vinculadas a la universidad, la comunicación

con docentes o pares universitarios y la realización de trabajos y documentos

digitales académicos. El recreativo incluyó acciones como jugar, escuchar

música, ver audiovisuales utilizando tecnologías digitales. El social incorporó

comunicación con amistades, publicación en redes sociales, interacción y creación

de materiales para sociabilizar. Finalmente, el económico abarcó actividades

como comprar y vender utilizando tecnologías, cotizar productos o buscar en

línea oportunidades de trabajo.

Las cinco competencias

digitales seleccionadas del DigComp fueron[2]:

A = Navegar, buscar datos, información y contenido digital; B = Gestionar

datos, información y contenido digital; C = Interactuar a través de tecnologías

digitales; D = Compartir a través de tecnologías digitales; y E = Desarrollar

contenido digital.

Los ítems fueron redactados de manera positiva,

incluyendo los dos elementos centrales: (1) acción que refleja una competencia

digital y (2) propósito de uso de la tecnología digital, agregando (3) el

contexto digital y, eventualmente, los actores. Este orden puede ser ilustrado

en el siguiente ítem: Comunicarme (acción

que refleja la competencia) por Internet (contexto digital) con compañeros de cursos (actores) para informarme sobre tareas asignadas en clases (propósito de uso académico).

Se empleó un formato de respuesta de cinco opciones

graduadas según frecuencia: 1 = Nunca o casi nunca, 2 = A veces, 3 = Término

medio, 4 = Muchas veces, y 5 = Siempre o casi siempre. Los ítems fueron

presentados a los respondientes agrupados según propósito de uso y, dentro de

cada propósito, según competencias digitales. La EPUCD permite obtener 29

puntajes individuales: 20 puntajes específicos que corresponden a la combinación

de un propósito de uso con una competencia digital (e.g., propósito

académico/competencia A); cuatro puntajes de propósitos de uso (e.g., propósito

recreativo); y cinco de competencias digitales (e.g., competencia E). Estos

puntajes son obtenidos promediando las respuestas a los ítems correspondientes.

Mayores puntajes reflejan una mayor frecuencia de empleo de un propósito de uso

y/o de una competencia digital.

2.3 Procedimiento

La recolección de datos fue realizada de manera

digital, mediante la plataforma QuestionPro, dado el contexto de pandemia por

COVID19. Antes de participar, los estudiantes tuvieron la posibilidad de leer

un consentimiento informado, aprobado por un Comité Ético Científico

universitario, asintiendo participar en el estudio. El consentimiento informado

proporcionó los objetivos de investigación e información relativa a la

confidencialidad y privacidad de los datos, junto a la voluntariedad de

participar en el estudio. Durante siete semanas se enviaron correos

recordatorios (uno semanal) reiterando la invitación a participar a los

estudiantes que aún no lo habían hecho. Adicionalmente, docentes de las

carreras de educación, durante sus clases en línea, motivaron a sus estudiantes

a participar.

2.3 Análisis de datos

El análisis de los datos consideró la realización de

diversas acciones para obtener evidencias de validez de la estructura interna,

de validez discriminante y de la consistencia interna de la EPUCD. En la

submuestra 1 (n1 = 314) se realizó una

serie de análisis factoriales exploratorios (AFE), mediante el programa FACTOR

(Lorenzo-Seva & Ferrando, 2006), para indagar la estructura unidimensional

de cada uno de los 29 puntajes de la EPUCD. Cada AFE se inició a partir de la

matriz de correlaciones policóricas interítems, recomendada para datos

ordinales (Flora & Curran, 2004), y se prefijó la extracción de un factor

único mediante análisis factorial de rango mínimo (MRFA, por su sigla en

inglés) (Shapiro & Berge, 2002). Se examinó la factoriabilidad de los datos

a través de las pruebas de esfericidad de Bartlett y de adecuación muestral de

Kaiser-Meyer-Olkin (KMO). Fueron retenidos los ítems con cargas iguales o

mayores a .30 en el factor. En caso de que un ítem no cumpliera este criterio

se repitió el AFE, omitiendo tal ítem. El ajuste del modelo unifactorial

emergente fue inspeccionado a través del índice de la raíz cuadrada media de

los residuales (RMSR, por su sigla en inglés). Una vez definido cada factor, se

calculó su consistencia interna a través de omega ordinal.

En la submuestra 2 (n2 = 304), las 29 estructuras unidimensionales obtenidas

previamente con AFE fueron corroboradas, como modelos de medición, mediante

análisis factoriales confirmatorios (AFC) a través del programa estadístico

JASP 0.14. El método robusto de mínimos cuadrados ponderados diagonalizados (DWLS, por su sigla en inglés) fue usado para estimar cada modelo,

considerando los siguientes índices de bondad de ajuste y sus criterios

de aceptación: media estandarizada de la raíz cuadrática residual (SRMR < .08);

índice de Tucker Lewis (TLI > .90), índice de ajuste comparativo (CFI >

.90); y error cuadrático medio de aproximación (RMSEA ≤ .06) (Abad et

al., 2011).

A fin de explorar la existencia de un modelo

estructural se computaron, en la muestra total (n = 618), coeficientes de correlación simple r de Pearson entre los cuatro puntajes de propósitos de uso. Sobre

la base del patrón de correlaciones obtenido se examinó, mediante AFC, un

modelo estructural de cuatro factores latentes correlacionados (propósitos de

uso) y los 20 puntajes propósito/competencia como indicadores. Para descartar

modelos estructurales alternativos se examinaron dos modelos: uno unifactorial,

(con un factor latente general y los 20 puntajes como indicadores), y otro de

segundo orden (con un factor latente general de segundo orden, los cuatro

factores latentes de primer orden y los 20 puntajes como indicadores). Un valor

∆CFI menor o igual a |0.01| fue usado para concluir que los modelos

comparados no difieren significativamente (Cheung & Rensvold, 2002).

En el modelo tetrafactorial, la consistencia interna

de los factores latentes fue examinada mediante los coeficientes de fiabilidad

compuesta (FC) y de varianza extraída media (VEM). FC expresa la proporción de

varianza verdadera respecto a la varianza total de los ítems que integran un

factor latente, en tanto que VEM informa el monto de varianza capturada por el

factor en relación al monto de varianza debida a error de medición. Se

consideran aceptables valores FC y VEM iguales o mayores a 0.60 y 0.50,

respectivamente (Raykov, 2012). Además, se examinó la validez discriminante de

los factores del modelo comparando la VEM de cada factor versus las

estimaciones de las covarianzas, elevadas al cuadrado, entre los factores

involucrados. Cuando la VEM es mayor que cada una de estas covarianzas se

concluye que el constructo medido por el factor posee suficiente diferenciación

(validez discriminante) respecto a los otros constructos del modelo (Farrell,

2010; Fornell & Larcker, 1981).

3. Análisis y resultados

3.1 Evidencia de la estructura interna

3.1.1 Análisis Factorial Exploratorio

En los 29 AFE finales las pruebas de esfericidad de

Bartlett y de adecuación muestral KMO fueron adecuadas, así como también el

correspondiente valor de ajuste RMSR. En este proceso se eliminaron 14 de los

88 ítems originales por presentar bajas cargas factoriales.[3]

La Tabla 2 presenta la numeración de los 74 ítems que conformaron finalmente cada

uno de los 20 factores basados en cada combinación propósito/competencia, junto

a las cargas factoriales de los ítems correspondientes y la fiabilidad omega

ordinal de cada factor. En esta tabla, los totales filas y totales columnas

incluyen la fiabilidad omega de cada competencia y de cada propósito,

respectivamente.

3.1.2. Análisis Factorial

Confirmatorio

Utilizando la información obtenida a través del

análisis factorial exploratorio, se probaron los modelos de medida de los

propósitos de uso y competencias digitales. La Tabla 3 presenta los valores de

ajuste de los modelos de medida unidimensionales tanto de los propósitos de uso

como de las competencias digitales. Todos estos indicadores de ajuste fueron

adecuados.

El patrón de correlaciones simples r de Pearson entre cada par de puntajes

de propósitos de uso, todos con p

< .001, sugirió un modelo estructural de cuatro factores latentes

correlacionados. Específicamente, los valores r de propósito académico fueron .31 con recreativo, .47 con social,

y .44 con económico; asimismo, los valores r

de recreativo fueron .64 con social, y .50 con económico; finalmente, el

valor r de social fue .64 con

económico.

Numeración de los ítems componentes de los 20 factores

según combinaciones propósito/competencia, carga factorial (l) de los ítems y

fiabilidad omega (ω) ordinal del factor correspondiente.

|

CD |

|

Propósitos |

|

|||

|

Académico |

Recreativo |

Social |

Económico |

Total |

||

|

A |

Nº l w |

1, 2, 3 .84, .99, .85 .92 |

18, 19, 20, 21 .75, .80, .78, .84 .85 |

36, 37, 38, 39 .74, .73, .88., .82 .85 |

56, 57, 58, 59 .87, .94, .83, .75 .90 |

.89 |

|

|

|

|

|

|

|

|

|

B |

Nº l w |

4, 5, 6 83, .86, .71 .84 |

22, 23, 24 .72, .95, .51 .78 |

40, 41, 42, 43 .64, .85, .75, .77 .83 |

60, 61, 62, 63 .71, .64, .73, .82 .80 |

.84 |

|

|

|

|

|

|

|

|

|

C |

Nº l w |

7, 8, 9, 10 .93, .97, .96, .87 .96 |

25, 26, 27, 28 .81., .71, .74., 85 .83 |

44, 45, 46, 47 .81, .74, .81, .46 .80 |

64, 65, 66, 67 .90, .96, .74, .66 .88 |

.90 |

|

|

|

|

|

|

|

|

|

D |

Nº l w |

11, 12, 13 .83, .98, .88 .93 |

29, 30, 31 .86, .87, .84 .89 |

48, 49, 50, 51 .79., 84, .81., 77 .87 |

68, 69, 70 .93, .94, .79 .91 |

.92 |

|

|

|

|

|

|

|

|

|

E |

Nº l w |

14, 15, 16, 17 .84, .77, .92, .83 .90 |

32, 33, 34, 35 .79, .92., .72, .82 .88 |

52, 53, 54, 55 .80, .88, .88, .80 .90 |

71, 72, 73, 74 .81, .96, .93, .86 .91 |

.93 |

|

Total |

w |

.94 |

.93 |

.94 |

.95 |

-- |

|

Nota: CD =

Competencia digital. A = Navegar, buscar datos, información y contenido

digital; B = Gestionar datos, información y contenido digital; C =

Interactuar a través de tecnologías digitales; D = Compartir a través de

tecnologías digitales; y E = Desarrollar contenido digital. |

||||||

Tabla 3

Bondad de ajuste de

los modelos de medida unidimensionales de los propósitos de uso y competencias

digitales.

|

Modelos de medida |

χ2 |

gl |

p |

CFI |

TLI |

RMSEA (90% IC) |

SRMR |

|

Propósitos |

|

|

|

|

|

|

|

|

Académico |

16.906 |

5 |

.005 |

.986 |

.972 |

.089 (.045,.137) |

.067 |

|

Recreativo |

9.666 |

5 |

.085 |

.994 |

.987 |

.055 (.000,.108) |

.056 |

|

Social |

8.646 |

5 |

.124 |

.995 |

.989 |

.049 (.000,.103) |

.054 |

|

Económico |

5.642 |

5 |

.343 |

.999 |

.998 |

.021 (.000,.085) |

.059 |

|

Competencias |

|

|

|

|

|

|

|

|

A |

1.720 |

2 |

.423 |

1.000 |

1.000 |

.000 (.000-.109) |

.024 |

|

B |

1.925 |

2 |

.382 |

1.000 |

1.000 |

.000 (.000-.112) |

.027 |

|

C |

5.338 |

2 |

.069 |

0.983 |

0.950 |

.074 (.000-.154) |

.044 |

|

D |

2.140 |

2 |

.343 |

0.999 |

0.998 |

.015 (.000-.116) |

.034 |

|

E |

0.944 |

2 |

.624 |

1.000 |

1.000 |

.000 (.000-.091) |

.025 |

|

Nota: A = Navegar, buscar

datos, información y contenido digital; B = Gestionar datos, información y

contenido digital; C = Interactuar a través de tecnologías digitales; D =

Compartir a través de tecnologías digitales; y E = Desarrollar contenido

digital. |

|||||||

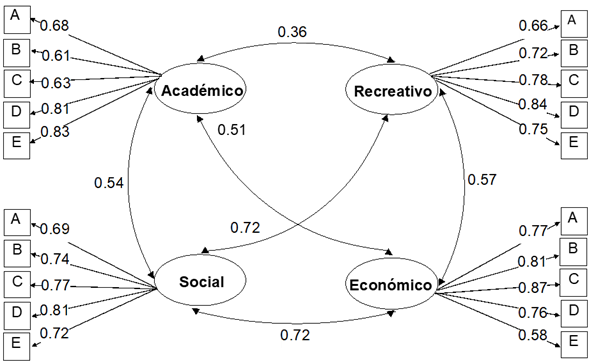

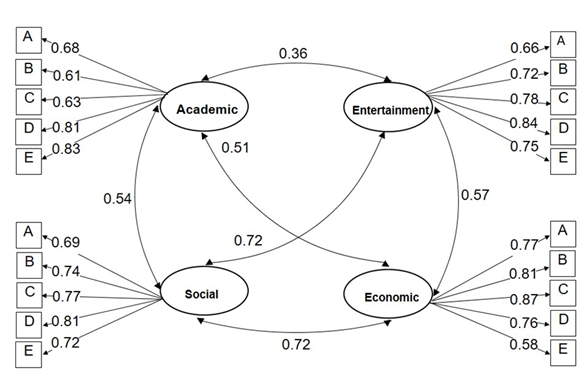

Los índices de ajuste del modelo estructural

tetrafactorial, expuestos en la Tabla 4, fueron todos adecuados. En el examen

del modelo alternativo unifactorial los índices RMSEA y SRMR revelan una falta

de ajuste de este modelo. El modelo alternativo de segundo orden ajustó

adecuadamente, aunque su ajuste fue ligeramente inferior a aquel del modelo

tetrafactorial. La comparación de estos dos modelos proporcionó un ∆CFI

de .002 revelando que los modelos tetrafactorial y de segundo orden no difieren

significativamente. Dados los adecuados niveles de consistencia interna y

validez discriminante observados en el modelo tetrafactorial (ver más adelante)

se prefirió este modelo por sobre el modelo de segundo orden. La Figura

1 muestra los resultados pormenorizados del modelo tetrafactorial.

Índices de ajuste de los tres modelos estructurales

examinados

|

Modelos |

|

df |

p |

CFI |

TLI |

RMSEA (90% IC) |

SRMR |

|

Tetrafactorial oblicuo |

405.61 |

164 |

<.001 |

.982 |

.979 |

.049 (.043,.055) |

.066 |

|

Unifactorial |

1364.80 |

170 |

<.001 |

.909 |

.899 |

.107 (.102,.112) |

.116 |

|

Segundo orden |

435.88 |

166 |

<.001 |

.980 |

.977 |

.051 (.045,.057) |

.068 |

Figura 1

Modelo tetrafactorial

3.2 Consistencia interna y validez discriminante

La Tabla 5 presenta los coeficientes de fiabilidad

compuesta (FC) y de varianza extraída media (VEM), junto a la evidencia de

validez discriminante, del modelo estructural tetrafactorial. Todos los valores

FC y VEM fueron superiores a los valores mínimos aceptables, indicando una

adecuada consistencia en cada factor. Además, en todas las comparaciones

pertinentes, la varianza extraída media (VEM) fue mayor que las estimaciones de

las covarianzas elevadas al cuadrado, resultado que apoya una suficiente

diferenciación entre los cuatro factores latentes del modelo. Así puede

afirmarse que estos cuatro factores reflejan constructos no redundantes.

Tabla 5

Fiabilidad

compuesta (FC), varianza extraída media (VEM) y estimaciones de las covarianzas

interfactores, elevadas al cuadrado, en el modelo estructural tetrafactorial.

|

Propósitos |

FC |

1 |

2 |

3 |

4 |

|

1. Académica |

.84 |

.52 |

.13 |

.29 |

.26 |

|

2. Recreativa |

.87 |

|

.57 |

.52 |

.32 |

|

3. Social |

.86 |

|

|

.56 |

.52 |

|

4. Económica |

.87 |

|

|

|

.58 |

|

Nota: Valores en la

diagonal (en negrita) corresponden a varianza extraída media (VEM). Valores

sobre la diagonal corresponden a estimaciones de la covarianza interfactores,

elevadas al cuadrado. |

|||||

En

este estudio se construyó y analizó psicométricamente la Escala de Propósitos

de Uso y Competencias Digitales. Específicamente, se obtuvo evidencias que

apoyan la validez de la estructura interna de la escala (modelo tetrafactorial

oblicuo) y la validez discriminante de sus factores. Además, se comprobó que

los factores poseen una adecuada consistencia interna. Así, se logró el

propósito de disponer de una escala con adecuadas propiedades psicométricas, al

menos iniciales, para medir propósitos de uso académico, recreativo, social y

económico a través de competencias digitales, en estudiantes de pedagogía.

La

EPUCD se suma a la diversidad de instrumentos existentes para medir

competencias digitales. Según el tipo de rendimiento, pueden clasificarse en

rendimiento óptimo (e.g., Jashari et al., 2021) o típico (e.g., Fraile et al.,

2018). La EPUCD se enmarcaría en esta última clasificación, pues tal como

indica Abad et al. (2011) interesa medir el comportamiento usual y, en este

caso, con qué frecuencia se realizan ciertas acciones asociadas a competencias

digitales, enmarcadas en algunos propósitos de uso. Por otra parte, es un

instrumento donde se seleccionaron ciertas competencias que se consideraron más

pertinentes para la realidad de los futuros educadores, a diferencia de otros

instrumentos, como el de Fraile et al. (2018) que incluyó las cinco áreas del

DigComp. Por consiguiente, se hace fundamental la incorporación de los

propósitos de uso académico, recreativo, social y económico debido a que su

integración permite ampliar las estrategias de medición, aportando de esta

forma al desarrollo de esta área del conocimiento.

Disponer

de un instrumento con adecuadas propiedades psicométricas se considera

relevante para el estudio de las competencias digitales. En específico, este

instrumento permitirá -a nivel macro- que en las organizaciones formadoras de

educadores se puedan tomar decisiones informadas respecto a las competencias de

sus estudiantes, conociendo en qué propósitos de usos están focalizados. Aunque

podría suponerse que estas instituciones educativas enfatizarían el uso

académico, la EPUCD permitiría determinar otros propósitos de uso de las

tecnologías digitales. Sin desconocer la importancia del uso académico en la

formación de futuros docentes, resulta relevante comprender cómo los otros

propósitos de uso interactuarían con el uso académico.

Esta

investigación presenta algunas limitaciones que deben considerarse. La

aplicación de este instrumento fue realizada durante la emergencia sanitaria

producto del COVID19. En este contexto, la docencia universitaria fue impartida

de manera virtual, situación que podría haber influido en los resultados

obtenidos, potenciado de alguna manera una mayor frecuencia de uso de las

tecnologías digitales. Sería necesario replicar esta investigación en un

contexto libre de pandemia. Además, es relevante recordar que la utilización de

las tecnologías está mediada por la disponibilidad, acceso y orientaciones que

las instituciones educativas promuevan. Dada la diversidad observada en las

mallas de formación inicial docente en Chile (Tapia et al., 2020), es necesario

tener presente que la realidad de los estudiantes evaluados, podría no

replicarse en otras universidades del país. En esta misma línea, la medición de

los propósitos de uso puede variar dependiendo de los contextos y

disponibilidades tecnológicas. Un buen ejemplo de esto ha sido la docencia

virtual en tiempos de COVID19 que ha impulsado el uso académico de estas

aplicaciones, al igual que el uso social de estas tecnologías que es estimulado

por las empresas de telefonía al ofrecer estos servicios de manera gratuita. Es

altamente recomendable que futuras investigaciones consideren -en su diseño- el

control de estas limitaciones.

La

EPUCD podría contribuir al desarrollo de futuros estudios asociados a la

investigación en formación inicial docente y uso de tecnologías digitales. De

manera inicial, permitiría el desarrollo de estudios cuyo foco sea describir

las competencias digitales asociadas a diferentes propósitos de uso de los

estudiantes de pedagogía. También podría ser utilizada en investigaciones donde

se quisiera conocer el perfil de las personas que tienen mayores puntajes en

ciertos propósitos de uso. Puesto que la validación de una medida es un proceso

acumulativo constante, se sugiere para futuros estudios examinar otras fuentes

de validez de la EPUCD, como aquellas basadas en contenido, relaciones con

otras variables, o consecuencias (Elosua, 2003). Igualmente, se recomienda

replicar el examen de la estructura interna de la escala en otras poblaciones

de estudiantes de pedagogía. Para facilitar la interpretación de puntajes

individuales de la EPUCD se propone la construcción de referentes normativos

(baremos, puntos de corte), ojalá en muestras representativas de poblaciones de

docentes en formación.

Este estudio pone a

disposición de la comunidad académica e investigativa un instrumento, la EPUCD,

especialmente diseñado para medir, en estudiantes de pregrado de pedagogía,

cuatro propósitos de uso de tecnologías digitales en razón de cinco

competencias digitales seleccionadas desde un marco de competencias digitales

ampliamente reconocido, DigComp. La EPUCD permite obtener puntuaciones sobre

los propósitos de uso y las competencias digitales, a emplear según las

necesidades particulares de evaluación, constituyéndose así en una herramienta

flexible y que proporciona una amplia cantidad y variedad de información. Esta

escala cuenta, también a partir de este estudio, con evidencia inicial que

sustenta la calidad psicométrica de sus puntuaciones, al menos en términos de

validez estructural y discriminante y de consistencia interna. Así, la EPUC

puede ser un aporte relevante para tanto la investigación como la evaluación de

las competencias digitales y/o sus propósitos de uso en los docentes en

formación.

5. Financiación

Este

estudio fue financiado por el Fondo Nacional de Desarrollo Científico y

Tecnológico (CONICYT) de Chile, mediante el proyecto FONDECYT regular 1191193.

Chilean student teachers’ purposes of use of

digital technologies: Construction of a scale based on digital competences

1.

Introduction

Digital competence is essential in order to guarantee

all 21st-century citizens’ active participation in society. Being digitally

competent involves using technologies in a secure, critical, and creative way

in order to achieve objectives related to work, employability, learning,

leisure, inclusion and/or participation in society (Ferrari, 2013). It is

considered essential that people can manage digital technologies in a manner

that they can consciously and responsibly get along in different areas of life

(Casal et al., 2021). Therefore, it is a transversal competence that allows the

active development in society, which has been a frequent object of study.

There are diverse initiatives that define and organize

digital, educational or generic competences, which has led to the development

and use of different concepts and frameworks (Gisbert et al., 2016). According

to Cabero-Almenara, Romero-Tena, et al. (2020), different experts in the field

agree on the fact that the frameworks of available digital competences in the

educational context represent consolidated options that guide what should be

acquired to be digitally competent. Among these frameworks, the mentioned

authors suggest the following: DigCompEdu, the ISTE Standards for Educators,

UNESCO ICT Competency Framework for Teachers, Spanish common digital competence

framework for teachers, British Framework of Digital Teaching, ICT competences

for Colombian teacher professional development, and ICT Competences and

Standards for the teaching profession in Chile. In terms of generic digital

competences, DigComp can be a suitable tool in order to understand what people

do with these technologies.

European Commission, one of the institutions concerned

about this topic, developed The European Digital Competence Framework for

Citizens (DigComp) (Ferrari, 2013). DigComp brings orientations regarding

knowledge, skills, and attitudes in order to use digital technologies in five

key areas: (i) Information and data literacy; (ii) Communication and

collaboration; (iii) Digital content creation; (iv) Safety; (v) Problem

solving. Every area considers specific competences and there are 21 competences

in total. Moreover, updated versions of this framework have established

performance levels that allow the classification in categories such as basic,

intermediate, and advanced (Carretero et al., 2017). As it will be seen below,

this study adopted the DigComp framework because it is coherent regarding the

notion that student teachers learn to use different digital tools autonomously

during their teacher training and according to their needs and emerging

opportunities. Despite this advantage, DigComp does not explicitly refer to the

relation between these generic competences and diverse purposes of use for

digital technologies.

Literature has reported diverse purposes of use for technologies.

Some authors consider academic purpose when digital technologies are used in

order to look up information, communicate academically with others, do digital

homework, and create digital material with educational purposes (Cerda et al.,

2018). Other authors consider a hedonistic or entertainment use to include

actions such as playing with technological devices, watch television or listen

to the radio, listen to music or watch online movies (Labbé et al., 2019;

Morales et al., 2020). Furthermore, a social purpose of use implies that

technology offers means and spaces for interaction that allow socialization

(Lira, 2013). Finally, the economic use highlights the fact that university

students have become usual consumers of electronic commerce (Castillo et al.,

2020). For example, they do activities such as banking procedures and buying or

selling products online (Matamala & Hinostroza, 2020). For all these

purposes of use, it is essential to be digitally competent, so the assessment

of digital competence is a relevant topic to address.

There are diverse ways to assess digital competences.

Some instruments consider the perception of the participants regarding their

level of competence, so they are asked to self-assess in a beginning,

intermediate or advanced level (e.g., Fraile et al., 2018). In some cases, the

degree of agreement with statements that represent actions associated with

competencies must be indicated (e.g., Lorenzo-Lledó et al., 2018). Other scales

measure the perception of frequency regarding activities that reflect

competencies (e.g., Flores-Lueg & Roig, 2016; Siiman et al., 2016). There

are also instruments that assess knowledge in situations that need to be

resolved (e.g., Silva et al., 2019) and others that involve tasks to be developed

in a technological device (e.g., Jashari et al., 2021). Also, there are

instruments that assess generic digital competences in university students (eg,

Wild & Schulze, 2021; Cabero-Almenara et al, 2022), including some that are

specific to student teachers (eg, Cabero-Almenara, Barroso-Osuna, et al., 2020;

Cantón-Mayo, 2017; Usort et al., 2021) and others based on The European

Framework for the Digital Competence of Educators (DigCompEdu) (eg, Redecker,

2017). Although these instruments contribute to the measurement of digital

competences from diverse approaches, none of them simultaneously consider

specific purposes of use.

Although there is a diversity in the assessment of

digital competences, there is still a need to design instruments for specific

requirements, such as the different purposes of use with which young people use

technology. Nowadays, there are instruments that measure generic digital

competences, based on DigComp, for student teachers (e.g., Fraile et al.,

2018); however, there are no instruments that incorporate different digital

technologies purposes of use. There are instruments that measure some purposes

of use (e.g., Cerda et al., 2018), but do not explicitly incorporate digital

competences. According to this gap and the diversity of areas in which

university students, and specifically, future teachers, work, it is considered

necessary to contribute to this research niche. It is possible to contribute to

this research problem by strengthening the understanding of this phenomenon

from the measurement of generic digital competences, but linked to different

purposes of use.

Taking into account the previous information, the aim

of this study was to psychometrically build and analyze the Scale of Purposes

of Use and Digital Competences. Specifically, this study aims to determine

evidence of the scale’s internal structural validity in order to confirm the

pattern of associations expected since its development. In addition, this study

examined the discriminant validity of the EPUCD to confirm that the factors did

not reflect redundant constructs. Finally, the internal consistency of the

EPUCD was identified. Knowing that a correct interpretation of the digital

competences is linked to social and cultural particularities regarding

technology and education (Engen, 2019), it was decided to build the EPUCD as a

culturally pertinent instrument for student teachers, instead of translating

and/or adapting some of the existing instruments.

Having an instrument that measures digital competences

among student teachers, which includes different purposes of use is very

relevant. Assuming that the digital competences continue to evolve, it is

essential to include the new transformations that are taking place, both in

reorientation and levelling (Garzón-Artacho et al., 2021). In this sense,

explicitly incorporating the different technologies’ purposes of use would

allow researchers to measure in a reliable and valid way these different

aspects in student teachers. With this instrument, the uses could be described,

which would allow—in future research—the identification of relationships with

other variables and assess the advances in this topic in different periods of

time. Moreover, it would be possible to obtain information that would allow

student teachers’ professors to carry out actions to promote digital

competences, especially in academic use. Recent research shows that future

teachers do not have sufficient digital competence to effectively integrate

technologies in their future professional performance (Cañete et al., 2022).

Having instruments to measure digital competences, considering purposes of use,

can contribute to specify the involvement that future educators make when they

use these technologies.

2. Method

2.1. Participants

A purposive sample (Etikan

& Bala, 2017) of 618 participants was used in this study. The inclusion

criteria were: (1) being an undergraduate student teacher in one of two

universities (one of them is public and the other one is private) located in southern

Chile and (2) provide informed consent regarding their participation in the

study. The sample was randomly divided into two equivalent subsamples (n1

= 314 y n2 = 304). They did not significantly differ from each other

(ps > .05) in the four sociodemographic variables (see Table 1).

Sociodemographic profile of

participants according to subsamples (n = 618)

|

Sociodemographic

variables |

Subsample

1 n1 = 314 |

Subsample

2 n2 = 304 |

|

Sex, f (%) |

|

|

|

Man |

117 (37.26) |

107 (35.20) |

|

Woman |

197 (62.74) |

197 (64.80) |

|

Years of

stay in the program, f (%) |

|

|

|

1 |

75 (23.88) |

75 (24.67) |

|

2 |

46 (14.65) |

51 (16.78) |

|

3 |

41 (13.06) |

43 (14.14) |

|

4 |

81 (25.80) |

68 (22.37) |

|

5 |

47 (14.97) |

49 (16.12) |

|

6 or more |

24 (7.64) |

18 (5.92) |

|

Failure of

subjects, f (%) |

|

|

|

None |

198 (63.06) |

181 (59.5) |

|

Two or more |

116 (36.94) |

123 (40.5) |

|

Age, M (SD) |

21.42 (2.96) |

21.80 (3.37) |

|

|

||

2.2. Instrument

The Scale of Purposes of Use

and Digital Competences (EPUCD)[4] was developed by the team of

this research considering empirical and theoretical criteria (Streiner et al.,

2015). First, the DigComp competences already mentioned were analyzed (Ferrari,

2013; Vuorikari et al., 2016) and the ones likely to be measured with different

purposes of use in student teachers were selected. Second, in order to specify

the different digital technologies purposes of use, nine students registered

daily actions related to these technologies during one week through the Google

Keep application. Additionally, five students were interviewed about the same

topic. Third, items developed by this research team (Cerda et al., 2020; Cerda

et al., 2018). As a result, 88 items were created at first, which assessed four

purposes of use related to five digital competences.

The four purposes of use were:

academic, entertainment, social, and economic. The academic purpose considered

the search for information for activities related to the university,

communication with teachers or university classmates, and the completion of homework

and academic digital documents. The entertainment use added actions such as

playing, listening to music and watching digital content using digital

technologies. The social use incorporated communication with friends, post in

social media, interaction and creation of materials to socialize. Finally, the

economic use covered activities such as buy and sell using technologies, value

products or search online for job opportunities.

The five digital competencies

selected from DigComp were[5]: A = Browsing, searching and

filtering data, information and digital content; B = Managing data, information

and digital content; C = Interacting through digital technologies; D = Sharing

through digital technologies; E = Developing digital content.

The items were all written in

a positive way, including the two central elements: (1) action that reflects a

digital competence and (2) digital technology purpose of use, and (3) the

digital context and, eventually, the actors. This order can be illustrated in

the following item: Communicate (action

that reflects competence) through Internet (digital context) with university classmates (actors) to inform me about assigned tasks in classes (purpose of academic use).

A response format of five

options graduated according to frequency was used: 1 = Never or almost never, 2

= Sometimes, 3 = Neutral, 4 = A lot of times, 5 = Always or almost always. The

items were presented to the participants grouped according to purpose of use

and, within each purpose, according to digital competences. The EPUCD allows to

obtain 29 individual scores: 20 specific scores that correspond to the

combination of a purpose of use with a digital competence (e.g., academic

purpose/ A competence); four purpose of use scores (e.g., entertainment

purpose); and five digital competences (e.g., E competence). These scores are

obtained by averaging the responses to the corresponding items. Higher scores

reflect a greater frequency of use of a purpose of use and/or a digital

competence.

2.3. Procedure

Data collection was carried

out remotely using the QuestionPro platform due to the COVID19 pandemic

context. Before participating, the students had the opportunity to read an

informed consent form, approved by a university Scientific Ethics Committee, in

order to agree to participate in the study. The informed consent form provided

the research objectives and information regarding the confidentiality and

privacy of the data, together with the voluntary nature of participating in the

study. For seven weeks, reminder emails were sent (one weekly) reiterating the

invitation to participate to students who had not yet done so. Additionally,

teachers from education careers motivated their students to participate during

the online classes.

2.4. Data analysis

The data analysis considered

the performance of several actions in order to obtain evidence of internal

structural validity, discriminant validity, and internal consistency of the

EPUCD. In subsample 1 (n1 = 314), a series of Exploratory Factor

Analysis (EFA) were carried out using FACTOR (Lorenzo-Seva & Ferrando,

2006) to inquire into the unidimensional structure of the 29 scores generated

by the EPUCD instrument. Each EFA started from the inter-item polychoric

correlation matrix, which is recommended for ordinal data (Flora & Curran,

2004), and the extraction of a single factor was prefixed through Minimum Rank

Factor Analysis (MRFA) (Shapiro & Berge, 2002). The factoriability of the

data was examined through Bartlett's test of Sphericity and the Kaiser-Meyer-Olkin

(KMO) test for sampling adequacy. Items with loads equal to or above .30 in the

factor were retained. If an item did not meet this criterion, the EFA was

repeated and that item was omitted. The emerging unifactorial model fit was

reviewed through the Root Mean Square Residual index (RMSR). After every factor

was defined, the internal consistency was calculated through ordinal omega.

In subsample 2 (n2

= 304), the 29 unidimensional structures previously obtained with EFA were

corroborated as measurement models through confirmatory factor analysis (CFA),

through the statistical software JASP 0.14. The robust method of diagonal

weighted least squares (DWLS) was used in order to estimate each model,

considering the following indexes of fit and their criteria for acceptance:

Standardized Root Mean-Square Residual (SRMR < .08); Tucker Lewis Index (TLI

> .90); Comparative Fit Index (CFI > .90); and the Root Mean Square Error

of Approximation (RMSEA ≤ .06) (Abad et al., 2011).

In order to explore the existence

of a structural model, in the total sample (n = 618), Pearson correlation

coefficients (r) between the four scores of purposes of use were computed.

Based on the pattern of correlations obtained, through CFA, a structural model

of four correlated latent factors (purposes of use) and the 20

purpose/competence scores as indicators were examined. To rule out alternative

structural models, two models were examined: an unifactorial model (with a

general latent factor and the 20 scores as indicators), and a second-order

model (with a second-order general latent factor, the four first-order latent

factors and the 20 scores as indicators). A ∆CFI value less than or equal

to |0.01| was used to conclude that the compared models do not differ

significantly (Cheung & Rensvold, 2002).

In the four-factor model, the

internal consistency of the latent factors was examined through the composite

reliability coefficient (CR) and the average variance extracted (AVE). CR

expresses the proportion of true variance with respect to the total variance of

the items that make up a latent factor, while AVE reports the amount of

variance captured by the factor in relation to the amount of variance due to

measurement error. CR and AVE values equal to or greater than

0.60 and 0.50, respectively, are considered acceptable (Raykov, 2012). In

addition, the discriminant validity of the model factors is produced by

comparing the AVE of each factor with the estimates of the squared covariances

between the factors involved. When the AVE is greater than each of these

covariances, it is concluded that the construct measured by the factor has

sufficient differentiation (discriminant validity) with respect to the other

constructs of the model (Farrell, 2010; Fornell & Larcker, 1981).

3. Analysis and results

3.1. Evidences of

internal structure validity

3.1.1.

Exploratory Factor Analysis

In the final 29 EFA,

Bartlett's test of Sphericity and the Kaiser-Meyer-Olkin (KMO) test for

sampling adequacy were adequate, and the corresponding RMSR fit value as well.

In this process, 14 of the 88 original items were eliminated due to low factor

loads. Table 2[6] shows the numbering of the 74

items that finally made up each of the 20 factors based on each

purpose/competence combination, with the factor loads of the corresponding

items and the ordinal omega reliability of each factor. In this table, the

row-total and column-totals include the omega reliability of each competence

and each purpose, respectively.

Numbering of items that make

up the 20 factors according to combinations purpose/competence, factorial load

(l) of the items and ordinal omega reliability (ω) of the corresponding

factor.

|

DC |

|

Purposes |

|

|||

|

Academic |

Entertainment |

Social |

Economic |

Total |

||

|

A |

Nº l w |

1, 2, 3 .84, .99, .85 .92 |

18, 19, 20, 21 .75, .80, .78, .84 .85 |

36, 37, 38, 39 .74, .73, .88., .82 .85 |

56, 57, 58, 59 .87, .94, .83, .75 .90 |

.89 |

|

|

|

|

|

|

|

|

|

B |

Nº l w |

4, 5, 6 83, .86, .71 .84 |

22, 23, 24 .72, .95, .51 .78 |

40, 41, 42, 43 .64, .85, .75, .77 .83 |

60, 61, 62, 63 .71, .64, .73, .82 .80 |

.84 |

|

|

|

|

|

|

|

|

|

C |

Nº l w |

7, 8, 9, 10 .93, .97, .96, .87 .96 |

25, 26, 27, 28 .81., .71, .74., 85 .83 |

44, 45, 46, 47 .81, .74, .81, .46 .80 |

64, 65, 66, 67 .90, .96, .74, .66 .88 |

.90 |

|

|

|

|

|

|

|

|

|

D |

Nº l w |

11, 12, 13 .83, .98, .88 .93 |

29, 30, 31 .86, .87, .84 .89 |

48, 49, 50, 51 .79., 84, .81., 77 .87 |

68, 69, 70 .93, .94, .79 .91 |

.92 |

|

|

|

|

|

|

|

|

|

E |

Nº l w |

14, 15, 16, 17 .84, .77, .92, .83 .90 |

32, 33, 34, 35 .79, .92., .72, .82 .88 |

52, 53, 54, 55 .80, .88, .88, .80 .90 |

71, 72, 73, 74 .81, .96, .93, .86 .91 |

.93 |

|

Total |

w |

.94 |

.93 |

.94 |

.95 |

-- |

|

Note: DC = Digital competence. A = Browsing, searching and filtering data,

information and digital content; B = Managing data, information and digital

content; C = Interacting through digital technologies; D = Sharing through

digital technologies; E = Developing digital content. |

||||||

3.1.2. Confirmatory Factor Analysis

Using the information obtained

through the exploratory factor analysis, the measurement models of the purposes

of use and digital competences were tested. The Table 3 shows the fit values of

the unidimensional measurement models for both purposes of use and digital

competences. All these fit indicators were adequate.

Goodness of fit for unidimensional measurement models

of the purposes of use and digital competences

|

Measurement models |

χ2 |

df |

p |

CFI |

TLI |

RMSEA (90% IC) |

SRMR |

|

Purposes |

|

|

|

|

|

|

|

|

Academic |

16.906 |

5 |

.005 |

.986 |

.972 |

.089 (.045,.137) |

.067 |

|

Entertainment |

9.666 |

5 |

.085 |

.994 |

.987 |

.055 (.000,.108) |

.056 |

|

Social |

8.646 |

5 |

.124 |

.995 |

.989 |

.049 (.000,.103) |

.054 |

|

Economic |

5.642 |

5 |

.343 |

.999 |

.998 |

.021 (.000,.085) |

.059 |

|

Competences |

|

|

|

|

|

|

|

|

A |

1.720 |

2 |

.423 |

1.000 |

1.000 |

.000 (.000-.109) |

.024 |

|

B |

1.925 |

2 |

.382 |

1.000 |

1.000 |

.000 (.000-.112) |

.027 |

|

C |

5.338 |

2 |

.069 |

0.983 |

0.950 |

.074 (.000-.154) |

.044 |

|

D |

2.140 |

2 |

.343 |

0.999 |

0.998 |

.015 (.000-.116) |

.034 |

|

E |

0.944 |

2 |

.624 |

1.000 |

1.000 |

.000 (.000-.091) |

.025 |

Note: A = Browsing, searching and

filtering data, information and digital content; B = Managing data, information

and digital content; C = Interacting through digital technologies; D = Sharing

through digital technologies; E = Developing digital content.

The pattern of Pearson correlation

coefficients between each pair of purposes of use scores, all with p < .001

suggested a structural model of four correlated latent factors. Specifically,

the r-values for academic purpose were .31 with entertainment, .47 with social,

and .44 with economic. Also, the r-values of entertainment were .64 with

social, and .50 with economic; finally, the r-value of social was .64 with

economic.

The fit index of the

four-factor structural model, shown in Table 4, were all adequate. In the

examination of the alternative unifactorial model, the RMSEA and the SRMR

indexes showed a lack of fit in this model. The second-order alternative model

fitted well, although its fit was slightly lower than that of the four-factor

model. The comparison of these two models provided a ∆CFI of .002, which

reveals that the four-factor and second-order models do not differ

significantly. Because of the adequate levels of internal consistency and

discriminant validity observed in the four-factor model (see below), this model

was preferred over the second-order model. Figure 1 shows the detailed results

of the four-factor model.

Table 4

Fit indexes of three examined structural models

|

Models |

|

df |

P |

CFI |

TLI |

RMSEA (90% CI) |

SRMR |

|

Four-oblique-factor |

405.61 |

164 |

<.001 |

.982 |

.979 |

.049 (.043,.055) |

.066 |

|

Unifactorial |

1364.80 |

170 |

<.001 |

.909 |

.899 |

.107 (.102,.112) |

.116 |

|

Second-order |

435.88 |

166 |

<.001 |

.980 |

.977 |

.051 (.045,.057) |

.068 |

Figure 1

Four-factor model

3.2. Internal consistency and discriminant validity

Table 5 shows the composite

reliability coefficients (CR) and the average variance extracted (AVE) with the

evidence of discriminant validity of the four-factor structural model. All CR

and AVE values were higher than the minimum acceptable values, which indicates

an adequate consistency in each factor. In addition, in all relevant

comparisons, the average variance extracted (AVE) was greater than the

estimates of the squared covariances, a result that supports sufficient

differentiation between the four latent factors of the model. Thus, it can be

stated that these four factors reflect non-redundant constructs.

Table 5

Composite reliability (CR), average variance extracted (AVE) and the

squared interfactor covariance estimations in the four-factor structural model

|

Purposes |

CR |

1 |

2 |

3 |

4 |

|

1. Academic |

.84 |

.52 |

.13 |

.29 |

.26 |

|

2. Entertainment |

.87 |

|

.57 |

.52 |

.32 |

|

3. Social |

.86 |

|

|

.56 |

.52 |

|

4. Economic |

.87 |

|

|

|

.58 |

Note:

Values located in diagonal (in bold) are the average variance extracted (AVE).

Values above the diagonal are the squared interfactor covariance estimations.

4. Discussion

In this study, the Scale of

Purposes of Use and Digital Competences was psychometrically constructed and

analyzed. Specifically, the evidence obtained demonstrates the internal

structural validity of the scale (four-oblique-factor model) and the discriminant

validity of its factors. In addition, the factors have adequate internal

consistency. Thus, the purpose of having a scale with adequate psychometric

properties, at least initially, to measure purposes of academic, recreational,

social and economic use through digital competences, in pedagogy students was

achieved.

The EPUCD is among the

existing instruments to measure digital competences. Depending on the type of

performance, they can be classified as optimal performance (e.g., Jashari et

al., 2021) or typical (e.g., Fraile et al., 2018). The EPUCD would be framed in

this last classification, since as indicated by Abad et al. (2011) it is of

interest to measure the usual behavior and, in this case, how often certain

actions associated with digital competences are carried out, framed in some

purposes of use. It is an instrument where certain competencies were selected

that were considered more pertinent to the reality of future educators, unlike

other instruments, such as the one provided by Fraile et al. (2018) that

included the five areas of the DigComp. Therefore, the incorporation of the

purposes of academic, entertainment, social and economic uses is essential

because their integration allows the expansion of measurement strategies, thus

contributing to the development of this area of knowledge.

Having an instrument with

adequate psychometric properties is relevant for the study of digital

competences. Specifically, this instrument will allow, at a macro level, to

make informed decisions regarding the competences of their students in educator

training organizations, knowing what purposes of use they are focused on.

Although it could be assumed that these educational institutions would

emphasize academic use, the EPUCD would allow other digital technologies

purposes of use to be known. Without ignoring the importance of academic use in

the training of future teachers, it is relevant to know how the other purposes

of use would interact with the academic use.

This research has some

limitations that should be considered. The application of this instrument was

carried out during the health emergency caused by COVID19. In this context,

university teaching was taught remotely, a situation that could have influenced

the results obtained, promoting somehow a greater digital technologies

frequency of use. It would be necessary to replicate this research in a

pandemic-free context. In addition, it is important to remember that the use of

technologies is mediated by the availability, access and orientations that

educational institutions promote. Because of the diversity observed in the

initial teacher training curriculum in Chile (Tapia et al., 2020), it is

necessary to have in mind that the reality of the students assessed may not be

replicated in other universities in the country. In this same sense, the

measurement of the purposes of use can vary depending on the contexts and

technological availability. A good example of this has been remote teaching in

times of COVID19, which has promoted the academic use of these applications,

just as the social use of these technologies is stimulated by telephone

companies by offering these services for free. It is highly recommended that

future researches can consider in their design the control of these

limitations.

The EPUCD could contribute to

develop future studies associated with researches in initial teacher training

and the use of digital technologies. Initially, it would allow the development

of studies which focus is to describe the digital competences associated to

different purposes of use by student teachers. It could also be used in

research where it is desired to know the profile of the people who have higher

scores in certain purposes of use. Since the validation of a measure is a

constant cumulative process, it is suggested for future studies to examine

other sources of validity of the EPUCD, such as those based on content,

relationships with other variables, or consequences (Elosua, 2003). Likewise,

it is recommended to replicate the examination of the internal structure of the

scale in other populations of pedagogy students. To facilitate the

interpretation of individual scores of the EPUCD, the construction of normative

references (scales, cut-off scores), is also proposed, hopefully in

representative samples of populations of student teachers.

4. Conclusions

This study contributes a

measurement instrument for the academic and research community, the EPUCD,

specially designed to assess, in undergraduate student teachers, four digital

technologies purposes of use based on five digital competences selected from a

widely used digital competences framework as DigComp. The EPUCD allows

researchers to obtain scores about purposes of use and digital competences, to

be used according to the particular assessment needs. Thus, it is a flexible

tool that provides a wide amount and variety of information. Also, thanks to

this study, this scale has initial evidence that supports the psychometric

quality of its scores, at least in terms of structural and discriminant

validity as well as internal consistency. Thus, the EPUCD can be a relevant

contribution to research and assess digital competences and/or their purposes

of use in student teachers.

5. Funding

This study was supported by

the National Fund for Scientific and Technological Development (CONICYT, by its

acronym in Spanish) of Chile, through the regular 1191193 FONDECYT project.

References

Cabero-Almenara,

J., Barroso-Osuna, J., Gutiérrez-Castillo, J. J., & Palacios-Rodríguez, A.

(2020). Validación del cuestionario de competencia digital para futuros

maestros mediante ecuaciones estructurales. Bordón.

Revista de Pedagogía, 72(2),

45-63. https://doi.org/10.13042/Bordon.2020.73436

Cabero-Almenara,

J., Gutiérrez-Castillo, J. J., Guillén-Gámez, F. D., Gaete, A. F. (2022).

Competencias digitales de estudiantes tecnico-profesionales: Creacion de un

modelo causal desde un enfoque PLS-SEM. Campus Virtuales, 11(1),

167-179. https://doi.org/10.54988/cv.2022.1.1008

Cabero-Almenara,

J., Romero-Tena, R., Barroso-Osuna, J., & Palacios-Rodríguez, A. (2020).

Marcos de competencias digitales docentes y su adecuación al profesorado

universitario y no universitario. Revista Caribeña de Investigación

Educativa (RECIE), 4(2), 137-158. https://doi.org/10.32541/recie.2020.v4i2.pp137-158

Cantón-Mayo,

I., Cañón-Rodríguez, R., & Grande-de-Prado, M. (2017). La

comunicación como subdimension de la competencia digital en futuros maestros

de primaria. Pixel-Bit. Revista de Medios

y Educación, 50, 33-47. https://doi.org/10.12795/pixelbit.2017.i50.02

Cañete, D.

L., Torres, C. A., Lagunes, A., & Gómez, M. (2022). Competencia digital de

los futuros docentes en una institución de educación superior en el Paraguay. Pixel-Bit. Revista de Medios y

Educación, 63, 159-195. https://doi.org/10.12795/pixelbit.91049

Carretero,

S., Vuorikari, R., & Punie, Y. (2017). DigComp 2.1: The Digital

Competence Framework for Citizens with eight proficiency levels and examples of

use (EUR 28558). https://ec.europa.eu/jrc

Casal, L.,

Barreira, E. M., Mariño, R., & García, B. (2021). Competencia digital

docente del profesorado de FP de Galicia. Pixel-Bit.

Revista de Medios y Educación,

61, 165-196. https://doi.org/10.12795/pixelbit.87192

Castillo,

S., Rodríguez, J., & Espinosa, V. (2020). Consumo vía digital en jóvenes

universitarios de la ciudad de Bogotá. In F. Ribero (Ed.), IV Encuentro de Investigación en Publicidad. Nuevos retos de la

publicidad en una sociedad en crisis (pp. 185-192). Universidad Sergio

Arboleda.

Cerda, C.,

León, M., Saiz, J. L., & Villegas, L. (2020). Medición de

propósitos de usos de tecnologías digitales en estudiantes de

pedagogía: Validación de una escala. In E. Coloma, E. Sánchez, J.

Ruiz, & J. Sánchez (Eds.), La

tecnología como eje del cambio metodológico (pp. 1239-1242). Umaeditorial.

Cerda, C.,

Saiz, J. L., Villegas, L., & León, M. (2018). Acceso, tiempo y propósito de

uso de tecnologías digitales en estudiantes de pedagogía chilenos. Estudios Pedagógicos, 44(3), 7-22. https://doi.org/10.4067/S0718-07052018000300007

Cheung, G.

W., & Rensvold, R. B. (2002). Evaluating goodness-of-fit indexes for testing measurement invariance. Structural Equation Modeling: A

Multidisciplinary Journal, 9(2),

233-255. https://doi.org/10.1207/S15328007SEM0902_5

Elosua, P.

(2003). Sobre la validez de los tests. Psicothema, 15(2),

315-321. https://reunido.uniovi.es/index.php/PST/article/view/8125

Engen, B.

(2019). Comprendiendo los aspectos culturales y sociales de las competencias

digitales docentes. Comunicar, 61, 9-19. https://doi.org/10.3916/C61-2019-01

Etikan, I., & Bala, K. (2017). Sampling and sampling methods. Biometrics

& Biostatistics International Journal, 5(6), 215-217. https://doi.org/10.15406/bbij.2017.05.00149

Farrell, A. M. (2010). Insufficient discriminant validity: A comment on

Bove, Pervan, Beatty, and Shiu (2009). Journal

of Business Research, 63(3),

324-327. https://doi.org/10.1016/j.jbusres.2009.05.003

Ferrari, A. (2013). DIGCOMP: A

framework for developing and understanding digital competence in Europe. Publications

Office of the European Union. https://doi.org/10.2788/52966

Flora, D. B., & Curran, P. J. (2004). An empirical evaluation of

alternative methods of estimation for confirmatory factor analysis with ordinal

data. Psychological Methods, 9(4), 466-491. https://doi.org/10.1037/1082-989x.9.4.466

Flores-Lueg,

C., & Roig, R. (2016). Diseño y

validación de una escala de autoevaluación de competencias digitales para

estudiantes de pedagogía. Pixel-Bit.

Revista de Medios y Educación, (48), 209-224. https://doi.org/10.12795/pixelbit.2016.i48.14

Fornell, C., & Larcker, D. F. (1981). Evaluating structural equation

models with unobservable variables and measurement error. Journal of Marketing Research,

18(1), 39-50. https://doi.org/10.2307/3151312

Fraile, M.,