Validación de una escala del Modelo

Ampliado de Aceptación de la Tecnología en el contexto dominicano

Validation of a scale of the Extended Technology Acceptance

Model in the dominican context

Dr. Clemente

Rodríguez-Sabiote. Profesor Titular de Universidad. Universidad

de Granada, España

Dr. Clemente

Rodríguez-Sabiote. Profesor Titular de Universidad. Universidad

de Granada, España

Dña. Ana Teresa

Valerio-Peña. Directora Académica. Instituto Superior de

Formación Docente, ISFODOSU, República Dominicana

Dña. Ana Teresa

Valerio-Peña. Directora Académica. Instituto Superior de

Formación Docente, ISFODOSU, República Dominicana

D.

Roberto Batista-Almonte. Coordinado del área de Ciencias Sociales

del Recinto Emilio Prud´Homme, Instituto Superior de Formación Docente,

ISFODOSU, República Dominicana

D.

Roberto Batista-Almonte. Coordinado del área de Ciencias Sociales

del Recinto Emilio Prud´Homme, Instituto Superior de Formación Docente,

ISFODOSU, República Dominicana

Recibido:

2023/03/21 Revisado: 2023/05/04 Aceptado: 2023/06/19 Preprint: 2023/07/04

Publicado: 2023/09/01

Cómo citar este artículo:

Rodríguez-Sabiote, C., Valerio-Peña, A. T., & Batista-Almonte, R.

(2023). Validación de una escala del Modelo Ampliado de Aceptación de la

Tecnología en el contexto dominicano [Validation of a scale of

the Extended Technology Acceptance Model in the dominican context].

Pixel-Bit. Revista de Medios y Educación, 68, 217-244. https://doi.org/10.12795/pixelbit.100352

RESUMEN

El fin del presente artículo ha sido adaptar y validar

una Escala del Modelo Ampliado de Aceptación de la Tecnología para su

utilización en el contexto universitario de República Dominicana. La muestra ha

ascendido a 327 estudiantes pertenecientes a diversas instituciones de

educación superior de carácter público y privado de la República Dominicana. Se

han aplicado sendos análisis factoriales, exploratorio (AFE) y confirmatorio

(AFC), análisis de fiabilidad e invarianza factorial para comprobar la equivalencia

por género. El AFE reveló la pentadimensionalidad de la escala confirmada

posteriormente por el AFC implementado. La fiabilidad como consistencia interna

también ha resultado muy alta. Finalmente, la invarianza factorial denota que

la estructura factorial es similar en hombres vs mujeres. Podemos concluir, que la escala es consistente, valida

e invariante para determinar el aprendizaje percibido en entornos virtuales de

enseñanza-aprendizaje dentro del modelo ampliado de aceptación de la tecnología

en el contexto dominicano.

ABSTRACT

The purpose of this article

was to adapt and validate a Scale of Extending the Technology Acceptance Model

for use in the university context of the Dominican Republic. The sample

consisted of 327 students from various public and private higher education

institutions in the Dominican Republic. An exploratory factor analysis (EFA)

and a confirmatory factor analysis (CFA), reliability analysis and factorial

invariance analysis were applied to check the equivalence by gender. The EFA

revealed the pentadimensionality of the scale, which was subsequently confirmed

by the implemented CFA. Reliability as internal consistency was also very high.

Finally, factorial invariance denotes that the factor structure is similar in male

vs. female. We can conclude that the scale is consistent, valid and invariant

for determining perceived learning in virtual teaching-learning environments

within extending technology acceptance model in the Dominican context.

PALABRAS CLAVES· KEYWORDS

Entornos virtuales de enseñanza-aprendizaje, modelo

ampliado de aceptación de la tecnología, propiedades psicométricas, educación

superior, estudiantes.

Virtual teaching-learning environments, extending the

technology acceptance model, psychometric properties, higher education,

students.

1. Introducción

Los Entornos Virtuales de Enseñanza-Aprendizaje[1] son ya una realidad extendida

que se ha visto reforzada, adicionalmente, a causa de la pandemia de la

Covid-19 y las nuevas necesidades educativas (Área-Moreira et al., 2020)

surgidas tras esta emergencia mundial. Es aquí donde está el origen de la

presente de investigación al tratar de ser un aporte que complemente la

literatura científica ya existente acerca de los entornos virtuales de

enseñanza-aprendizaje, pero dentro del contexto provocado por la crisis de la

Covid-19 en el alumnado que cursa sus estudios en educación superior en la

República Dominicana.

Como referente tomaremos la adaptación y validación de

un instrumento de recogida de información conformado entorno a una serie de

dimensiones (utilidad percibida, facilidad de uso, norma subjetiva e intención

de uso) relacionadas con el aprendizaje percibido en los contextos de los EVEA.

Así, la presente investigación estaría basada en un modelo teórico explicativo

constituido a partir del modelo de la aceptación de la tecnología (TAM) y

variantes posteriores como piedras angulares de nuevos modelos y metodologías

pedagógicas dentro de los EVEA.

2. Revisión de la

literatura

Existen una gran cantidad y diversidad de estudios que

evidencian una mayor presencia de nuevas metodologías y aprendizajes activos,

entre los más recientes destacamos los de Mohamed (2021); Rodríguez-Sabiote et

al. (2020); Roitsch et al. ( 2021) y Tan et al. (2021). En este contexto y

debido a la crisis provocada por la pandemia de la Covid-19 la población

mundial se ha visto obligada a sufrir periodos de confinamiento. Concretamente

en el ámbito educativo, el efecto más importante ha sido sustituir la

presencialidad de las aulas en escuelas, institutos, universidades y otros

centros de formación por aulas y entornos virtuales. De este modo, se han acelerado

los procesos que ya estaban en marcha y muchos de esos cambios e innovaciones,

que por la nueva realidad se habían instaurado en nuestro día a día,

finalmente, han llegado para quedarse. Como resultado, tanto el estudiantado,

como el profesorado se han visto obligados a una adaptación al aprendizaje en

línea y a una educación a distancia en un breve espacio de tiempo que está

dando lugar a un nuevo modelo educativo en la denominada era post-Covid

(Lockee, 2021).

Ante este panorama cobran una gran fuerza y presencia

los EVEA entendidos como “una aplicación informática diseñada para facilitar la

comunicación pedagógica entre los participantes en un proceso educativo, sea

este completamente a distancia, presencial, o de una naturaleza mixta, que

combina ambas modalidades en diversas proporciones” (Adell et al., 2004, p.4).

Es por todo ello, que se consideran una alternativa de gran potencial y

funcionalidad al poder combinar de manera eficaz y eficiente lo tecnológico y

lo pedagógico, posibilitando la realización de actividades y tareas de

aprendizaje de las distintas materias en entornos o salas virtuales en donde

tanto alumnado como profesorado visualizan y acceden a los diferentes recursos

didácticos (Báez-Estrada y Ossandón Núñez, 2015; Cabero-Almenara et al., 2022).

Sin embargo, no debemos ignorar que no todo son bondades y que existen voces

críticas hacia los EVEA. Con Saza-Garzón (2016) mostramos algunas de esas

problemáticas de los EVEA y destacamos, en primer lugar, la llamada brecha

digital (digital gap). Esta

problemática puede afectar, tanto al alumnado, cuyas condiciones económicas les

privan de los elementos tecnológicos necesarios para el buen devenir de un

proceso de enseñanza-aprendizaje en entornos virtuales, como al profesorado con

menos competencias tecnológicas; por no hablar de la actitud previa de dicho

profesorado hacia las Tecnologías de la Información y la Comunicación (TIC´s) y

de cómo dicha actitud podría ayudar a percibir de manera más positiva los EVEA

(Barroso-Osuna et al.,2018; Cabero-Almenara y Llorente-Cejudo, 2020);

Ruiz-Aquino et. al., 2022). En segundo

lugar, destacamos el compromiso ético y axiológico al que debe adherirse el

alumnado relacionado con sus prácticas de enseñanza para no caer en la

deshonestidad académica (Hodgkinson et al., 2016 y Zolfaghari, 2016).

Finalmente, destacamos la Calidad más allá del aprendizaje percibido. En este

sentido, son muchas las críticas enfocadas hacia si realmente el alumnado

aprende lo necesario desde un entorno virtual en comparación a lo que se pueda

aprender en el tradicional espacio presencial (Ferreras-García et al., 2022;

Cabero-Almenara et al.,2022).

Llegados a este punto debemos detenernos en la

compresión que el alumnado tiene sobre estos entornos educativos y la

influencia que estos ejercen sobre ellos. Así, deben tenerse en cuenta los

diferentes factores o variables que recopilan Urquidi-Martín et al. (2019), y

que pueden ser determinantes a la hora de influir en el aprendizaje percibido

de manera positiva.

·

Utilidad percibida: se trata de una variable que mide

la percepción que tienen los usuarios sobre la probabilidad subjetiva de que

mediante la utilización de una serie de herramientas específicas mejore e

incremente su productividad o rendimiento en un contexto determinado y

valorando las consecuencias de su comportamiento (Davis, 1989).

·

Facilidad de uso: dicha variable se entiende como que

el grado en el que los usuarios consideran el uso de una innovación concreta no

tiene que conducir, irremediablemente, a ningún esfuerzo añadido (Davis, 1989).

·

Norma subjetiva: Conjunto de presiones sociales que se

ejercen desde personas relevantes al alumnado que recibe sus clases en un EVEA

con el objetivo de que estos usuarios realicen una determinada acción o

comportamiento. Abdullah and Ward (2016) determinaron una correlación positiva

y estadísticamente significativa entre la Norma Subjetiva y los factores

Utilidad Percibida e Intención de Uso en el contexto del e-learning.

·

Intención de uso: esta última variable trata de medir

la percepción que el usuario tiene sobre el uso que va a realizar de una

innovación y su probable utilidad. De este modo, los EVEA pueden suponer para

los estudiantes un mayor compromiso con su propio proceso de aprendizaje (Deng

&Tavares, 2013).

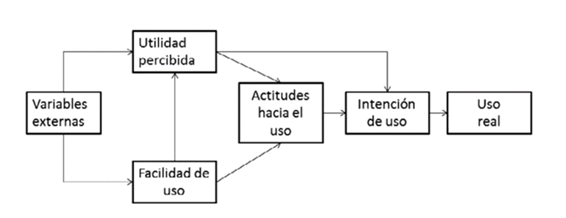

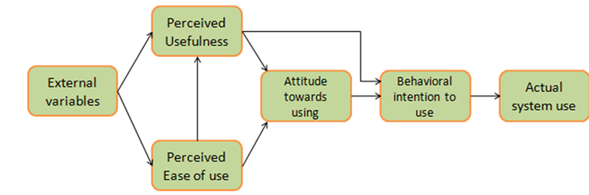

Todo lo anterior se sustenta epistemológicamente en el

modelo de aceptación tecnológica (TAM) propuesto por Davis (1989) y del que ya

avanzamos con anterioridad algunos rasgos distintivos. El modelo TAM está basado, por una parte, en la teoría de

la acción razonada (Theory of Reasoned Action-TRA-) de Azjen and

Fishbein (1980) y en la posterior teoría del comportamiento planteado (Theory of Planned Behavior-TBA-)

de Azjen (1985) que incorporaba, entre otras dimensiones, la norma subjetiva.

Acorde con estas teorías, el comportamiento de las personas se puede predecir

por las intenciones y por sus actitudes. El TAM proporciona una base teórica

para comprender y evaluar la aceptación de los usuarios hacia las nuevas

tecnologías y permite desarrollar e implementar mejores sistemas. Este modelo

presenta como variables, las anteriormente reseñadas, menos la norma subjetiva

(tomada de la TBA), es decir, utilidad percibida, facilidad de uso, actitudes

hacia el uso e intención de uso. Esquemáticamente podría describirse mediante

la siguiente figura.

Figura 1

Modelo de Aceptación de la Tecnología

Fuente: Davis (1989)

3. Metodología

3.1 Participantes

El tamaño muestral de la presente investigación asciende

a 327 estudiantes de 12 universidades o instituciones de educación superior de

carácter público y privado de la República Dominicana. Por género 258 son

mujeres y el resto, es decir, 69 son hombres con edades comprendidas entre los

17 y los 54 años (M=25.05, DT=6.79). El tipo de muestreo utilizado no obedece a

ningún tipo de muestreo específico, dado que el instrumento administrado ha

sido puesto a disposición de la población de referencia en su modalidad en

línea. La población de la que se parte está conformada, aproximadamente, por

unas 580000 unidades muestrales (estudiantes que cursan estudios superiores en

la República Dominica en el curso 2020-2021, último curso del que se tienen

datos). Para este estudio, en concreto, hemos calculado un tamaño muestral

configurado por los siguientes parámetros: nivel de significación (1-α) =

0.95; error muestral=±5% y proporciones desconocidas p=q=0.5. Una vez

establecido el tamaño muestral en aproximadamente N=385 unidades muestrales se

ha administrado el instrumento mediante la modalidad online. La atricción

muestral asciende, por tanto, a 51 unidades (15.59%), que en cualquier caso no

debe preocuparnos puesto que lo realmente capital es fijarse en la proporción

de participantes por variables (STV: subject

to variables). A este respecto debemos destacar que, en nuestro caso

particular, el cociente resultante STV= 16.35 (327/20). Si bien el valor mínimo

de STV es relativo, según el autor-a consultado-a, un valor mínimo de 10 es

aconsejable (Garson, 2008). Nuestro valor está holgadamente por encima de dicho

valor (16.35>10). Por otra parte, en el apartado de procedimiento se informa

más detalladamente sobre el proceso de recogida de información.

3.2 Instrumento de recogida

de información

El instrumento de recogida de información administrado

en nuestra investigación es una escala tipo Likert conformada por 5 categorías

de respuesta (desde 1 muy en desacuerdo… 5 muy de acuerdo), así como también 5

dimensiones y 20 items, a razón de 4 items por cada dimensión. Las dimensiones

que integran la escala son: utilidad percibida (PU), facilidad de uso percibido

(PEU), intención conductual de uso (BIU), norma subjetiva (SN) y aprendizaje

percibido (PL). Se incluyen, además, diferentes variables de identificación:

universidad o institución de educación superior a la que pertenece el

estudiante, su género y su edad. El instrumento en cuestión ha sido diseñado y

validado por Urquidi-Martín et al. (2019) y para su confección han sido tenidos

en cuenta diferentes trabajos previos: Arteaga y Duarte (2010); Davis (1989);

Islam (2013) y Premkumar and Bhattacherjee (2008) Sánchez-Prieto,

Olmos-Miguelañez, y García-Peñalvo (2016); Venkatesh and Davis (2000) y Liaw

(2008).

3.3 Procedimiento

Para la administración del instrumento de recogida de

información se ha creado un procedimiento de encuesta online mediante Google Forms. Se han recogido datos

durante los meses de enero a abril de 2022 almacenándose la información

recopilada en una hoja de cálculo Excel. En la actualidad todavía siguen

recogiéndose más datos que servirán para investigaciones futuras.

Adicionalmente, dos investigadores de campo realizaron visitas in situ a los lugares de recogida de

información con el objeto de motivar la participación de los estudiantes.

4. Análisis y

resultados

Para el análisis de los datos recopilados hemos

utilizado diversas aproximaciones. En primer lugar, un análisis previo de

naturaleza descriptiva que ha servido, además, para comprobar el supuesto de

normalidad uni y multivariante, así como la fiabilidad de la escala como

consistencia interna. En segundo lugar, hemos implementado un análisis

factorial exploratorio (AFE) con el objetivo de explorar la estructura

factorial de la escala en relación a las 5 dimensiones de partida. Antes de

desarrollarlo hemos comprobado los supuestos previos necesarios para su

aplicación, a saber, medidas de adecuación muestrales e índice de esfericidad.

En tercer lugar, para confirmar la estructura resultante de la aproximación

exploratoria, hemos calculado un análisis factorial confirmatorio (AFC). Para

finalizar, y dado el desequilibrio en los tamaños muestrales al que está

sometido nuestra muestra objeto de análisis, con un predominio del género

masculino frente al femenino, hemos calculado la invarianza factorial, por

género. En esencia el cometido de la invarianza factorial es verificar

que las propiedades de medida de los instrumentos o sus ítems, son independientes

de las características de los grupos evaluadas (en nuestro caso del género:

hombres vs mujeres), pero no del

constructo que el instrumento

está midiendo.

4.1 Análisis previo de los items

En primer lugar, para el análisis previo descriptivo de

los items (medias, desviaciones típicas y coeficientes de asimetría y curtosis)

el programa SPSS v.28 (IBM, 2021).

Tabla

1

Análisis descriptivo de los items

de la escala

|

Item |

M |

DT |

g1 |

g2 |

|

PU1 |

3.83 |

1.049 |

-.848 |

.366 |

|

PU2 |

3.83 |

1.064 |

-.862 |

.290 |

|

PU3 |

3.26 |

1.211 |

-.202 |

-.918 |

|

PU4 |

3.95 |

1.043 |

-1.036 |

.730 |

|

PEU1 |

2.87 |

1.238 |

.064 |

-1.022 |

|

PEU2 |

3.30 |

1.089 |

-.230 |

-.583 |

|

PEU3 |

3.91 |

.969 |

-.969 |

.985 |

|

PEU4 |

3.91 |

.981 |

-.927 |

.825 |

|

BIU1 |

4.03 |

1.031 |

-1.317 |

1.548 |

|

BIU2 |

3.76 |

1.037 |

-.793 |

.255 |

|

BIU3 |

3.93 |

1.176 |

-1.043 |

.297 |

|

BIU4 |

3.85 |

1.163 |

-.865 |

-.056 |

|

SN1 |

3.62 |

1.084 |

-.589 |

-.197 |

|

SN2 |

3.75 |

1.070 |

-.703 |

.071 |

|

SN3 |

3.84 |

1.049 |

-.973 |

.671 |

|

SN4 |

3.36 |

1.153 |

-.243 |

-.811 |

|

PL1 |

4.01 |

1.000 |

-1.117 |

1.158 |

|

PL2 |

3.55 |

1.072 |

-.575 |

-.013 |

|

PL3 |

4.07 |

1.035 |

-1.276 |

1.449 |

|

PL4 |

3.91 |

1.115 |

-.954 |

.325 |

Nota: M= Media; DT:Desviación Típica; g1= asimetría; g2= curtosis.

Fuente: Elaboración propia.

Como puede apreciarse a nivel descriptivo los items han

conseguido medias entre 3 y 4 (categorías de respuesta entre algo de acuerdo y de acuerdo), excepto en

el caso particular PEU1 (M=2.87). Recordemos que el enunciado de este item

sentencia: “Utilizar un Entorno Virtual de Enseñanza-Aprendizaje no me

supone mucho esfuerzo mental”. En

el nivel totalmente opuesto situamos al ítem PL3: “El empleo de los Entornos Virtuales de Enseñanza-Aprendizaje me

proporciona flexibilidad para aprender en mi tiempo libre” con una M=4.07.

En cuanto a la dispersión de los ítems todos han logrado desviaciones típicas

cercanas a 1 o ligeramente inferiores y superiores a dicho valor. Por lo que

respecta a la simetría la mayoría de ítems han conseguido valores negativos, lo

que denota ligeras concentraciones de valores en la parte alta de las diversas

curvas con apuntamientos que oscilan entre los valores cercanos a 0 hasta 1.5. Con

estos datos podemos concluir que la normalidad univariante está garantizada, si

tenemos en cuenta que valores entre ±1 se consideran excelentes, mientras que

valores inferiores a 1.60, adecuados (George & Mallery, 2011) o inferiores

a 2 para la asimetría y entre 2 a 7 para el apuntamiento (Curran et al.,1996).

Para la comprobación de la normalidad multivariante se

han calculado diferentes coeficientes mediante el programa STATA v.17

(StataCorp,2021), exactamente el coeficiente de Mardia para asimetría y curtosis,

así como los de Henze-Zikler y el de Doornik-Hansen. Para el primer coeficiente

se han obtenido valores de Mardia mSkewness

= 71.10 (p<.001) y Mardia mKurtosis

= 574.21 (p<.001). Por su parte, el coeficiente de Henze-Zikler =1.61

(p<.001) y el de Doornik-Hansen=463.84 (p<.001). En todos los casos las

significaciones estadísticas obtenidas (p<.001) apuntan al no cumplimiento

del supuesto de normalidad multivariante. Por esta razón y como apreciaremos

cuando lleguemos al análisis factorial confirmatorio hemos estimado el modelo

resultante a través del procedimiento de Máxima Verosimilitud. Si bien este

procedimiento exige la presencia de asimetría univariante, existe la

posibilidad de ser un procedimiento plausible para obtener cargas factoriales,

aun incumpliéndose el supuesto de normalidad multivariante (Beaducel &

Herzberg, 2006).

4.2 Fiabilidad de la escala

Para determinar la fiabilidad de la escala como

consistencia interna, dado que tenemos una sola administración, hemos calculado

el coeficiente de ω de Mc

Donald, tanto a cada una de las 5 subescalas de la prueba con a la totalidad de

la misma. Los resultados obtenidos son los siguientes.

Tabla

2

Valores de ω de Mc Donald de

la escala y las subescalas que la conforman.

|

Subescalas |

ω de Mc Donald |

IC |

|

Subescala PU |

.830 |

[.799,.860] |

|

Subescala PEU |

.652 |

[.613,.727] |

|

Subescala BIU |

.897 |

[.879,.916] |

|

Subescala SN |

.870 |

[.847,.893] |

|

Subescala PL |

.831 |

[.801,.860] |

|

Total escala |

.947 |

[.939,.956] |

Fuente:

Elaboración propia.

Como puede apreciarse el valor de ω de Mc Donald de la escala en su totalidad ha sido de

ω=.947. Por subescalas los valores obtenidos van desde ω=.652 para la subescala PEU (dificultad

de uso percibido) hasta .897 para la subescala BIU (intención conductual de

uso). Con Katz (2006) podemos afirmar que valores superiores a 0.65 (ω>.65) denotan una fiabilidad

aceptable. En nuestro caso, apreciamos que todos están por encima de ese valor

y que, además, exceptuando el caso de la dimensión de dificultad de uso

percibido, los valores del coeficiente ω

están entre .80-.95

4.3 Análisis factorial

exploratorio

En primer lugar describimos las características del Análisis

factorial exploratorio implementado. El método de extracción utilizado ha sido

el de componentes principales con rotación tipo Vaximax que ha convergido en 8

iteraciones. Finalmente, el criterio utilizado para la selección de los

factores ha sido el conocido como criterio a

priori. En nuestro caso particular la propuesta de 5 factores. Como paso previo a la implementación del

Análisis Factorial Exploratorio (AFE) hemos calculado un conjunto de medidas

acerca de su idoneidad. En primer lugar, presentamos el determinante de la

matriz IAI = 0.000104. Este dato nos

revela que la matriz no es una matriz singular, dado que aunque su valor se

aproxima a 0 no llega a dicho valor y, por tanto, las variables no son

linealmente dependientes.

En segundo lugar, presentamos el valor del coeficiente

de adecuación muestral global de Kaiser-Meyer-Olkin (KMO= .954), una medida

excelente que garantiza que los pares de correlaciones entre las variables son

mucho más importantes que las correlaciones parciales entre las mismas (Klein,

2013 y Vogt, 2005).En cuanto a las medidas de adecuación muestral individuales

(Measure Sampling Adequacy-MSA-) en la mayoría de casos han

alcanzado valores MSA>.90. Teniendo en cuenta que valores de MSA> .50 se

pueden considerar satisfactorios (Lorenzo & Ferrando, 2021) las 20 medidas

de adecuación muestral individual calculadas pueden considerarse como muy

satisfactorias.

Finalmente, el índice de

esfericidad de Bartlett ha logrado un valor de χ²= 4372.092 (gl=190,

p=.000). Valores del índice de

esfericidad de Bartlett asociados a probabilidades p>.05 no se consideran

adecuados. En nuestro caso, el valor de probabilidad asociado al estadístico de

Bartlett es p<.001, lo que significa que la matriz resultante no es una

matriz identidad y existen correlaciones entre las variables más allá de la

diagonal de dicha matriz.

Por lo que respecta a los

resultados del Análisis Factorial Exploratorio en la siguiente tabla

presentamos los principales resultados a este respecto.

Como puede apreciarse la solución factorial resultante

ha logrado una varianza explicada del 72.61%. Por factores destaca la dimensión

de norma subjetiva con un λ1=5.37

y una varianza explicada del 26.87%, seguida por la utilidad percibida (λ2=3.09

y 15.45% varianza explicada), aprendizaje percibido (λ3=2.23 y 11.16% varianza explicada), facilidad de

uso (λ4=2.20 y 11.03%

varianza explicada) e intención conductual de uso (λ5=1.62 y

8.10% varianza explicada). Por su parte, las variables están muy bien

representadas en la solución factorial con comunalidades que oscilan entre .606

(BIU 2) y 0.784 (PL4).

Tabla

3

Matriz de componente rotado*.

|

Item |

Factores |

|

||||

|

1 |

2 |

3 |

4 |

5 |

h2 |

|

|

PU1 |

|

.748 |

|

|

|

.776 |

|

PU2 |

|

.705 |

|

|

|

.774 |

|

PU3 |

|

.337 |

|

|

|

.690 |

|

PU4 |

|

.678 |

|

|

|

.729 |

|

PEU1 |

|

|

|

.302 |

|

.789 |

|

PEU2 |

|

|

|

.666 |

|

.654 |

|

PEU3 |

|

|

|

.645 |

|

.745 |

|

PEU4 |

|

|

|

.720 |

|

.752 |

|

BIU1 |

|

|

|

|

.681 |

.740 |

|

BIU2 |

|

|

|

|

.390 |

.606 |

|

BIU3 |

|

|

|

|

.881 |

.737 |

|

BIU4 |

|

|

|

|

.363 |

.759 |

|

SN1 |

.793 |

|

|

|

|

.730 |

|

SN2 |

.717 |

|

|

|

|

.702 |

|

SN3 |

.732 |

|

|

|

|

.713 |

|

SN4 |

.741 |

|

|

|

|

.701 |

|

PL1 |

|

|

.329 |

|

|

.687 |

|

PL2 |

|

|

.740 |

|

|

.745 |

|

PL3 |

|

|

.583 |

|

|

.713 |

|

PL4 |

|

|

.700 |

|

|

.784 |

|

λn |

λ1=5.37 |

λ2=3.09 |

λ3=2.23 |

λ4=2.20 |

λ5=1.62 |

|

|

%σ² |

26.87% |

15.45% |

11.16% |

11.03% |

8.10% |

|

Nota: *Se muestran sólo cargas factoriales r>.30

4.4 Análisis factorial

confirmatorio

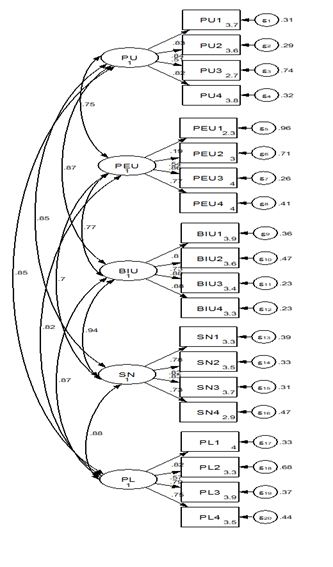

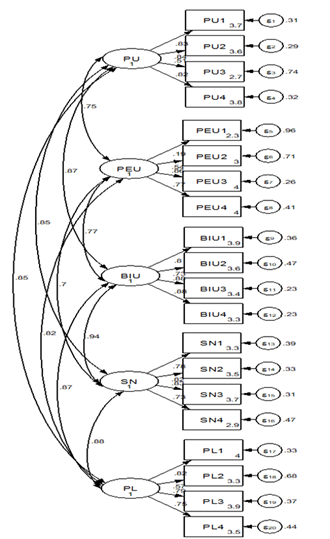

Para la confirmación de la estructura factorial

inferida mediante el análisis factorial exploratorio se ha implementado un

análisis factorial confirmatorio con un estructura pentadimensional mediante el

programa STATA v.17 (StataCorp, 2021). A este respecto, en primer lugar,

presentamos la estructura factorial de la escala de medición del modelo

ampliado de aceptación de la tecnología.

Figura 2

Diagrama

de Sendas sobre la estructura factorial de la Escala de Medición del Modelo

Ampliado de Aceptación de la Tecnología

Fuente: Elaboración propia a través

del programa STATA v.17.

Como puede apreciarse el diagrama de sendas que

representa la estructura factorial de la Escala de Medición del Modelo Ampliado

de Aceptación de la Tecnología parece confirmar la estructura inicial de 5

factores inferida mediante el análisis factorial exploratorio. En el mismo

pueden apreciarse las diferentes cargas factoriales estandarizadas que cada

factor ha obtenido en las diversas variables que lo conforman y que van desde

un valor mínimo λ21 =

.19 (para PEU→PEU1) hasta un valor máximo λ33 y λ34 = .88 (para BIU→BIU3

y para BIU→BIU4). En general, exceptuando el caso de la carga

factorial de .19 el resto han logrado fuertes cargas factoriales (Costello

& Osborne, 2005).

Por otra parte, con Byrne

(2008), Byrne (2009) y Hu and Bentler

(1999) podemos afirmar que el modelo ha obtenido medidas de bondad de ajuste

aceptables, a saber χ²

(160 gl)=

465.890; χ²/gl= 2.91; CFI=.929; SRMR=.05; RMSEA=.07 [.06,.08].

Tabla

4

Medidas de bondad de ajuste del modelo inferido

|

Modelo de 5 factores |

χ² |

χ²/gl |

CFI |

SRMR |

RMSEA (IC 90%) |

|

|

465.890 |

2.91 |

.929 |

.05 |

.077 [.069,.085] |

Elaboración propia.

4.5 Invarianza factorial por

género

Como ya avanzamos en otro apartado nuestra muestra está

desequilibrada de acuerdo con la variable género. El número de unidades

muestrales de género femenino triplica al masculino. Por esta razón, hemos

implementado el cálculo de la invarianza factorial. Para este fin hemos

utilizado 4 procedimientos o modelos diferentes, a saber: configuracional (M1),

métrico (M2), escalar (M3) y estricto (M4)

tomando en consideración solo las medidas de ajuste CFI (Comparative Fix Index) o Índice de Ajuste Comparativo, así como

RSMEA (Root Mean Square Error of

Approximation) o Error cuadrático promedio de aproximación. Los resultados

se muestran en la tabla inmediatamente siguiente.

Tabla 5

Invarianza

de medición de la escala de medición del modelo de aceptación de la tecnología

|

Modelos |

CFI |

RMSEA |

ΔCFI |

ΔRMSEA |

|

Configuracional |

.929 |

.077 |

- |

- |

|

Métrico |

.910 |

.086 |

.019 |

.009 |

|

Escalar |

.907 |

.085 |

.003 |

.001 |

|

Estricto |

.900 |

.086 |

.007 |

.001 |

Fuente: Elaboración propia

Para la interpretación de los resultados obtenidos

tenemos que partir de que ΔCFI debe ser ≤.01 y ΔRMSEA deber ser

≤.015 (Chen, 2007; Cheung & Rensvold, 2002). Sólo esos resultados son

indicadores del cumplimiento de la invarianza factorial. Con mayor detalle

apreciamos como en el caso del modelo configuracional hemos obtenido un

CFI=.929 y un RMSEA= .077, lo cual permite aceptar el modelo inferido. En

relación al modelo métrico apreciamos el único incumplimiento en el caso de

ΔCFI =.019>0.01, no así en el caso de ΔRMSEA=.009<.015. Para el

modelo escalar (invarianza de interceptos), tanto ΔCFI =.003<0.01, como

ΔRMSEA=.001<.015 cumplen con el criterio de invarianza factorial.

Finalmente, en el modelo estricto, tanto ΔCFI =.007<0.01, como

ΔRMSEA=.001<.015 también cumplen con el criterio de invarianza

factorial.

5. Discusión de datos

Si bien actualmente la situación pandémica por la

presencia de la covid-19 ha mejorado ostensiblemente, no podemos darla por

finalizada en su totalidad. De facto, la presencia de variantes del virus

SARS-CoV-2 cada vez más contagiosas y que escapan a la inmunidad de las vacunas

puede provocar un nuevo aumento exponencial de los casos y, por consiguiente,

la toma de medidas de prevención, en las que de nuevo podrían incluirse el regreso

a las enseñanzas no presenciales o semipresenciales. En este contexto, por

consiguiente, parece oportuno seguir proponiendo EVEA en los niveles de

educación superior que, no sólo deben existir por razones de urgencia (Bozkurt et al., 2020), sino sobre todo

porque pueden ser una oportunidad para transformar la pandemia sanitaria en un

proceso de enseñanza-aprendizaje de calidad ( González-Villa

et al., 2022). Este escenario puede ser el lugar adecuado donde el

alumnado adquiera toda una gama de

competencias compatibles con una sociedad altamente digitalizada (Área-Moreira

et al., 2020). A todo ello debemos añadir que, además, los EVEA ya poseían un

fuerte arraigo en la sociedad actual

(Hassani et al., 2022; Infante-Moro et al., 2022) por lo cual son una

estrategia que parece haber venido para quedarse.

6. Conclusiones del

estudio

El presente trabajo tiene como objetivo fundamental

analizar la evidencia de validez de constructo, fiabilidad de las puntuaciones

e invarianza factorial de acuerdo con el género de una Escala de Medición del

Modelo Ampliado de Aceptación a la Tecnología (EMMAAT) en una muestra de estudiantes de educación

superior de la República Dominicana. A este respecto, debemos destacar que los

principales hallazgos sugieren que la escala

debe ser interpretada como una escala conformada en torno a 5 factores o

dimensiones, con una adecuada fiabilidad como consistencia interna y donde la

invarianza factorial de acuerdo con el género ha sido garantizada.

La validación de constructo de la escala se ha

implementado mediante el cálculo de sendos análisis factoriales (exploratorio y

confirmatorio). El primer análisis factorial de naturaleza exploratoria ha

inferido una estructura factorial de tipo pentadimensional coincidente con la

escala original de Urquidi-Martín et al. (2019). En ambos casos, además, las

unidades muestrales objeto de estudio han sido estudiantes de educación superior

de España y República Dominicana, respectivamente. Por su parte, el análisis factorial

confirmatorio ha refrendado dicha estructura lográndose adecuadas medidas de

ajuste.

En cuanto a la fiabilidad de las puntuaciones como

consistencia interna debemos recordar que la escala en su conjunto ha obtenido

un valor muy alto, así como sus respectivas dimensiones, si exceptuamos el caso

de la dimensión de dificultad del uso percibido. Y esto puede haber ocurrido

porque como se demuestra en algunos estudio, entre otros los de Schepers and

Wetzels (2007) y Venkatesh and Davis (2000), la dificultad de uso de la

tecnología no parece ser un elemento clave en el modelo de aceptación de la

tecnología y sus variantes posteriores. No obstante, estos resultados relacionados

con la fiabilidad del instrumento apoyan la presencia de una escala altamente

consistente y estable.

Por lo que respecta a la presencia del fuerte

desequilibrio muestral por razón de género se revisó la invarianza de medida

de acuerdo a dicha variable con el objeto de no llegar a conclusiones sesgadas

tras el desarrollo del análisis factorial confirmatorio. Los resultados

obtenidos tras el desarrollo de la invarianza factorial revelaron que la estructura

pentadimensional resulta equivalente, tanto para hombres, como para mujeres. En

ese sentido, se puede afirmar que la estructura factorial resultante es sólida

y robusta para ambos y no presenta sesgo hacia alguno de estos grupos. Estos

resultados apoyan que el instrumento

validado es acreedor de la invarianza factorial por razón de género (Van De

Schoot et al., 2015).

7. Limitaciones del estudio

Sin menoscabo de todo lo anterior el estudio presenta ciertas

limitaciones de naturaleza metodológica y a tomar en consideración. En primer

lugar, al tratarse de un estudio que todavía se encuentra en desarrollo,

creemos que un tamaño muestral más amplio en el futuro ayudará a reducir las

distancias que median entre las medidas de los estadísticos y los parámetros de

referencia. En segundo lugar, podemos señalar como una limitación también la

selección no probabilista de la población de estudio. De haberse seguido este

procedimiento hubiera sido posible limitar el desequilibrio muestral por razón

de género. No obstante, no es menos cierto que, el cumplimiento de la

invarianza factorial ha corregido esta amenaza, aunque será un aspecto a tener

en cuenta en la próxima investigación que se desarrollará en breve con una

muestra más amplia. Dicha investigación tendrá como cometido confirmar un

modelo de mediación serial múltiple con dos variables, a saber, la utilidad

percibida en el uso de un EVEA y el aprendizaje percibido tomando en

consideración la mediación de la norma subjetiva, la facilidad de uso y la

intención de uso bajo la fundamentación de un modelo ampliado de aceptación de

la tecnología.

8. Financiación

El presente trabajo forma parte de un proyecto de

investigación financiado por el ISFODOSU (Instituto Superior de Formación

Docente Salomé Ureña) de la República Dominicana con referencia VRI-INV-G-2020-26 y titulado “Utilidad y competencias percibidas por

estudiantes universitarios dominicanos en Entornos Virtuales de Aprendizaje: un

análisis de mediación serial”.

Validation of a scale of the Extended Technology Acceptance Model in the

dominican context

1. Introduction

Virtual Teaching-Learning Environments

(VLEs) are already an established reality that has been further reinforced due

to the Covid-19 pandemic and the new educational needs (Área-Moreira et al.,

2020) that have arisen as a result of this global emergency. This is the

starting point of the present research, aiming to complement the existing

scientific literature on virtual teaching-learning environments within the

context of the Covid-19 crisis among students pursuing higher education in the

Dominican Republic.

As a reference, we will

consider the adaptation and validation of an information gathering instrument

composed of a series of dimensions (perceived usefulness, ease of use,

subjective norms, and intention to use) related to perceived learning (PL) in

VLE contexts. Thus, the present research is based on an explanatory theoretical

model built upon the Technology Acceptance Model (TAM) and subsequent

variations, which serve as cornerstones for new models and pedagogical

methodologies within VLEs.

2. Literature Review

There is a great amount and

diversity of studies that evidence a greater presence of new methodologies and

active learning. Among the most recent ones, notable examples include those by

Mohamed (2021), Rodríguez-Sabiote et al. (2020), Roitsch et al. (2021), and Tan

et al. (2021). In this context, and due to the crisis caused by the Covid-19

pandemic, the global population has been forced to endure periods of

confinement. Specifically in the educational field, the most significant effect

has been the replacement of in-person classrooms in schools, institutes,

universities, and other educational centers with virtual classrooms and

environments. Thus, the processes that were already underway have been

accelerated, and many of these changes and innovations that had been established

in our daily lives due to the new reality have finally come to stay. As a

result, both students and teachers have been compelled to adapt to online

learning and distance education within a short period of time, giving rise to a

new educational model in the so-called post-Covid era (Lockee, 2021).

In light of this panorama, VLEs gain significant strength and presence. VLEs are

understood as "software applications designed to facilitate pedagogical

communication among participants in an educational process, whether it is

completely remote, in-person, or of a mixed nature, combining both modalities

in various proportions" (Adell et al., 2004, p.4). For all these reasons,

VLEs are considered a highly potential and functional alternative as they effectively

and efficiently combine technology and pedagogy, enabling the execution of

learning activities and tasks in various subjects within virtual environments

or classrooms, where both students and teachers visualize and access different

educational resources (Báez-Estrada & Ossandón

Núñez, 2015; Cabero-Almenara et al., 2022). However, we must not ignore the

fact that not everything is advantageous, and there are critical voices

regarding VLEs. With Saza-Garzón (2016), we present some of the issues

associated with VLEs, highlighting the so-called digital gap as the first

concern. This issue can affect both students, whose economic conditions deprive

them of the necessary technological elements for a successful teaching-learning

process in virtual environments, and teachers with fewer technological

competencies. Not to mention the prior attitude of these teachers towards

Information and Communication Technologies (ICTs) and how this attitude could

contribute to a more positive perception of VLEs (Barroso-Osuna et al., 2018;

Cabero-Almenara & Llorente-Cejudo, 2020; Ruiz-Aquino et al., 2022).

Secondly, we emphasize the ethical and axiological commitment that students

must adhere to regarding their teaching practices, to avoid academic dishonesty

(Hodgkinson et al., 2016; Zolfaghari, 2016). Finally, we highlight Quality

beyond PL. In this regard, there are many criticisms focused on whether

students really learn what is necessary within a virtual environment compared

to what can be learned in a traditional face-to-face setting (Ferreras-García

et al., 2022; Cabero-Almenara et al., 2022).

At this point, we need to

focus on the understanding that students have about these educational

environments and the influence they exert on them. Therefore, it is important

to consider the different factors or variables compiled by Urquidi-Martín et

al. (2019) that can be decisive in positively influencing PL.

Perceived usefulness (PU):

This variable measures users' perception of the subjective likelihood that

their productivity or performance will improve by using specific tools in a

given context and evaluating the consequences of their behavior (Davis, 1989).

Ease of use: This variable

refers to the extent to which users consider the use of a specific innovation

to require no additional effort (Davis, 1989).

Subjective norm (SN): It

represents the social pressures exerted by relevant individuals on students who

receive their classes in a VLE with the aim of influencing these users to

perform a certain action or behavior. Abdullah and Ward (2016) found a positive

and statistically significant correlation between SN and the factors of PU and

Intention to Use in the context of e-learning.

Intention to use: This

variable measures the user's perception of the intended use and probable utility

of an innovation. VLEs can lead to greater commitment to the students' own

learning process (Deng & Tavares, 2013).

All of the above is

epistemologically supported by the TAM proposed by Davis (1989), of which we

have previously mentioned some distinctive features. The TAM is based on the

Theory of Reasoned Action (TRA) by Ajzen and Fishbein (1980) and the subsequent

Theory of Planned Behavior (TPB) by Ajzen (1985), which incorporated dimensions

such as SN. According to these theories, people's behavior can be predicted by

their intentions and attitudes. The TAM provides a theoretical basis for

understanding and evaluating user acceptance of new technologies and allows for

the development and implementation of better systems. This model includes the

aforementioned variables, except for SN (taken from the TPB), namely perceived

usefulness, ease of use, attitudes toward use, and intention to use. The model

can be schematically described using the following figure.

Figure 1

Technology Acceptance Model

Source: Davis (1989)

3. Method

3.1 Participants

The sample size of the present

study consisted of 327 students from 12 public and private universities or

higher education institutions in the Dominican Republic. Of the participants,

258 were women and the remaining 69 were men, with ages ranging from 17 to 54

years (M=25.05, SD=6.79). The sampling method used does not follow a specific

sampling technique, as the administered instrument was made available to the

target population in an online format. The target population is approximately

580,000 individuals (students enrolled in higher education in the Dominican

Republic in the 2020-2021 academic year, which is the latest year for which

data is available). For this particular study, the sample size was determined

based on the following parameters: significance level (1-α) = 0.95, sampling error = ±5%, and unknown proportions p=q=0.5. After

considering these parameters, a sample size of approximately N=385 was

determined, and the instrument was administered online. The sample attrition

amounted to 51 participants (15.59%), which should not be a cause for concern

since the focus is primarily on the proportion of participants per variable

(STV: subject to variables). In our particular case, the resulting STV quotient

is 16.35 (327/20). While the minimum value of STV is relative and depends on

the consulted author, a minimum value of 10 is advisable (Garson, 2008). Our

value comfortably exceeds this threshold (16.35>10). Furthermore, the data

collection process is further explained in detail in the Procedure section

3.2 Data Collection Instrument

The data collection instrument

used in our research is a Likert-type scale consisting of 5 response categories

(ranging from 1 - strongly disagree... 5 - strongly agree), with 5 dimensions

and 20 items in total, with 4 items per dimension. The dimensions included in

the scale are: PU, perceived ease of use (PEU), behavioral intention to use

(BIU), SN, and PL. The instrument also includes various identification

variables, such as the university or higher education institution to which the

student belongs, their gender, and their age. The instrument was designed and

validated by Urquidi-Martín et al. (2019), and previous works by Arteaga and

Duarte (2010), Davis (1989), Najmul Islam (2013), Premkumar and Bhattacherjee

(2008), Sánchez-Prieto, Olmos-Miguelañez, and García-Peñalvo (2016), Venkatesh

and Davis (2000), and Liaw (2008) were taken into account during its

development.

3.3 Procedure

For the administration of the

data collection instrument, an online survey procedure was created using Google

Forms. Data was collected from January to April 2022, and the collected

information was stored in an Excel spreadsheet. Currently, additional data is

still being collected for future research purposes. Additionally, two field

researchers conducted on-site visits to the data collection locations in order

to encourage student participation.

4. Analysis and Results

For the analysis of the

collected data, we have used various approaches. Firstly, we conducted a

preliminary descriptive analysis, which also served to check the assumptions of

univariate and multivariate normality, as well as the reliability of the scale

as internal consistency. Secondly, we performed an EFA to explore the factorial

structure of the scale in relation to the 5 underlying dimensions. Before

conducting the EFA, we checked the necessary assumptions, such as sample

adequacy measures and the sphericity index. Thirdly, to confirm the resulting

structure from the exploratory approach, we conducted a CFA. Finally, due to the

imbalance in the sample sizes, with a higher proportion of males compared to

females, we conducted factorial invariance testing by gender. The purpose of

factorial invariance is to verify that the measurement properties of the

instrument or its items are independent of the evaluated group characteristics

(in our case, gender: male vs female), but not independent of the construct

that the instrument is measuring.

4.1 Preliminary analysis of

the items

Firstly, for the descriptive

preliminary analysis of the items (means, standard deviations, skewness, and

kurtosis coefficients), we used the SPSS program v.28 (IBM, 2021).

As can be noted from the

descriptive analysis, the items obtained means between 3 and 4 (response

categories ranging from somewhat disagree to agree), except for the specific

item PEU1 (M=2.87). Recall that the statement of this item states: "Using

a Virtual Teaching-Learning Environment does not require much mental

effort." At the opposite end, we have item PL3: "The use of Virtual

Teaching-Learning Environments provides me with flexibility to learn in my free

time" with M=4.07. Regarding the dispersion of the items, all of them

achieved standard deviations close to 1 or slightly above and below that value.

As for skewness, most items obtained negative values, indicating slight

concentrations of values in the upper part of the various curves, with kurtosis

ranging from values close to 0 up to 1.5. Based on these data, we can conclude

that univariate normality is guaranteed, considering that values between ±1 are

considered excellent, while values below 1.60 are considered adequate (George

& Mallery, 2011) for skewness, and values below 2 for skewness and between

2 to 7 for kurtosis (Curran et al., 1996).

Table 1

Descriptive analysis of the scale items

|

Item |

M |

SD |

g1 |

g2 |

|

PU1 |

3.83 |

1.049 |

-.848 |

.366 |

|

PU2 |

3.83 |

1.064 |

-.862 |

.290 |

|

PU3 |

3.26 |

1.211 |

-.202 |

-.918 |

|

PU4 |

3.95 |

1.043 |

-1.036 |

.730 |

|

PEU1 |

2.87 |

1.238 |

.064 |

-1.022 |

|

PEU2 |

3.30 |

1.089 |

-.230 |

-.583 |

|

PEU3 |

3.91 |

.969 |

-.969 |

.985 |

|

PEU4 |

3.91 |

.981 |

-.927 |

.825 |

|

BIU1 |

4.03 |

1.031 |

-1.317 |

1.548 |

|

BIU2 |

3.76 |

1.037 |

-.793 |

.255 |

|

BIU3 |

3.93 |

1.176 |

-1.043 |

.297 |

|

BIU4 |

3.85 |

1.163 |

-.865 |

-.056 |

|

SN1 |

3.62 |

1.084 |

-.589 |

-.197 |

|

SN2 |

3.75 |

1.070 |

-.703 |

.071 |

|

SN3 |

3.84 |

1.049 |

-.973 |

.671 |

|

SN4 |

3.36 |

1.153 |

-.243 |

-.811 |

|

PL1 |

4.01 |

1.000 |

-1.117 |

1.158 |

|

PL2 |

3.55 |

1.072 |

-.575 |

-.013 |

|

PL3 |

4.07 |

1.035 |

-1.276 |

1.449 |

|

PL4 |

3.91 |

1.115 |

-.954 |

.325 |

Note: M= Mean; SD: Standard Deviation; g1= Skewness; g2= Kurtosis.

Source: Authors' own elaboration.

For the verification of multivariate

normality, different coefficients have been calculated using the STATA program

v.17 (StataCorp, 2021). Specifically, the Mardia coefficient for skewness and

kurtosis, as well as the Henze-Zikler and Doornik-Hansen coefficients. For the

Mardia coefficient, the values obtained are Mardia mSkewness = 71.10

(p<.001) and Mardia mKurtosis = 574.21 (p<.001). As for the Henze-Zikler

coefficient, it is 1.61 (p<.001), and for the Doornik-Hansen coefficient, it

is 463.84 (p<.001). In all cases, the obtained statistical significances

(p<.001) indicate a failure to meet the assumption of multivariate

normality. For this reason, as we will see when we get to the confirmatory

factor analysis, we have estimated the resulting model using the Maximum

Likelihood procedure. Although this procedure requires the presence of

univariate skewness, it is still a plausible approach to obtain factor loadings

even when the assumption of multivariate normality is violated (Beaducel &

Herzberg, 2006).

4.2 Scale reliability

To determine the internal

consistency reliability of the scale, given that we have a single

administration, we have calculated the coefficient McDonald's ω value for each of the 5 subscales of the test and for the entire scale.

The obtained results are as follows.

Table 2

McDonald's ω values of the scale and its

subscales

|

Subscales |

McDonald's ω value |

IC |

|

Subscale PU |

.830 |

[.799,.860] |

|

Subscale PEU |

.652 |

[.613,.727] |

|

Subscale BIU |

.897 |

[.879,.916] |

|

Subscale SN |

.870 |

[.847,.893] |

|

Subscale PL |

.831 |

[.801,.860] |

|

Total Scale |

.947 |

[.939,.956] |

Source: Own elaboration

As can be seen, the McDonald's

ω value for the entire scale was ω=.947. For the subscales, the

obtained values ranged from ω=.652 for the PEU subscale to .897

for the BIU subscale (behavioral intention to use). According to Katz (2006),

values above 0.65 (ω>.65) indicate acceptable

reliability. In our case, we observe that all values are above that threshold,

and, except for the PEU dimension, the ω coefficient values range from

.80-.95.

4.3 Exploratory Factor

Analysis (EFA)

First, we will describe the

characteristics of the implemented EFA. The extraction method used was

principal component analysis with Varimax rotation, which converged in 8

iterations. Finally, the criterion used for factor selection was the a priori

criterion, specifically proposing 5 factors. As a preliminary step to

implementing the EFA, we calculated a set of measures regarding its

suitability. First, we present the determinant of the IAI matrix = 0.000104.

This value reveals that the matrix is not singular, as it approaches but does

not reach 0, indicating that the variables are not linearly dependent.

Second, we present the value

of the Kaiser-Meyer-Olkin (KMO) measure of sampling adequacy, with a value of

KMO= .954, an excellent measure that guarantees that the pairwise correlations

between variables are much more important than the partial correlations among

them (Klein, 2013 and Vogt, 2005). Regarding the individual measures of sampling

adequacy (MSA), in most cases, they reached MSA values >.90. Considering

that MSA values >.50 can be considered satisfactory (Lorenzo & Ferrando,

2021), the 20 calculated individual measures of sampling adequacy can be

considered very satisfactory.

Finally, the Bartlett's test

of sphericity yielded a value of χ²= 4372.092 (df=190, p=.000). Values of the Bartlett's test of

sphericity associated with p>.05 are not considered adequate. In our case,

the p-value associated with the Bartlett's test statistic is p<.001, which

means that the resulting matrix is not an identity matrix and there are

correlations between variables beyond the diagonal of that matrix.

Regarding the results of the

EFA, the main findings are presented in the following table.

Table 3

Rotated Component Matrix*

|

Item |

Factors |

|

||||

|

1 |

2 |

3 |

4 |

5 |

h2 |

|

|

PU1 |

|

.748 |

|

|

|

.776 |

|

PU2 |

|

.705 |

|

|

|

.774 |

|

PU3 |

|

.337 |

|

|

|

.690 |

|

PU4 |

|

.678 |

|

|

|

.729 |

|

PEU1 |

|

|

|

.302 |

|

.789 |

|

PEU2 |

|

|

|

.666 |

|

.654 |

|

PEU3 |

|

|

|

.645 |

|

.745 |

|

PEU4 |

|

|

|

.720 |

|

.752 |

|

BIU1 |

|

|

|

|

.681 |

.740 |

|

BIU2 |

|

|

|

|

.390 |

.606 |

|

BIU3 |

|

|

|

|

.881 |

.737 |

|

BIU4 |

|

|

|

|

.363 |

.759 |

|

SN1 |

.793 |

|

|

|

|

.730 |

|

SN2 |

.717 |

|

|

|

|

.702 |

|

SN3 |

.732 |

|

|

|

|

.713 |

|

SN4 |

.741 |

|

|

|

|

.701 |

|

PL1 |

|

|

.329 |

|

|

.687 |

|

PL2 |

|

|

.740 |

|

|

.745 |

|

PL3 |

|

|

.583 |

|

|

.713 |

|

PL4 |

|

|

.700 |

|

|

.784 |

|

λn |

λ1=5.37 |

λ2=3.09 |

λ3=2.23 |

λ4=2.20 |

λ5=1.62 |

|

|

%σ² |

26.87% |

15.45% |

11.16% |

11.03% |

8.10% |

|

Note: *Only factor loadings r>.30 are shown.

As can be seen, the resulting

factor solution has achieved an explained variance of 72.61%. Among the factors,

the SN dimension stands out with a λ1 of 5.37 and an explained

variance of 26.87%, followed by PU (λ2=3.09 and 15.45% explained

variance), PL (λ3=2.23 and 11.16% explained

variance), ease of use (λ4=2.20 and 11.03% explained

variance), and BIU (λ5=1.62 and 8.10% explained

variance). Furthermore, the variables are well represented in the factor

solution, with communalities ranging from .606 (BIU 2) to 0.784 (PL4).

4.4 Confirmatory Factor

Analysis (CFA)

To confirm the factor

structure inferred through the exploratory factor analysis, a CFA with a

pentadimensional structure was conducted using STATA v.17 (StataCorp, 2021). In

this regard, first, we present the factor structure of the measurement scale

for the extended TAM.

Figure 2

Path diagram of the factorial structure of the Measurement Scale for the

Extended Technology Acceptance Model

Source: Own elaboration using STATA v.17

As can be seen, the path

diagram representing the factorial structure of the Measurement Scale for the Extended

TAM appears to confirm the initial 5-factor structure inferred through

exploratory factor analysis. The diagram displays the standardized factor

loadings that each factor obtained on the various variables comprising it,

ranging from a minimum value of λ21=.19 (for PEU→PEU1) to

a maximum value of λ33 and λ34=.88 (for BIU→BIU3 and BIU→BIU4). Overall, except for the

factor loading of .19, the remaining loadings have achieved strong factor

loadings (Costello & Osborne, 2005).

Furthermore, following Byrne

(2008), Byrne (2009), and Hu and Bentler (1999), we can affirm that the model

has obtained acceptable fit indices, namely χ² (160 df)

= 465.890; χ²/df = 2.91; CFI = .929; SRMR = .05; RMSEA =

.07 [.06, .08].

Table 4

Goodness-of-fit measures of the inferred model

|

5-factor Model |

χ² |

χ²/gl |

CFI |

SRMR |

RMSEA (IC 90%) |

|

|

465.890 |

2.91 |

.929 |

.05 |

.077 [.069,.085] |

Source: Own elaboration

4.5

Factorial invariance by gender

As mentioned earlier, our sample

is unbalanced with respect to the gender variable. The number of female units

in the sample is three times higher than the number of male units. For this

reason, we have conducted factorial invariance analysis. To this end, we used

four different procedures or models: configural (M1), metric (M2), scalar (M3),

and strict (M4), considering only the fit measures CFI (Comparative Fit Index)

and RMSEA (Root Mean Square Error of Approximation). The results are presented

in the table below.

Table 5

Measurement invariance of the Technology Acceptance Model measurement

scale

|

Models |

CFI |

RMSEA |

ΔCFI |

ΔRMSEA |

|

Configural |

.929 |

.077 |

- |

- |

|

Metric |

.910 |

.086 |

.019 |

.009 |

|

Scalar |

.907 |

.085 |

.003 |

.001 |

|

Strict |

.900 |

.086 |

.007 |

.001 |

Source: Own elaboration

To interpret the results, we

need to consider that ΔCFI should be ≤.01 and ΔRMSEA should be ≤.015 (Chen, 2007; Cheung & Rensvold, 2002).

Only these results indicate factorial invariance. In more detail, we observe

that the configural model achieved CFI = .929 and RMSEA = .077, which supports

the acceptance of the inferred model. Regarding the metric model, the only

non-compliance is ΔCFI = .019 > .01, while ΔRMSEA = .009 < .015. For the scalar model (intercept invariance),

both ΔCFI = .003 < .01 and ΔRMSEA = .001 < .015 meet

the criterion for factorial invariance. Finally, in the strict model, both ΔCFI = .007 < .01 and ΔRMSEA = .001 < .015 also

meet the criterion for factorial invariance.

5. Data Discussion

Although the pandemic

situation caused by the presence of COVID-19 has significantly improved, we

cannot consider it fully concluded. In fact, the presence of increasingly

contagious variants of the SARS-CoV-2 virus that can evade vaccine immunity may

lead to a new exponential increase in cases, and consequently, the

implementation of preventive measures, which could include a return to

non-face-to-face or semi-face-to-face education. In this context, therefore, it

seems appropriate to continue proposing VLEs in higher education, not only due

to the urgency of the situation (Bozkurt et al., 2020) but primarily because

they can be an opportunity to transform the health crisis into a high-quality

teaching and learning process (González-Villa et al., 2022). This scenario can

provide students with a wide range of competencies compatible with a highly

digitized society (Área-Moreira et al., 2020). Additionally, it is worth

mentioning that VLEs already had a strong presence in today's society (Hassani

et al., 2022; Infante-Moro et al., 2022), making them a strategy that seems to

be here to stay.

6. Study Conclusions

The main objective of this

study was to analyze the evidence of construct validity, score reliability, and

factorial invariance according to gender of a Measurement Scale of the Extended

TAM in a sample of higher education students in the Dominican Republic. In this

regard, it is worth highlighting that the main findings suggest that the scale

should be interpreted as a scale composed of 5 factors or dimensions, with

adequate reliability as internal consistency, and where factorial invariance

according to gender has been ensured.

The construct validation of

the scale was conducted through the calculation of exploratory and confirmatory

factor analyses. The EFA revealed a pentadimensional

factor structure consistent with the original scale by Urquidi-Martín et al.

(2019). In both cases, the study samples consisted of higher education students

from Spain and the Dominican Republic, respectively. Moreover, the CFA

confirmed this structure, achieving adequate fit measures.

Regarding score reliability as

internal consistency, it is important to note that the overall scale obtained a

very high value, as well as its respective dimensions, except for the PEU

dimension. This could be attributed to previous studies, such as those by

Schepers and Wetzels (2007) and Venkatesh and Davis

(2000), which suggest that the PEU of technology may not be a key element in

the technology acceptance model and its subsequent variations. However, these

results related to the reliability of the instrument support the presence of a

highly consistent and stable scale.

Concerning the presence of a

significant gender imbalance in the sample, the measurement invariance was

examined according to gender in order to avoid biased

conclusions after the development of the confirmatory factor analysis. The

results obtained from the factorial invariance analysis revealed that the pentadimensional structure is equivalent for both men and

women. Therefore, it can be affirmed that the resulting factorial structure is

solid and robust for both genders and does not show bias towards either group.

These results support the claim that the validated instrument possesses

factorial invariance according to gender (Van De Schoot

et al., 2015).

7. Limitations of the Study

Despite the aforementioned

strengths, the study has certain methodological limitations that need to be

taken into consideration. Firstly, since the study is still ongoing, we believe

that a larger sample size in the future will help reduce the discrepancies

between the measured statistics and the reference parameters. Secondly, the

non-probabilistic selection of the study population can also be considered a

limitation. If a probabilistic procedure had been followed, it would have been

possible to mitigate the gender imbalance in the sample. However, it is worth

noting that the fulfillment of factorial invariance has addressed this

potential threat, although it will be an aspect to consider in the upcoming

research, which will be conducted shortly with a larger sample. This research

aims to confirm a multiple serial mediation model with two variables: PU in the

use of a VLE and PL, taking into account the mediation of SN, ease of use, and

intention to use, based on an extended TAM.

8. Funding

This study is part of a

research project funded by ISFODOSU (Superior Institute of Teacher Training

Salomé Ureña) in the Dominican Republic, with reference VRI-INV-G-2020-26,

entitled "Perceived Usefulness and Competencies of Dominican University

Students in Virtual Learning Environments: An Analysis of Multiple Serial

Mediation."

References

Abdullah, F. & Ward, R. (2016). Developing a

General Extended Technology Acceptance Model for E-Learning (GETAMEL) by analysing commonly used external factors. Computers in Human

Behavior, 56, 238- 256. https://doi.org/10.1016/j.chb.2015.11.036

Adell, J., Castellet,

J. M., & Pascual, J. (2004). Selección de un entorno virtual de

enseñanza/aprendizaje de código fuente abierto para la Universitat

Jaume I. Centro de Educación y Nuevas Tecnologías de la UJI.

Ajzen I. (1985). From intention

to actions: A theory of planned behavior. In J. Kuhland

& J. Beckman (Eds), Action-control: From cognitions to behavior

(pp.11-39). Springe.

Ajzen, I. & Fishbein, M.

(1980). Understanding Attitudes and Predicting Social Behavior. Prentice-Hall.

Área-Moreira,

M.; Bethencourt-Aguilar, A. & Martín-Gómez, S. (2020). De la enseñanza

semipresencial a la enseñanza online en tiempos de Covid-19. Visiones del alumnado. Campus Virtuales, 9(2), 35-50.

Arteaga, R. & Duarte, A.

(2010). Motivational factors that influence the acceptance of Moodle using TAM.

Computer in Human Behavior, 26(6), 1632-1640. https://doi.org/10.1016/j.chb.2010.06.011

Báez-Estradas,

M. L. & Ossandón Núñez, Y. (2015). Propiedades psicométricas de la escala

de presencia social de las mentes en red y su aplicación en el Entorno Virtual

de Enseñanza Aprendizaje UTAmed. Universitas Psychologica, 14(3), 843-854.

Beaducel, A., & Herberg, P.Y. (2006). On the performance

of maximum likelihood versus means andvariance

adjusted weighted least squares estimation in CFA. Structural Equation

Modeling: A Multidisciplinary Journal 13, 186- 203. https://doi.org/10.1207/s15328007sem1302_2

Barroso-Osuna,

J., Cabero-Almenara, J. & Gutiérrez-Castillo, J.J. (2018). La producción de

objetos de aprendizaje en realidad aumentada por estudiantes universitarios.

Grado de aceptación de esta tecnología y motivación para su uso. Revista

Mexicana de Investigación Educativa, 23 (79), 1261-1283.

Bozkurt, A., Jung, I., Xiao, J., Vladimirschi,

V., Schuwer, R., Egorov, G.,

Lambert, S. R., Al-freih, M., Pete, J., Olcott, D., Rodes, V.,Aranciaga, I., Bali, M., Alvarez, A. V., Roberts, J., Pazurek,

A., Raffaghelli, J. E., Panagiotou,

N.. Coëtlogon, P., Shahadu, S.,…Paskevicius, M. (2020). A

global outlook to the interruption of education due to CovId-19 Pandemic:

navigating in a time of uncertaint and crisis. Asian

Journal of distance Education, 1(15), 1-126. https://doi.org/10.5281/zenodo.3878572

Byrne, B. (2008). Testing for

multigroup equivalence of a measuring instrument: Awalk

through the process. Psicothema, 20(4),

872–882.

Byrne, B. (2009). Structural

equation modelling with AMOS: Basic concepts, applications

and programming (2nd ed.). Routledge/Taylor and Francis.

Cabero-Almenara,

J. & Llorente-Cejudo, C. (2020). Covid-19: transformación radical de la

digitalización en las instituciones universitarias. Campus Virtuales, 9(2),

25-34.

Cabero-Almenara,

J., Barroso-Osuna, J., Gutiérrez-Castillo, J. J., & Palacios Rodríguez, A.

(2022). Desarrollando competencias digitales y emprendedoras en Pedagogía.

Grado de aceptación de una propuesta formativa. RiiTE

Revista Interuniversitaria de Investigación en Tecnología Educativa, (12),

49–63. https://doi.org/10.6018/riite.522441

Costello, A.B., & Osborne,

J. W. (2005). Best practices in exploratory factor analysis.Four recommendations for getting the most

from your analysis. Practical Assessment, Research & Evaluation, 10(7),

1-9. https://doi.org/10.7275/jyj1-4868

Curran, P. J., West, S. G.,

& Finch, J. F. (1996). The

robustness of test statistics to non normality and

specification error in confirmatory factor analysis. Psychological Methods

1, 16–29.

Davis, F.D. (1989). Perceived Usefulness, Perceived Ease

of Use and User Acceptance of Information Technology. MIS Quarterly, 13,

319-340.

Deng, L., & Tavares, N.

(2013). From Moodle to Facebook: exploring students´ motivation and experiences

in online communities. Computers & Education, 68, 167-176. https://doi.org/10.1016/j.compedu.2013.04.028

IBM Corp. Released 2021. IBM

SPSS Statistics for Windows, Version 28.0. IBM Corp.

Garson D. G. (2008). Factor

analysis: Statnotes: North Carolina State University

Public Administration Program.

http://www2.chass.ncsu.edu/garson/pa765/factor.htm.

George, D., & Mallery, M.

(2011). Using SPSS for Windows step by step: a simple guide and reference

18.0 Update (11th ed.). Allyn & Bacon/Pearson.

González-Villa,

A., Regueira, U. & Gewerc,

A. (2022). Hacia la enseñanza en línea. Estudio mixto de una reestructuración

metodológica en pandemia. Campus Virtuales, 11(2), 21-37. https://doi.org/0.54988/cv.2022.2.973

Hassani, E., Gelard, P., Sharifzadeh, F., & Azad, N. (2022). The

Impact of Learning organizations on Employee Performance with an Emphasis on

network Communication Approach. Education in the Knowledge Society, 23,

e26817. https://doi.org/10.14201/eks.26817

Hodgkinson, T., Curtis, H.,

MacAlister, D., & Farrell, G. (2016). Student academic dishonesty: The

potential for situational prevention. Journal of Criminal Justice Education,

27(1), 1-18. http://dx.doi.org/10.1080/10511253.2015.1064982

Hu, L., & Bentler, P. M.

(1999). Cutoff criteria for fit indexes in covariance structure analysis:

Conventional criteria versus new alternatives. Structural Equation Modeling, 6, 1–55.

Infante-Moro,

A., Infante-Moro, J. C., & Gallardo-Pérez, J.

(2022). Análisis de la virtualización de la docencia en el Máster de Turismo de

la Universidad de Huelva durante el CovId-19: docentes versus estudiantes. Campus Virtuales, 11(2), 197-208. https://doi.org/10.54988/cv.2022.2.1199

Najmul Islam, A.K.M. (2013).

Investigating e-learning system usage outcomes in the university context. Computer &. Education, 69, 387–399. https://doi.org/10.1016/j.compedu.2013.07.037

Ferreras-García,

R.; Sales-Zaguirre, J., & Serradell-López,

E. (2022). Generic competences and

learning results during the COVID-19 pandemic: a comparative study. Campus Virtuales,

11(2), 147-160. http://dx.doi.org/10.54988/cv.2022.2.1177

Katz,

M.H. (2006). Multivariate analysis. University Press.

Klein, G. (2013). The

Cartoon Introduction to Statistics. Hill & Wang.

Liaw, S.S. (2008).

Investigating students’ perceived satisfaction, behavioral intention, and

effectiveness of e-learning: A case study of the Blackboard system.

Computers & Education, 51(2), 864–873. https://doi.org/10.1016/j.compedu.2007.09.005

Lockee, B. B. (2021). Online

education in the post-COVID era. Nature Electronics, 4(1), 5-6. https://doi.org/10.1038/s41928-020-00534-0

Lorenzo,

U., & Ferrando, P. J. (2021). MSA: The Forgotten Index for

Identifying Inappropriate Items Before Computing Exploratory Item Factor

Analysis. Methodology, 17(4), 296-306. https://doi.org/10.5964/meth.7185

Mohamed, A.S. (2021).

Experience Sharing on Virtual COOP Training to Mechanical Engineering Students

during the COVID-19 Pandemic. Sustainability, 13(20), 1-16. https://doi.org/10.3390/su132011401

Premkumar, G., & Bhattacherjee, A. (2008). Explaining information technology

usage: A test of competing models. Omega, 36, 64–75. https://doi.org/10.1016/j.omega.2005.12.002

Rodríguez-Sabiote, C., Úbeda-Sánchez, Á.M., Álvarez-Rodríguez, J.,

& Álvarez-Ferrándiz, D. (2020). Active

Learning in an Environment of Innovative Training and Sustainability. Mapping

of the Conceptual Structure of Research Fronts through a Bibliometric Analysis.

Sustainability, 12, 8012. https://doi.org/10.3390/su12198012

Roitsch, J., Moore, R.L., & Horn, A.L. (2021). Lessons

learned: What the COVID-19 global pandemic has taught us about teaching,

technology, and students with autism spectrum disorder. Journal of Enabling

Technologies, 15(2), 108-116. https://doi.org/10.1108/JET-12-2020-0053

Ruiz-Aquino, M., Borneo, E., Alanía-Contreras R. D., García, E.S. & Zevallos, U.

(2022). Actitudes hacia las TIC´s y

uso de los entornos virtuales en docentes universitarios en tiempos de la

pandemia de la COVID-19. Publicaciones, 53(3), 197-120. https://doi.org/10.30827/publicaciones.v52i3.22270

Sánchez-Prieto,

J.C., Olmos-Migueláñez, S., & García-Peñalvo, F.J. (2016). Informal tools in formal contexts: Development of a

model to assess the acceptance of mobile technologies among teachers. Computer

Human Behaviour, 55, 519-528. https://doi.org/10.1016/j.chb.2015.07.002

Saza-Garzón, I. D. (2016). Estrategias

didácticas en tecnologías web para ambientes virtuales de aprendizaje. Praxis, 12(1),

103-110. https://doi.org/10.21676/23897856.1851

Schepers, J., & Werzels, M. (2007). A meta-analysis of the technology

acceptance model; investigating subjective norm and moderations effects. Information

y Management, 44(1), 90-103. https://doi.org/10.1016/j.im.2006.10.007

StataCorp. (2021). Stata Statistical Software: Release 17.

College Station, TX: StataCorp LLC.

Tan, K.H., Chan, P.P., &

Said, N.E.M. (2021). Higher Education Students' Online Instruction Perceptions:

A Quality Virtual Learning Environment. Sustainability, 13(19), 1-24. https://doi.org/10.3390/su131910840

Van De