Equivalencias entre los indicadores de

la herramienta SELFIE y el marco DigCompEdu a partir

de la técnica Delphi

Equivalences between SELFIE indicators and DigCompEdu framework

based on Delphi technique

Dña. Jacoba

Munar-Garau. Becaria de FPU-CAIB. Universidad de las

Islas Baleares, España

Dña. Jacoba

Munar-Garau. Becaria de FPU-CAIB. Universidad de las

Islas Baleares, España

Dr. Jorge

Oceja-Castañedo. Profesor ayudante

doctor. Universidad de las Islas Baleares, España

Dr. Jorge

Oceja-Castañedo. Profesor ayudante

doctor. Universidad de las Islas Baleares, España

Dr. Jesús

Salinas-Ibáñez. Catedrático de Universidad. Universidad de

las Islas Baleares, España

Dr. Jesús

Salinas-Ibáñez. Catedrático de Universidad. Universidad de

las Islas Baleares, España

Recibido:

2023/07/09 Revisado: 2023/09/13 Aceptado: 2023/11/15 Preprint: 2023/11/30 Publicado: 2024/01/07

Cómo citar este artículo:

Munar-Garau, J., Oceja-Castañedo, J.,

& Salinas-Ibáñez, J. (2024). Equivalencias entre los indicadores de la

herramienta SELFIE y el marco DigCompEdu a partir de

la técnica Delphi [Equivalences between

SELFIE indicators and DigCompEdu

framework based on Delphi technique]. Pixel-Bit. Revista de Medios y

Educación, 69, 131-168. https://doi.org/10.12795/pixelbit.101775

RESUMEN

SELFIE

es una de las herramientas más populares para determinar la competencia digital

de los centros educativos a partir de la información generada por equipos

directivos, alumnos y docentes. Sin embargo, no existe información sobre en qué

medida este instrumento y los informes que genera aportan información

específica sobre la competencia digital de los docentes según las áreas e

indicadores establecidos en DigCompEdu. A

través de un Delphi modificado de dos rondas con 19 expertos, se intentó

averiguar qué indicadores de la herramienta SELFIE (y en qué medida) se

corresponden con los indicadores de DigCompEdu y qué

relación existe entre las ocho áreas establecidas en SELFIE y las seis áreas

del marco DigCompEdu. Los resultados revelan

correspondencias entre los indicadores, especialmente en áreas como la

enseñanza y la evaluación. Además, demuestra que las áreas de ambos modelos

están interrelacionadas, lo que sugiere que los datos generados a través de la

herramienta SELFIE aportan información sobre la competencia digital específica

de los docentes de un centro. El texto aboga por continuar localizando y

diseñando instrumentos que puedan medir la competencia digital de centros y

docentes de una manera válida y rigurosa.

ABSTRACT

SELFIE is one of the most popular

tools for assesing the digital competence of schools based on information provided by

principals, students and teachers. However, there is

no information on how instrument and their reports provide specific information

on the digital competence of teachers according to the areas and indicators

established in DigCompEdu. Through a modified

two-round Delphi with 19 experts, this works tries to find out which indicators

of SELFIE (and to what extent) correspond to the DigCompEdu

items and what relationship exists between the eight areas established in

SELFIE and the six areas of the DigCompEdu framework.

The results reveal numerous correspondences between items, especially in areas

such as teaching and assessment. Furthermore, it shows that the areas of both

models are interrelated, suggesting that the data generated through SELFIE

could provide information on the specific digital competences of teachers in a

particular school. The text suggests to keep

identifying and designing instruments that can measure the digital competence

of schools and teachers in a valid and rigorous manner.

PALABRAS CLAVES· KEYWORDS

Competencia digital, juicio de

expertos, DigCompEdu, SELFIE, desarrollo profesional

docente

Digital competence, expert judgement, DigCompEdu, SELFIE, teacher’s professional development

1. Introducción

Desarrollo del enfoque competencial

en el contexto europeo. De la competencia a la competencia digital docente.

El enfoque competencial se

ha consolidado en la Unión Europea a través de distintos eventos y decisiones

estratégicas. Uno de los hitos más importantes fue la adopción, por parte del

Consejo Europeo en 2001, del informe de la Comisión titulado Futuros

objetivos precisos de los sistemas educativos y que incluía en su punto 1.2

la necesidad de promover la adquisición de las competencias necesarias para

alcanzar una sociedad basada en el conocimiento. La definición de la Comisión

Europea (2004, p.6) de las competencias clave es la siguiente:

“Las competencias claves

representan un paquete multifuncional y transferible de conocimientos,

capacidades y actitudes que todos los individuos necesitan para su desarrollo y

realización personal, inclusión y empleabilidad”.

Dado que desde entonces los distintos

territorios y centros educativos asumen esta definición, el Parlamento y el

Consejo Europeo recogen en 2006 el informe de la Comisión Marco europeo de

referencia para las competencias clave del aprendizaje permanente, el cual

se resume en un documento de carácter más divulgativo publicado el año

siguiente (Comisión Europea, 2007). Estos dos documentos son los primeros en

los que se recogen ocho competencias claves, definiéndose la competencia

digital de la siguiente manera:

“La competencia digital

entraña el uso seguro y crítico de las tecnologías de la sociedad de la

información (TSI) para el trabajo, el ocio y la comunicación. Se sustenta en

las competencias básicas en materia de TIC: el uso de ordenadores para obtener,

evaluar, almacenar, producir, presentar e intercambiar información, y

comunicarse y participar en redes de colaboración a través de Internet” (p.7).

Más recientemente, la recomendación del Consejo de 22 de

mayo de 2018 actualiza dicha definición estableciendo lo siguiente:

“La competencia digital

implica el uso seguro, crítico y responsable de las tecnologías digitales para

el aprendizaje, en el trabajo y para la participación en la sociedad, así como

la interacción con estas. Incluye la alfabetización en información y datos, la

comunicación y la colaboración, la alfabetización mediática, la creación de

contenidos digitales (incluida la programación), la seguridad (incluido el

bienestar digital y las competencias relacionadas con la ciberseguridad),

asuntos relacionados con la propiedad intelectual, la resolución de problemas y

el pensamiento crítico” (p. 9).

Aunque al tratarse de una

competencia ha de ser adquirida por todas las personas y en el marco del

aprendizaje a lo largo de la vida, la competencia digital de los docentes en

activo resulta clave de cara a evaluar la calidad de los sistemas educativos (Gisbert

et al., 2016). Por ello, el Centro Común de Investigación (CCI) de la Comisión

Europea desarrolló el marco DigCompEdu. Dicho marco

recoge y describe la competencia digital que han de poseer los docentes a

través de veintidós indicadores o ítems organizados en seis áreas (Redecker, 2020).

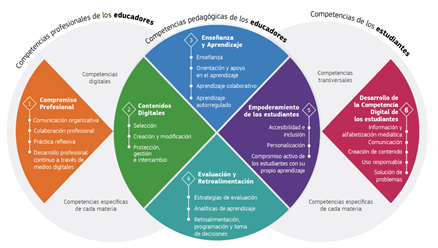

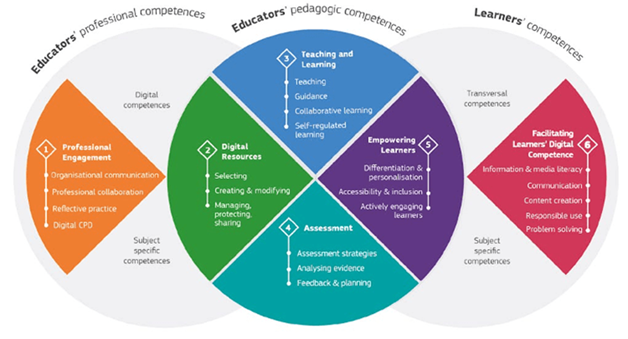

Figura 1

Marco DigCompEdu

Aprovechando el trabajo

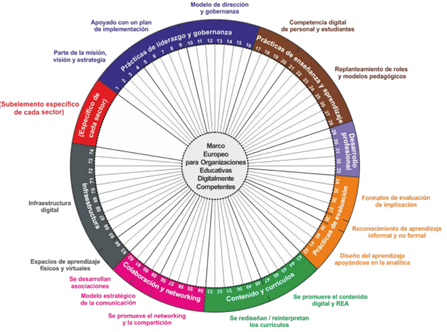

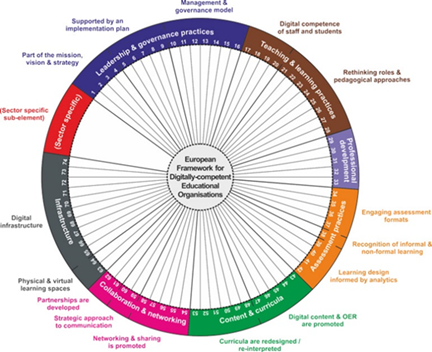

realizado, el CCI desarrolló de forma paralela un marco que sirviera para

evaluar, no solo las competencias intrapersonales, sino la competencia de las

organizaciones e instituciones educativas. El DigCompOrg

(Kampylis, 2015) persigue tal objetivo estableciendo

ocho dimensiones divididas en dieciséis variables.

Figura 2

Marco DigCompOrg

Basándose en estos marcos,

diversos autores han realizado trabajos que incluyen cuestiones como la

formación inicial del profesorado por parte de las universidades (Cabero et

al., 2023) o el impacto de los factores demográficos en la adquisición de la

competencia digital (Palacios et al., 2023).

1.1. Instrumentos para la

evaluación de la competencia digital y antecendentes

para su construcción

El diseño de instrumentos

oficiales de evaluación ha estado condicionado por los mencionados marcos (DigCompOrg y DigCompEdu)

existiendo en la actualidad dos herramientas (SELFIE -iniciales de Self-reflection on Effective Learning by Fostering the

use of Innovative Educational

technologies- y SELFIE for teachers respectivamente). Mientras que la primera mide la

competencia digital de los centros a partir de la información de equipos

directivos, alumnos y docentes, SELFIE for teachers informa a los docentes sobre su competencia a

través de una autoevaluación.

Diversos autores han desarrollado otras

herramientas para la evaluación y acreditación de la competencia digital

docente en particular en el ámbito español (Álvarez & Gisbert, 2015; Cabero

& Palacios, 2020; García-Hartacho et al., 2021;

Rodríguez et al., 2016; Tourón et al., 2018). Entre

éstas, el descontinuado Portafolio digital docente desarrollado por el

Instituto Nacional de Tecnologías Educativas y de Formación del Profesorado

(INTEF) (https://portfolio.intef.es/), informaba del nivel concreto de

competencia en base a las evidencias que adjuntaban los docentes: blogs , certificaciones obtenidas, etc. No obstante, más

allá de la autoevaluación que puedan hacer los docentes, la capacidad de

identificar líneas de mejora en cada centro es fundamental para desarrollar

políticas educativas basada en evidencias.

Esta capacidad podría lograrse mediante la adopción y aplicación de un

marco de autoevaluación escolar que haga hincapié en la responsabilidad de los

centros (Creemers et al., 2013; Hofman,

et al., 2010).

SELFIE se desarrolló para

proporcionar a los centros educativos un instrumento que permita medir los

puntos fuertes y débiles de su uso de las tecnologías competencias digitales de

los profesores (Costa et al., 2021). Se trata de una de las 11 iniciativas

establecidas en el Plan de Acción de Educación Digital adoptado por la Comisión

Europea (2018) para promover la autoevaluación de las prácticas educativas

digitales e innovadoras en el contexto escolar. Disponible en las 24 lenguas

oficiales de la Unión Europea, recoge de forma anónima las opiniones de

estudiantes, profesores y líderes escolares de cada centro. Para diseñar SELFIE

(véase Castaño-Muñoz et al., 2018 para detalles sobre su fiabilidad,

consistencia y validez) se realizó un análisis de las herramientas previamente

desarrolladas en Europa (Kampylis et al., 2016) tales

como Opeka y Ropeka en

Finlandia (Tanhua-Piiroinen & Viteli,

2017) y Digital Schools of Distinction en Irlanda (O'Leary, 2018).

Diversos estudios sobre

SELFIE (Panesi et al., 2020) se han centrado en

describir la herramienta y el proceso de autorreflexión asociado y en

identificar las similitudes y diferencias con iniciativas similares. Los

resultados revelan que SELFIE es uno de los pocos instrumentos que incluye la

participación integral de los alumnos en la evaluación realizan los centros (Kampylis et al., 2016, 2019; Castaño-Muñoz et al., 2018).

Otros estudios de investigación (Szûcs, 2019; Bocconi et al., 2020) arrojan luz sobre cómo SELFIE es útil

para abordar la innovación digital de una organización educativa. Jeladze y Pata (2018) demuestran que la autorreflexión de

la escuela al aplicar SELFIE ayuda a los profesionales que emplean tecnologías

a tener un mejor conocimiento sobre su progreso en este ámbito.

En una línea similar, el

presente estudio se basa en trabajos previos de los autores (Munar-Garau et al., 2023), orientados a generar un mapa de la

competencia digital docente a raíz de la crisis sanitaria. No se trató en aquel

momento de evaluar las estrategias y experiencias desarrolladas, sino de

conocer cuál era la realidad de la implementación de los recursos digitales y

los entornos tecnológicos en las escuelas así como el

desempeño de los equipos docentes, en este caso en las Islas Baleares. Por ello

se optó en dichos trabajos por SELFIE (https://education.ec.europa.eu/es/selfie) en lugar de SELFIE for

teachers (https://education.ec.europa.eu/es/selfie-for-teachers) al considerarse importante la visión del

equipo directivo y los alumnos además de la de los propios docentes.

La tabla 1 sintetiza las

principales diferencias entre ambos instrumentos.

Tabla 1

Diferencias entre las herramientas SELFIE (para los centros) y SELFIE para

docentes

|

|

SELFIE |

SELFIE

para docentes |

|

Forma

de administración |

Gestionada por un administrador

que distribuye las preguntas a los agentes participantes |

Autónoma |

|

Marco en el que se sustenta |

DigCompOrg |

DigCompEdu |

|

Agentes participantes |

Miembros del equipo

directivo, docentes, alumnado |

Docentes a título

individual |

|

Información generada |

Diagnóstico del centro

respecto a su competencia digital como institución

orientado a la toma de decisiones |

Nivel de competencia

digital personal |

Dado que SELFIE para

docentes es un instrumento de uso personal y anónimo, en el ámbito de la

investigación educativa es más común acceder, tras la solicitud de los permisos

oportunos, a los informes que los colegios generan tras la aplicación de la

herramienta SELFIE. Sin embargo, no existe información sobre en qué medida

estos informes sirven para determinar la competencia digital de los docentes

según las áreas e indicadores establecidos en DigCompEdu.

Por ello, el objetivo principal del trabajo es generar información sobre las

equivalencias entre los ítems de la herramienta SELFIE y los indicadores de DigCompEdu averiguando, además, si existe relación entre

las áreas de ambos modelos. Esto permitirá, entre otras cuestiones, averiguar

en qué medida la información pública generada con SELFIE en los centros puede

aportar información sobre la competencia digital de sus docentes.

Utilizando la técnica Delphi

se intentará dar respuesta a las siguientes preguntas de investigación:

(P1) ¿Qué indicadores de la herramienta SELFIE se

corresponden con los indicadores de DigCompEdu según los criterios de los

expertos?

(P2) ¿Qué relación existe, entre las ocho áreas

establecidas en SELFIE y las seis áreas del marco DigCompEdu en función del

número de correspondencias detectadas entre indicadores?

2. Metodología

2.1. Diseño de investigación

La metodología empleada para

dar respuesta a las preguntas de investigación fue un Delphi modificado de dos rondas

con 19 expertos. No se trata, por lo tanto de un

diseño de investigación en el sentido tradicional (experimental, correlacional

o descriptivo) sino que se busca obtener la valoración y consenso de los

expertos respecto a una cuestión.

Franc (2021) menciona que el principal objetivo

de esta técnica es lograr el consenso alrededor de un tema sobre el cual, en el

momento en que comienza la aplicación, aún no existe dicho acuerdo. Según Franc, permite superar los problemas típicamente presentes

en los grupos de discusión, tales como los liderazgos excesivos, la presión del

grupo o el ruido generado.

En este trabajo se utiliza

un Delphi modificado (Linstone & Turoff, 1975) de dos rondas con 19 expertos, según el cual

pueden sustituirse las primeras fases por técnicas cualitativas similares como

los grupos de discusión o entrevistas. En este caso, la primera validación se

dio a través de un grupo de discusión con miembros del departamento en el que

se encuadra el trabajo. Esto permitió comprobar la funcionalidad del

instrumento, así como su usabilidad y el tiempo requerido para completarlo. El feedback recogido sirvió para ajustar el aspecto visual de

la herramienta y optimizar la forma de presentación.

Para facilitar el trabajo de

los expertos a la hora de diseñar el instrumento se creó una tabla de doble

entrada. La fila superior horizontal presentaba los indicadores del marco DigCompEdu agrupados por áreas mientras que la columna

vertical mostraba los del cuestionario SELFIE también agrupados por áreas (ver tabla). Se solicitó a los expertos que

valoraran en cada casilla de cruce en qué medida, de 1 a 5, existía relación

entre los distintos elementos siendo 1 “Apenas existe relación” y 5 “Existe una

fuerte relación”. Además, se ofrecía la posibilidad de dejar la casilla en

blanco si consideraban que no existía ninguna relación.

2.2. Informantes y criterios

de selección a partir del coeficiente de competencia experta

Diversos autores han

señalado la importancia de esta fase (Powell, 2003). En particular Cabero e

Infante (2014) mencionan algunos criterios que pueden ser utilizados para

seleccionar a los expertos. Entre ellos mencionan cuestiones como su

conocimiento y experiencia, su voluntad y disponibilidad, su compromiso o su

capacidad para mantener una comunicación efectiva. En este caso los criterios

establecidos fueron los siguientes:

Amplia experiencia en el ámbito de la tecnología

educativa y, en la medida de lo posible, con conocimiento de los sistemas de

acreditación de la competencia digital

Docente e investigador universitario

Manejo del castellano como lengua de comunicación

Se seleccionó una muestra

inicial (n = 30) con profesorado de universidades de España (n = 17), Chile (n

= 3), Portugal (n = 2), Colombia (n = 2), Perú (n = 1), Costa Rica (n =1),

Andorra (n = 1), México (n = 1), Argentina (n = 1) y Uruguay (n = 1). Tras un

primer contacto por correo electrónico, 21 expertos se comprometieron a

participar en el proyecto, de los cuales 20 completarían la primera ronda. De

éstos, 19 completaron, además, un cuestionario de competencia experta diseñado

siguiendo el modelo de Cabero y Barroso (2013). Finalmente, la segunda ronda

fue completada por estos 19 expertos.

Para valorar el coeficiente

de competencia experta se solicitó a cada participante que completara dos

cuestiones. Por una parte, que valoraran de 0 a 10 el grado de conocimiento que

consideraba poseer acerca de la tecnología educativa y de la competencia

digital docente. Este valor, multiplicado por 0,1 (con la intención de que se

mueva entre 0 y 1) representaría su coeficiente de conocimiento (Kc).

Por otra parte, para conocer

sus fuentes, se les pidió que indicarán en qué medida, de 1 a 3, cada uno de

los siguientes elementos había influido en su conocimiento:

Análisis teóricos realizados por el experto

Experiencia

Estudio de trabajos sobre el tema, de autores

españoles

Estudio de trabajos sobre el tema, de autores

extranjeros

Conocimiento acerca del estado del problema en el

extranjero

Intuición del experto

2.3.

Análisis del coeficiente de competencia experta

Tras otorgar distintos

valores a cada elemento siguiendo el modelo de Cabero y Barroso (2013) la suma

de dichas puntuaciones daría lugar al coeficiente de argumentación (Ka) que

sería de nuevo un valor entre 0 y 1.

Una vez obtenidos estos

datos, la fórmula para obtener el coeficiente de competencia experta es K=½(Kc+Ka) para que también este último valor se mueva en un

rango de 0 y 1.

Tabla 2

Coeficiente de conocimiento, coeficiente de argumentación y coeficiente de

competencia experto total. Valores medios y desviación típica

|

|

Kc (coeficiente de conocimiento) |

Ka (coeficiente de argumentación) |

K |

|

Media |

.836 |

.933 |

.885 |

|

Desviación típica |

.103 |

.097 |

.100 |

La puntuación media obtenida

(M = .836) indica que los niveles de experticia de los informantes son altos.

Las puntuaciones individuales (en todos los casos K ≥ .7) muestran que

todos ellos están en condiciones de participar en el estudio.

Una vez confirmada la

pertinencia de los informantes se solicitó el consentimiento de participación a

través del correo electrónico. En el correo se explicó el contexto y sentido

principal del trabajo, el número de ocasiones en las que requeriríamos su participación,

la forma de proceder y el tiempo estimado para completar cada ronda. Asimismo,

se les invitó a firmar y devolver por correo electrónico el consentimiento

informado. 19 participaron en todas las fases, lo cual según los criterios de Skulmonski et al., (2007) se presenta como un número

válido.

2.4. Desarrollo del Delphi

Los correos para el

desarrollo de la primera ronda se enviaron en febrero de 2023, recibiéndose las

últimas respuestas en marzo de 2023. A partir de éstas se establecieron los

valores medios de cada cruce, así como los niveles de consenso en cada caso utilizando

el rango intercuartílico (IQR). De esta manera construimos una nueva tabla con

dichos valores en la cual, para facilitar el trabajo de los informantes,

eliminamos aquellos con una puntuación media baja (M ≤ 2.5). En dicha

tabla se mostraban en verde los casos en los que existía consenso (IQR ≤

1) dándoles a los expertos la opción de volver a puntuar todos los ítems no

eliminados basándose en la nueva información. La nueva ronda tuvo lugar en

abril y se completó en mayo de 2023. Con la información obtenida se construyó

una tabla con las correspondencias entre los indicadores de SELFIE y los

indicadores de DigCompEDU que para los expertos

fueran particularmente significativas (M ≥ 4.5) y alrededor de las cuales

se hubiera generado consenso (IQR ≤ 1).

Finalmente, para dar

respuesta a la segunda pregunta de investigación se construyó una tabla de

doble entrada con las ocho áreas de SELFIE (en la izquierda) y las distintas

áreas de DigCompEDU (superior) para incluir en cada

cruce el número de indicadores en los cuales, según los expertos, existe una

gran correspondencia (M ≥ 4.5) dándose, además, altos niveles de consenso

(IQR ≤ 1). Esto nos permitiría, utilizando un código de colores,

representar cómo es la relación entre las áreas del instrumento SELFIE y del

marco DigCompEDU.

3. Resultados

3.1. Rondas

3.3.1. Primera ronda

Los resultados de la primera

ronda están disponibles en este enlace.

Ya desde este primer momento

aparecieron relaciones con medias altas y grandes niveles de consenso. La

siguiente tabla muestra aquellas relaciones en las que la media fue igual o

superior a 4.5 (M ≥ 4.5) y el rango intercuartílico inferior a 1 (IQR ≤

1).

Tabla 3

Medias (M) sobre la correspondencia entre los ítems de SELFIE y DigCompEDU, y los niveles de consenso (IQR) obtenidos tras

la primera ronda

|

SELFIE (Liderazgo) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

|

|

|

|

|

En nuestro centro respetamos los derechos de autor y las licencias de

uso al utilizar tecnologías digitales para la enseñanza y el aprendizaje |

(2) Protección, gestión e intercambio de contenidos digitales |

4.69 |

0 |

|

SELFIE (Colaboración e interconexión) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

En nuestro centro utilizamos tecnologías digitales al colaborar con

otras organizaciones |

(1) Colaboración profesional |

4.53 |

1 |

|

En nuestro centro colaboramos con otros centros y/u organizaciones para

apoyar el uso de tecnologías digitales |

(1) Colaboración profesional |

4.56 |

.75 |

|

SELFIE (Desarrollo Profesional Continuo) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

Nuestro equipo directivo reflexiona con nosotros sobre nuestras

necesidades de DPC en lo relativo a la enseñanza con tecnologías digitales |

(1) Práctica reflexiva |

4.59 |

0 |

|

Nuestro equipo directivo nos ayuda a intercambiar experiencias dentro del

centro sobre la enseñanza con tecnologías digitales |

(1) Práctica reflexiva |

4.63 |

.25 |

|

(1) Desarrollo profesional continuo |

4.69 |

1 |

|

|

SELFIE (Pedagogía: apoyo y recursos) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

Busco recursos educativos digitales de internet |

(2) Selección de recursos digitales |

4.89 |

0 |

|

Creo recursos digitales para reforzar mi método de enseñanza |

(2) Creación y modificación de recursos digitales |

4.94 |

0 |

|

Utilizo tecnologías digitales para la comunicación relativa al centro

educativo |

(1) Comunicación organizativa |

4.59 |

0 |

|

SELFIE (Pedagogía: prácticas aplicadas) |

Áreas e indiicadores de DigCompEdu |

M |

IQR |

|

Utilizo tecnologías digitales para facilitar la colaboración entre el

alumnado |

(3) Aprendizaje colaborativo |

4.94 |

0 |

|

SELFIE (Prácticas de evaluación) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

Utilizo tecnologías digitales para evaluar las habilidades de los

alumnos |

(4) Estrategias de evaluación |

4.89 |

0 |

|

Utilizo tecnologías digitales para facilitar retroalimentación adecuada

al alumnado |

(4) Estrategias de evaluación |

4.50 |

1 |

|

(4) Retroalimentación, programación y toma de decisiones |

5 |

0 |

|

|

Utilizo tecnologías digitales para que el alumnado reflexione sobre su

aprendizaje |

(3) Aprendizaje autorregulado |

4.71 |

0 |

|

(4) Estrategias de evaluación |

4.5 |

1 |

|

|

(4) Retroalimentación, programación y toma de decisiones |

4.75 |

0 |

|

|

Utilizo tecnologías digitales para que el alumnado pueda realizar

observaciones sobre el trabajo de sus compañeros |

(3) Aprendizaje colaborativo |

4.53 |

1 |

|

(4) Estrategias de evaluación |

4.79 |

0 |

|

|

(4) Retroalimentación, programación y toma de decisiones |

4.5 |

1 |

|

|

Nuestro equipo directivo me ayuda a utilizar tecnologías digitales para

fines de evaluación |

(4) Estrategias de evaluación |

4.6 |

.5 |

|

Utilizo datos digitales sobre los alumnos concretos para mejorar su

experiencia de aprendizaje |

(4) Analíticas de aprendizaje |

4.67 |

.75 |

|

(4) Retroalimentación, programación y toma de decisiones |

4.77 |

0 |

|

|

SELFIE (Competencias digitales del alumnado) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

En nuestro centro el alumnado aprende a actuar de manera segura en

internet |

(6) Uso responsable |

4.79 |

0 |

|

En nuestro centro el alumnado aprende a actuar de manera responsable en

internet |

(6) Uso responsable |

5 |

0 |

|

En nuestro centro el alumnado aprende a comprobar si la información que

encuentra en internet es fiable y precisa |

(6) Información y alfabetización mediática |

5 |

0 |

|

En nuestro centro el alumnado aprende a crear contenidos digitales |

(6) Creación de contenido digital |

4.94 |

0 |

|

En nuestro centro el alumnado aprende a comunicarse utilizando

tecnologías digitales |

(6) Comunicación y colaboración digital |

4.95 |

0 |

|

En nuestro centro el alumnado aprende a codificar o programar |

(6) Creación de contenido digital |

4.57 |

1 |

|

En nuestro centro el alumnado aprende a resolver problemas técnicos que

surgen al utilizar tecnologías digitales |

(6) Resolución de problemas digitales |

4.94 |

0 |

Esta primera ronda nos

sirvió para identificar relaciones potencialmente válidas (n = 77) a partir de

niveles en las medias (M ≥ 4.5) y los consensos con un rango

intercuartílico inferior a 1 (IQR ≤ 1).

3.3.2 Segunda ronda

A continuación, volvimos a

contactar con los participantes (n = 20) por correo electrónico para compartir

los resultados de la primera ronda. En esta ocasión bloqueamos las celdas con

medias bajas (M ≤ 2,5). Además, con un código de colores, indicamos

cuáles eran las relaciones en las que existían consensos significativos

dándoles, en cualquier caso, la opción de puntuar todas las celdas de nuevo.

Los resultados obtenidos (n = 19) pueden verse en este enlace.

La siguiente tabla muestra todas

las relaciones en las que la media es igual o superior a 4.5 (M ≥ 4.5) y

el rango intercuartílico inferior a 1 (IQR ≤ 1) tras la segunda ronda.

Tabla 4

Medias (M) sobre la correspondencia de los ítems de SELFIE y de DigCompEdu y los niveles de consenso obtenido tras la

segunda ronda

|

SELFIE (Liderazgo) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

(*) Nuestro equipo directivo involucra al profesorado en el desarrollo

de la estrategia digital del centro |

(1) Colaboración profesional |

4.55 |

1 |

|

(*) Cuento con el apoyo de nuestro equipo directivo a la hora de probar

nuevas formas de enseñanza con tecnologías digitales |

(1) Colaboración profesional |

4.71 |

.64 |

|

En nuestro centro respetamos los derechos de autor y las licencias de

uso al utilizar tecnologías digitales para la enseñanza y el aprendizaje |

(2) Selección de recursos digitales |

4.75 |

1 |

|

(2) Creación y modificación de recursos digitales |

4.62 |

.45 |

|

|

(2) Protección, gestión e intercambio de contenidos digitales |

4.96 |

0 |

|

|

SELFIE (Colaboración e interconexión) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

(*) En nuestro centro evaluamos nuestros progresos en materia de

enseñanza y aprendizaje con tecnologías digitales |

(4) Estrategias de evaluación |

4.6 |

1 |

|

(4) Analíticas de aprendizaje |

4.8 |

.75 |

|

|

(4) Retroalimentación,

programación y toma de decisiones |

4.6 |

1 |

|

|

(*) En nuestro centro debatimos sobre las ventajas y desventajas de la

enseñanza y el aprendizaje con tecnologías digitales |

(1) Práctica reflexiva |

4.71 |

.62 |

|

En nuestro centro utilizamos tecnologías digitales al colaborar con

otras organizaciones |

(1) Colaboración profesional |

4.72 |

.4 |

|

En nuestro centro colaboramos con otros centros y/u organizaciones para

apoyar el uso de tecnologías digitales |

(1) Colaboración profesional |

4.54 |

.56 |

|

SELFIE (Desarrollo Profesional Continuo) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

Nuestro equipo directivo nos ayuda a intercambiar experiencias dentro

del centro sobre la enseñanza con tecnologías digitales |

(1) Práctica reflexiva |

4.7 |

.43 |

|

(1) Desarrollo profesional continuo |

4.68 |

.45 |

|

|

SELFIE (Pedagogía: apoyo y recursos) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

Busco recursos educativos digitales de internet |

(2) Selección de recursos digitales |

4.85 |

.19 |

|

Creo recursos digitales para reforzar mi método de enseñanza |

(2) Creación y modificación de recursos digitales |

4.99 |

0 |

|

Utilizo tecnologías digitales para la comunicación relativa al centro

educativo |

(1) Comunicación organizativa |

4.93 |

.15 |

|

SELFIE (Pedagogía: prácticas aplicadas) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

Utilizo tecnologías digitales para facilitar la colaboración entre el

alumnado |

(3) Aprendizaje colaborativo |

4.97 |

.12 |

|

SELFIE (Prácticas de evaluación) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

Utilizo tecnologías digitales para evaluar las habilidades de los

alumnos |

(4) Estrategias de evaluación |

4.88 |

.12 |

|

|

(4) Retroalimentación, programación y toma de decisiones |

5 |

0 |

|

Utilizo tecnologías digitales para que el alumnado reflexione sobre su

aprendizaje |

(3) Aprendizaje autorregulado |

4.64 |

.25 |

|

(4) Estrategias de evaluación |

4.52 |

.43 |

|

|

(4) Retroalimentación, programación y toma de decisiones |

4.63 |

.47 |

|

|

Utilizo tecnologías digitales para que el alumnado pueda realizar

observaciones sobre el trabajo de sus compañeros |

(4) Estrategias de evaluación |

4.83 |

.17 |

|

(4) Retroalimentación, programación y toma de decisiones |

4.57 |

.5 |

|

|

Nuestro equipo directivo me ayuda a utilizar tecnologías digitales para

fines de evaluación |

(4) Estrategias de evaluación |

4.68 |

.29 |

|

(*) Utilizo datos digitales sobre alumnos concretos para mejorar su

experiencia de aprendizaje |

(4) Analíticas de aprendizaje (*) |

4.79 |

.33 |

|

(4) Retroalimentación, programación y toma de decisiones (*) |

4.81 |

.18 |

|

|

(5) Personalización (*) |

4.73 |

.46 |

|

|

SELFIE (Competencias digitales del alumnado) |

Áreas e indicadores de DigCompEdu |

M |

IQR |

|

En nuestro centro el alumnado aprende a actuar de manera segura en

internet |

(6) Uso responsable |

4.94 |

.22 |

|

En nuestro centro el alumnado aprende a actuar de manera responsable en

internet |

(6) Uso responsable |

4.99 |

.04 |

|

En nuestro centro el alumnado aprende a comprobar si la información que

encuentra en internet es fiable y precisa |

(6) Información y alfabetización mediática |

5 |

0 |

|

(*) En nuestro centro el alumnado aprende a dar crédito al trabajo de

otras personas que ha encontrado en internet |

(6) Creación de contenido digital (*) |

4.9 |

.38 |

|

En nuestro centro el alumnado aprende a crear contenidos digitales |

(6) Creación de contenido digital |

4.9 |

0 |

|

En nuestro centro el alumnado aprende a comunicarse utilizando

tecnologías digitales |

(6) Comunicación y colaboración digital |

4.99 |

.04 |

|

En nuestro centro el alumnado aprende a codificar o programar |

(6) Creación de contenido digital |

4.6 |

.38 |

|

En nuestro centro el alumnado aprende a resolver problemas técnicos que

surgen al utilizar tecnologías digitales |

(6) Resolución de problemas digitales |

4.94 |

.04 |

Nota.

El número entre paréntesis muestra el área

de DigCompEDU al que pertenece cada indicador: (1)

Compromiso profesional, (2) Contenidos digitales, (3) Enseñanza y aprendizaje,

(4) Evaluación y retroalimentación, (5) Empoderamiento de los estudiantes y (6)

Desarrollo de la competencia digital de los estudiantes.

(*) Indicadores descartadas en la primera ronda por medias inferiores a 4,5 y

añadidas tras la segunda ronda al subir la media y obtenerse consenso.

Indicadores eliminados en la segunda ronda

al bajar la media obtenida o por desaparición de consenso (ver Tabla 3):

- Desarrollo profesional continuo

- Nuestro equipo directivo

reflexiona con nosotros sobre nuestras necesidades de DPC en lo relativo a la

enseñanza con tecnologías digitales. (1) Práctica reflexiva. (M = 4.35) (IQR =

0.86)

- Prácticas de evaluación:

- Utilizo tecnologías digitales para

facilitar retroalimentación adecuada al alumnado (4) Estrategias de evaluación.

(M = 4.27) (IQR = 1)

- Utilizo tecnologías digitales para

que el alumnado pueda realizar observaciones sobre el trabajo de sus compañeros

(3) Aprendizaje colaborativo. (M = 4.05) (IQR = 0.37)

- Utilizo datos digitales sobre los

alumnos concretos para mejorar su experiencia de aprendizaje

- (4) Analíticas de

aprendizaje. (M = 4.37) (IQR =0.5)

- (4) Retroalimentación,

programación y toma de decisiones. (M = 4.36) (IQR = 0.45)

3.2. Respuesta a las

preguntas de investigación

3.2.1. Respuesta a P1

La segunda ronda sirvió, por

lo tanto, para dar respuesta a la primera pregunta de investigación. En

particular, pudimos comprobar cómo en la mayoría de las ocasiones, las

relaciones mostradas en la tabla 1 se consolidaron, aunque no todas las

relaciones de la primera ronda se mantuvieron (de hecho, se reducen en número

total) apareciendo, además, relaciones nuevas. No obstante, los datos muestran

consistencia entre ambas rondas. En particular, se añaden algunas relaciones al

alcanzar los umbrales de consenso o a los valores medios establecidos (n = 4),

mientras que otras desaparecen (n = 2). Los resultados finales muestran que se

dan medias elevadas (M ≥ 4.5) con altos niveles de consenso (IQR ≤

1) en un número importante de relaciones (n = 28).

3.2.2. Respuesta a P2

Para dar respuesta a la

segunda pregunta de investigación se construyó una tabla de doble entrada que

incluyera las ocho áreas de SELFIE (en la izquierda) y las distintas áreas de DigCompEdu (superior). El número en cada cruce corresponde

a la cantidad de indicadores en los cuales, según los expertos, existe una gran

correspondencia (M ≥ 4.5) dándose, además, altos niveles de consenso (IQR

≤ 1). Una mayor intensidad del color representa que esas dos áreas

comparten un mayor número de indicadores.

La siguiente tabla (Tabla 5)

muestra agrupados por dimensiones los números finales de relaciones.

Tabla 5

Áreas

de SELFIE y del marco DigCompEDU entre las que existe

una relación significativa si atendemos al número de indicadores con una

elevada correspondencia y con altos niveles de consenso

|

|

(1) |

(2) |

(3) |

(4) |

(5) |

(6) |

Total |

|

Liderazgo |

2 |

3 |

0 |

0 |

0 |

0 |

5 |

|

Colaboración e interconexión |

3 |

0 |

0 |

3 |

0 |

0 |

6 |

|

Infraestructura y equipamiento |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

|

Desarrollo profesional continuo |

2 |

0 |

0 |

0 |

0 |

0 |

2 |

|

Pedagogía: Apoyo y recursos |

1 |

2 |

0 |

0 |

0 |

0 |

3 |

|

Pedagogía: Prácticas aplicadas |

0 |

0 |

1 |

0 |

0 |

0 |

1 |

|

Prácticas de evaluación |

0 |

0 |

1 |

9 |

1 |

0 |

11 |

|

TOTAL |

9 |

5 |

2 |

12 |

1 |

0 |

28 |

Nota.

La tabla muestra las ocho áreas de SELFIE

(izquierda) y las áreas de DigCompEDU (superior). Los

números de cada cruce muestran a la cantidad de indicadores que se corresponden

(M ≥ 4,5) y en los cuales se da consenso (IQR ≤ 1).

(1) Compromiso profesional, (2) Contenidos digitales, (3) Enseñanza y

aprendizaje, (4) Evaluación y retroalimentación, (5) Empoderamiento de los

estudiantes y (6) Desarrollo de la competencia digital de los estudiantes

4. Discusión

En primer lugar, comprobamos

que existen un número importante de indicadores de DigCompEdu

que se corresponden con ítems de la herramienta SELFIE (n = 67). Algunas

relaciones son particularmente importantes como las que existen entre los ítems

En nuestro centro respetamos los derechos de autor y las licencias de uso al

utilizar tecnologías digitales para la enseñanza y el aprendizaje (SELFIE

-Liderazgo-) y Protección, gestión e intercambio de contenidos digitales (DigCompEdu -Contenidos digitales-) (M = 4.96; IQR = 0) o Creo

recursos digitales para reforzar mi método de enseñanza (SELFIE -Pedagogía:

apoyos y recursos-) y Creación y modificación de recursos digitales (DigCompEdu -Contenidos digitales-) (M = 4.99; IQR = 0).

Aunque estas relaciones

podrían parecen lógicas atendiendo a la formulación de los indicadores, ya de

por sí muy similares en su construcción, también se dan otras no tan evidentes

como Utilizo tecnologías digitales para facilitar la colaboración entre el

alumnado (SELFIE -Pedagogía: Prácticas aplicadas-) y Aprendizaje

colaborativo (DigCompEdu -Enseñanza y

Aprendizaje-) (M = 4.97; IQR = .12) o Utilizo datos digitales sobre alumnos

concretos para mejorar su experiencia de aprendizaje (SELFIE -Prácticas de

evaluación-) y Retroalimentación, programación y toma de decisiones (DigCompEdu -Evaluación y retroalimentación-) (M = 4.81; IQR

= .18).

Estas relaciones no se dan

sólo entre indicadores, ya que las áreas de los dos modelos parecen estar

relacionadas. Esto es evidente a nivel de nomenclatura en casos como Prácticas

de evaluación en SELFIE y Evaluación y retroalimentación en DigCompEdu. El trabajo confirma, por ejemplo, que

entre estas dos áreas se dan 18 relaciones directas, algunas con medias y

niveles de consenso particularmente elevados. Esto ocurre, por ejemplo, entre

el ítem de SELFIE En nuestro centro el alumnado aprende a resolver problemas

técnicos que surgen al utilizar tecnologías digitales y el indicador DigCompEdu Resolución de problemas digitales (M =

4.94; IQR = .04) o entre el ítem de SELFIE En nuestro centro el alumnado

aprende a actuar de manera responsable en internet y el indicador Uso

responsable.

Las relaciones entre las

áreas son también importantes entre Competencias digitales del alumnado

(SELFIE) y Desarrollo de la competencia digital de los estudiantes (DigCompEdu) (n = 10), Colaboración e interconexión (SELFIE)

y Compromiso profesional (DigCompEdu) (n = 8) y, en

menor medida entre otras como Liderazgo y compromiso profesional

(SELFIE) y Colaboración e Interconexión (SELFIE) (n = 5) o Desarrollo

profesional continuo y Compromiso profesional (DigCompEdu)

(n = 5).

Si bien algunos resultados

del trabajo podrían parecer lógicos al presentar determinadas áreas de SELFIE y

DigCompEdu nombres similares, las relaciones invitan

a pensar de una manera más transversal. Por ejemplo, partiendo de las seis

áreas de DigCompEdu, podríamos analizar qué áreas e

ítems de SELFIE podrían aportarnos información sobre cada una de ellas:

1)

Compromiso

profesional: Según los resultados, la medida en la que los docentes de un

centro se comportan como profesionales podría estar informada y condicionada

por los niveles de Colaboración e interconexión en SELFIE (i.e:

En nuestro centro debatimos sobre las ventajas y desventajas de la enseñanza y

el aprendizaje con tecnologías digitales). Esto coincidiría con lo apuntado por

San Fabián (2006) cuando subraya la relación entre estos dos ámbitos. También,

aunque en menor medida, por elementos vinculados al liderazgo (i.e: Nuestro equipo directivo involucra al profesorado en

el desarrollo de la estrategia digital del centro), cuestión apuntada por

Lázaro y Gisbert (2015) o las opciones que se le dan para el desarrollo profesional

continuo (i.e: Tengo acceso a posibilidades de

aprendizaje en lo relativo a la enseñanza y el aprendizaje con tecnologías

digitales) tal y como indican Tejada Fernández y Pozos Pérez (2018) al señalar

la necesidad de reajustar la formación continua en función de las competencias

digitales que han de tener los docentes según el marco normativo.

2)

Contenidos

digitales: La capacidad para seleccionar y crear contenidos digitales por parte

de los docentes podría estar informada por ítems de la categoría Pedagogía:

Apoyos y recursos de SELFIE. Este tipo de relaciones son bastante explícitas,

ya que los ítems que conforman el apartado son particularmente descriptivos (i.e: Creo recursos digitales para reforzar mi método de

enseñanza). Aunque en menor medida, el liderazgo en los centros (i.e: En nuestro centro respetamos los derechos de autor y

las licencias de uso al utilizar tecnologías digitales para la enseñanza y el

aprendizaje) vuelve a tener importancia en línea con lo apuntado por Pablos

Pons et al. (2010) cuando señala que el equipo directivo puede favorecer las

condiciones adecuadas para fomentar esta creación y selección de contenidos.

3)

Enseñanza

y aprendizaje: La dimensión pedagógica podría estar informada por elementos de

las áreas Pedagogía: Prácticas aplicadas (i.e:

Utilizo tecnologías digitales para adaptar mi método de enseñanza a las

necesidades individuales del alumnado) y Prácticas de evaluación de SELFIE (i.e: Utilizo tecnologías digitales para que el alumnado

reflexione sobre su aprendizaje). Estas relaciones subrayan cómo entre las

piezas más importantes de todo proceso didáctico se encuentran la definición de

metodologías y el establecimiento de estrategias de evaluación.

4)

Evaluación

y retroalimentación. La capacidad de los docentes para evaluar y dar feedback de calidad se refleja directamente en múltiples

ítems del área de SELFIE Prácticas de evaluación y, en menor medida, en algunos

del apartado Colaboración e interconexión (i.e: En

nuestro centro evaluamos nuestros progresos en materia de enseñanza y

aprendizaje con tecnologías digitales). De hecho, varios elementos de SELFIE

aparecen en la literatura científica como variables clave a la hora de realizar

una evaluación de calidad, como ocurre con Utilizo tecnologías digitales

para facilitar retroalimentación adecuada al alumnado, cuestión

apuntada por Espinoza Freire (2021).

5)

Empoderamiento

de los estudiantes. Aunque no es el área que ofrece más conexiones, la

capacidad de empoderar a los estudiantes podría estar informada por ítems de

SELFIE pertenecientes a los apartados Pedagogía: Prácticas aplicadas (i.e: Utilizo tecnologías digitales para adaptar mi método

de enseñanza a las necesidades individuales del alumnado) y, en menor medida,

por otros de Prácticas de evaluación (i.e: Utilizo

datos digitales sobre alumnos concretos para mejorar su experiencia de

aprendizaje).

6)

Competencia

digital del alumnado. La capacidad de los docentes para desarrollar en sus

alumnos la competencia digital podría estar informada por múltiples ítems del

área de SELFIE Competencias digitales del alumnado (i.e:

En nuestro centro el alumnado aprende a crear contenidos digitales). En este

caso la relación es prácticamente directa y diversas variables de los ítems de

SELFIE darían pistas sobre cómo promover la competencia digital del alumnado.

Los resultados estarían alineados con la asunción de que la promoción de la

competencia digital del alumnado es un elemento más dentro de la competencia

digital docente (Gisbert et al., 2016).

5. Conclusiones

El presente trabajo aporta

información sobre las posibles equivalencias entre los indicadores de las áreas

de DigCompEdu y los ítems de la herramienta SELFIE,

para confirmar si los datos obtenidos de los centros tras la aplicación de

dicha herramienta informan sobre la competencia digital de sus docentes. Aunque

algunos trabajos han explorado en qué medida los resultados de SELFIE aportan

información sobre distintas cuestiones educativas (Hippe

& Jakubowski, 2022), ésta seguía siendo una cuestión sin resolver.

Esperamos, por lo tanto, que el trabajo resulte de utilidad a aquellos

investigadores y profesionales de la educación que, teniendo acceso a reportes

generados con SELFIE, quieran obtener información sobre la competencia digital

específica de los docentes de un centro.

El estudio tiene diversas

limitaciones. A pesar del reconocimiento de la técnica Delphi como una forma

válida para generar consensos, la selección de los expertos puede tener cierto

sesgo al no tratarse de una muestra aleatoria sino seleccionada ad hoc por

los autores del trabajo. Algunos autores han señalado otros problemas

vinculados con esta metodología, como el que los resultados están basados en

opiniones en lugar de evidencias, el que el consenso no implique veracidad o, a

nivel general, la falta de datos sobre su validez. Keeney

et al. (2011) explican que el método no es un reemplazo ni de las revisiones

científicas rigurosas ni de la investigación original y su uso se recomienda

cuando el problema no sugiere la utilización de técnicas específicas de

análisis, como ocurre en este caso.

A su vez, podría

cuestionarse por qué es necesario el establecimiento de las correspondencias

buscadas en este trabajo cuando existe un instrumento específico que informa

sobre competencia digital de los docentes (SELFIE para docentes). Sin embargo,

se trata de una herramienta privada de autoevaluación mientras que SELFIE puede

compartirse de manera pública por los centros, lo que facilita su uso en

proyectos de investigación realizados desde el ámbito académico.

Dada la importancia de la

competencia digital de los docentes en nuestro contexto educativo, es necesario

continuar localizando y diseñando instrumentos que puedan medirla de una manera

válida y rigurosa. Las revisiones de distintos autores (García Ruiz et al.,

2023; Jiménez Hernández et al., 2021; Rodríguez-García et al., 2019) podrían

ser un punto de partida sobre el que continuar trabajando.

La permeabilidad de nuestro

mundo a lo digital convierte en una exigencia la alfabetización digital de los

docentes de todos los niveles educativos. Esperamos por ello que el presente

trabajo sirva para obtener diagnósticos certeros y, sobre todo, contribuya a

mejorar la competencia digital de los profesionales de la educación.

6. Financiación

Este trabajo ha sido

financiado por la Comunitat Autònoma

de les Illes Balears a través 519 de la Direcció

General de Recerca, Innovació i Transformació

Digital, con fondos derivados 520 del Impuesto de Tasas Turísticas y Turismo

Sostenible ITS2017-006 (PDR2020/49).

Equivalences between SELFIE indicators and DigCompEdu

framework based on Delphi technique

1. Introduction

Development of the competence

framework in Europe: from competence to digital competence in teaching

The European Union has established

a competence framework through different events and strategic decisions. One of

the most important milestones was the European Council’s 2001 decision to adopt

the European Commission’s report The Concrete Future Objectives of Education

Systems. Point 1.2 in the report included the need to promote the

acquisition of all necessary skills to attain a knowledge-based society. The

European Commission defines key skills as follows (2004, p.6):

“Key competences represent a

multifunctional and transferable set of knowledge, skills/abilities and

aptitudes that all individuals need for personal accomplishment and

development, inclusion and employability.”

Since then, different regions

and educational institutions have taken this approach leading the European

Parliament and Council to adopt the Commission’s 2006 report: European

Reference Framework for Key Competences for Lifelong Learning. The report

was summarised in a more accessible document released the following year

(European Commission, 2007).

These documents set out eight

competences, including digital competence, defined as follows:

“Digital competence involves

the confident and critical use of Information Society Technology (IST) for

work, leisure and communication. It is underpinned by

basic skills in ICT: the use of computers to retrieve, assess, store, produce,

present and exchange information, and to communicate and participate in

collaborative networks via the Internet” (p.7).

However, since this concerns a

skill, it needs to be acquired by all individuals within the framework of

lifelong learning. Thus, digital competence of practising teachers is key to

assessing the quality of education systems (Gisbert et al., 2016). In this

sense, the Joint Research Centre (JRC) of the European Commission has developed

the DigCompEdu framework. The framework includes and defines teachers’ digital

competence through 22 fundamental variables structured into six areas

(Redecker, 2020).

Figure 1

DigCompEdu Framework

Taking advantage of previous

work, the JRC developed a parallel framework not only to assess intra-personal skills

but also the competences of educational organisations and institutions. The DigCompOrg framework (Kampylis,

2015) pursues this objective by establishing eight elements structured into 16

sub-elements.

Figure 2

DigCompOrg Framework

Based on these frameworks,

several authors have carried out research targeting issues such as initial

teacher training (Cabero et al., 2023) or the impact of demographic factors on

the acquisition of digital competence (Palacios et al., 2023)

1.1. Instruments for assessing

digital competence

The design for official

assessment tools has been determined by the DigCompOrg and DigCompEdu

frameworks, and there are currently two official instruments

(SELFIE—Self-reflection on Effective Learning by Fostering the Use of

Innovative Educational Technologies —and SELFIE for Teachers, respectively).

The first measures digital competence at schools based on information from

management teams, students, and teachers, whilst the second measures teacher

competence through self-assessment.

These are not the only

instruments and several authors have developed other tools to assess and

certify teachers’ digital competence (e.g. in Spain, Álvarez & Gisbert,

2015; Cabero & Palacios, 2020; García-Hartacho et al., 2021; Rodríguez et

al., 2016; Tourón et al., 2018), most being designed as self-assessment tools.

One now-discontinued tool, the Portafolio digital docente (Digital

Teacher Portfolio) from the National Institute for Education Technologies and

Teacher Training (INTEF) (https://portfolio.intef.es/)

provided the specific skill level based on evidence submitted by teachers

themselves: blogs produced, certifications awarded, etc.

Beyond providing teachers with

self-assessment tools, the ability to spot needs and priorities for improvement

in schools is essential for successfully developing an evidence-based education

policy. This could be attained by adopting and implementing a school

self-assessment framework that emphasises the school’s responsibility for

quality (Creemers et al., 2013; Hofman, et al., 2010).

SELFIE (Costa et al., 2021)

was developed to provide schools with a tool to measure strengths and

weaknesses when it came to teachers’ use of digital technology. This is one of

the 11 initiatives set out in the Digital Education Action Plan adopted by the

European Commission (2018) to promote self-assessment for digital and

innovative education practice at schools. SELFIE is available in the 24

official EU languages, and it anonymously sets out the opinions of students, teachers and school leaders regarding how technology is used

in their schools.

Solid research underpins the

tool since it is based on the European Framework for Digitally Competent

Educational Organisations (DigComp). In order to draft SELFIE (see Castaño-Muñoz et al., 2018 for

details on data reliability, consistency and validity), several tools developed

and/or used in Europe were analysed (Kampylis et al.,

2016), including Opeka and Ropeka in Finland (Tanhua-Piiroinen & Viteli,

2017) and Digital Schools of Distinction in Ireland (O'Leary, 2018).

Until now, studies on SELFIE

have largely focused on describing the tool and the associated self-reflection

process, as well as identifying similarities and differences regarding other

initiatives (Panesi et al., 2020). These studies

found SELFIE to be one of the few instruments designed for comprehensive

student participation in digital self-assessment at schools (Kampylis et al., 2016, 2019; Castaño-Muñoz et al., 2018).

Other research (Szûcs, 2019; Bocconi et al., 2020) sheds light on how

SELFIE meets the need to approach aspects of digital innovation across all

educational organisation levels. Jeladze and Pata

(2018) show how data generated from self-reflection processes at schools using

SELFIE helps those using digital technology to gain greater insight into their

progress. This spotlights significant differences in

digital competence levels between different schools.

The present article is based

on data obtained by the authors in previous works that aimed to measure and

promote teacher digital competency (TDC) map (linked to developing professional

identity) after the recent health crisis (Munar et al., 2023). In this sense,

it was not originally concerned with assessing developed strategies and skills,

but rather with gaining a deeper awareness on how digital resources were really

implemented and what was the situation of technology environments at schools,

as well as the performance level of teachers in the Balearic Islands.

Data obtained in SELFIE as

opposed to the self-assessment tool for teachers (SELFIE for Teachers) was

selected for producing a map of digital competence geared towards digital

transformation. In this vein, gaining a perspective on the skills of management

teams, students and teachers was preferred over teachers’ individual

self-perception.

Thus, SELFIE tool in this

study refers to the instrument for measuring school competence (https://education.ec.europa.eu/es/selfie) as opposed to SELFIE for Teachers (https://education.ec.europa.eu/es/selfie-for-teachers), which measures individual teacher competence based on

self-assessment.

Table 1 summarises the main

differences between the two tools.

Table 1

Similarities and differences

between SELFIE tools for centres and teachers

|

|

SELFIE |

SELFIE for Teachers |

|

Method of administration |

Managed by an administrator

who distributes the questions to participating stakeholders |

Independent |

|

Underlying framework |

DigCompOrg |

DigCompEdu |

|

Participating stakeholders |

Management teams, teachers and students |

Teachers on an individual

basis |

|

Information obtained |

A diagnostic of the

schools’ digital competence as an institution geared towards decision-making |

Personal digital competence

level |

Since SELFIE for teachers is

an anonymous personal tool, educational research more commonly accesses reports

produced by schools after implementing SELFIE (after requesting permission).

Nonetheless, there is no

information on how these reports could be used to determine teachers’ digital

competence according to the areas and indicators set out in DigCompEdu.

Therefore, the initial problem guidingthis research

is the lack of information on possible equivalences between items in the SELFIE

tool and DigCompEdu indicators.

An attempt will therefore be

made to answer the following research questions through the Delphi method:

(Q1) Which SELFIE tool

indicators match the DigCompEdu indicators according to expert criteria?

(Q2) What is the relationship

between the eight areas in SELFIE and the six areas in the DigCompEdu framework

if we consider the number of indicators that show correlations, according to

the experts?

2. Methodology

2.1. Research design

The Delphi method selected as the

working methodology, was carried on in two rounds with 19 experts. Even though,

it isn’t a traditional research design (experimental, correlational,

descriptive), it aims to find experts’ consensus regarding a given subject.

Franc (2021) states that its

main objective is achieving consensus on a topic where no agreement exists

prior to using the Delphi method. According to Franc, it overcomes some common

problems in discussion groups, such as excessive leadership, group pressure or

general noise.

In order to verify the instrument’s functionality, usability and the time required

to fill it in, a pilot trial was run with researchers at the home university.

This feedback was used to adjust and optimise the tool.

This study uses a modified

Delphi (Linstone & Turoff, 1975) which replaces the first round with

similar qualitative techniques, such as discussion groups or interviews. In

this instance, methodological validation was provided by the discussion group In

which the research is framed.

A double entry table was

created to support the work of the experts. The top horizontal row sets out the

elements in the DigCompEdu framework grouped by area, whilst the vertical

column showed the items from the SELFIE questionnaire, also grouped by area (view

table). Experts were asked to score each checkbox from 1 to 5 to state

whether if there was a link between the different elements, where 1 equalled

“Almost no link” and 5 “A strong link”. Moreover, the box could be left blank

if they believed no link existed.

Selection of informants and

defining the expert competence coefficient

Several authors have

highlighted the important of this stage (Powell, 2003). In particular, Cabero

and Infante (2014) outline certain possible criteria to select experts,

including their knowledge and experience, willingness and availability,

engagement, and capacity to sustain effective communication. Criteria for this

study were as follows:

·

Broad experience in the field

of educational technology and, as far as possible, knowledge of digital

competence certifying systems.

·

Being a university lecturer

and researcher.

·

The ability to use Spanish as

a vehicular language.

An initial sample was selected

(n = 30) from university lecturers in Spain (n = 17), Chile (n = 3), Portugal

(n = 2), Colombia (n = 2), Peru (n = 1), Costa Rica (n = 1), Andorra (n = 1),

Mexico (n = 1), Argentina (n = 1) and Uruguay (n = 1). After initial e-mail

contact, 21 experts agreed to take part in the project, with 20 completing the

first round. Moreover, 19 filled in an expert competence questionnaire designed

in accordance with Cabero and Barroso’s model (2013). Finally, 19 experts

completed the second round.

In order to assess the expert

competence coefficient, each participant was asked to fill in two

questionnaires. On the one hand, they had to score their perceived knowledge of

educational technology and teacher digital competence from 0 to 10. This score

was multiplied by 0.1 (with the aim of keeping it between 0 and 1) to obtain

their knowledge coefficient (Kc).

On the other hand, to discover

the sources behind this knowledge, they were asked to indicate to what extent

each of the following elements had impacted their knowledge on a scale from 1

to 3:

·

Theoretical analyses

undertaken by the expert

·

Experience

·

Analysing work on the topic by

Spanish authors

·

Analysing work on the topic by

foreign authors

·

Their own knowledge about the

issue overseas

·

Expert intuition.

2.2. Expert competence

coefficient analysis

After giving each element

different scores in line with Cabero and Barroso’s model (2013), the sum of all

scores provided the argumentation coefficient (Ka), again with a value between

0 and 1.

After Then the formula for

obtaining the expert competence coefficient was K=½(Kc+Ka),

so that this letter value would sit in a range of 0 and 1.

Table 2

Knowledge, argumentation and total expert

competence coefficients. Average values and standard deviation

|

|

Kc (knowledge coefficient) |

Ka (argumentation coefficient) |

K |

|

Average |

.836 |

.933 |

.885 |

|

Standard deviation |

.103 |

.097 |

.100 |

The average score (M = .836)

indicates that informants’ expertise levels are high. Individual scores (in all

instances, K ≥ .7) show they are all suitable to take part in the study.

Firstly, consent was requested

from all participants via e-mail. The same e-mail explained the context and

main direction of the work, the number of times their participation would be

required, what was the procedure and the estimated time to complete each round.

In turn, and where if they accepted to participate, they were asked to sign and

return an informed consent form via e-mail. A total of 19 researchers confirmed

their participation, which represents a valid number, in accordance Skulmonski

et al. criteria (2007).

2.3. Delphi development

The e-mails to implement the

first round were sent in February 2023, and the last responses were received

back in March 2023. Based on these, the average values for each checkbox were

set, as well as the consensus levels in each instance by using the interquartile

range (IQR). Consequently, we put together a new table with these values and

eliminating those with a low average score (M ≤ 2.5) to aid the

informants’ work. The table displayed the instances of consensus in green (IQR ≤

1), providing experts with the option to re-score all items based on the new

information. The new round took place in April and was completed by May 2023.

The new information was used to produce a table with the correspondence between

SELFIE and DigCompEDU indicators that were

particularly significant for the experts (M ≥ 4.5), and around which

consensus arose (IQR ≤ 1).

Finally, and in order to

provide a response to answer the second research question, a double-entry table

was produced with the eight SELFIE areas (to the left) and the different DigCompEDU areas (at the top) to include the number of

indicators in each checkbox where a high correspondence existed, according to

the experts, (M ≥ 4.5), as well as demonstrating high consensus levels

(IQR ≤ 1). A colour code was used to enable us to show the link between

SELFIE areas and the DigCompEDU framework.

3. Analysis and results

3.1. Rounds

3.1.1. Round One

The first-round results are

available at the following link.

At this stage, links appeared showing

high averages combined with high consensus levels. The following table shows

all links where the average was equal to or above 4.5 (M ≥ 4.5) and an

interquartile range below 1 (IQR ≤ 1).

Table 3

Averages (M) for correspondence between SELFIE and DigCompEDU

items, and consensus levels (IQR), obtained after the first round

|

SELFIE (Leadership) |

DigCompEdu areas and variables |

M |

IQR |

|

At our centre we respect copyright and user licences

when using digital technology for teaching and learning |

(2) Managing, protecting, sharing digital

resources |

4.69 |

0 |

|

SELFIE (Collaboration and Networking) |

DigCompEdu areas and variables |

M |

IQR |

|

At our centre we use digital technology when

collaborating with other organisations |

(1) Professional collaboration |

4.53 |

1 |

|

At our centre we collaborate with other centres

and/or organisations to support the use of digital technology |

(1) Professional collaboration |

4.56 |

.75 |

|

SELFIE (Continuing Professional Development) |

DigCompEdu areas and variables |

M |

IQR |

|

Our management team thinks about our CPD needs alongside

us in terms of teaching with digital technology |

(1) Reflective practice |

4.59 |

0 |

|

Our management team supports us in sharing

experiences at the centre on teaching with digital technology |

(1) Reflective practice |

4.63 |

.25 |

|

(1) Continuing professional development |

4.69 |

1 |

|

|

SELFIE (Pedagogy: Supports and Resources) |

DigCompEdu areas and variables |

M |

IQR |

|

I search for digital educational resources on

the internet |

(2) Selecting digital resources |

4.89 |

0 |

|

I create digital resources to bolster my

teaching method |

(2) Creating and modifying digital resources |

4.94 |

0 |

|

I use digital technology for communication

regarding the education centre |

(1) Organisational communication |

4.59 |

0 |

|

SELFIE (Pedagogy: Implementation in the

Classroom) |

DigCompEdu areas and variables |

M |

IQR |

|

I use digital technology to help student

collaboration |

(3) Collaborative learning |

4.94 |

0 |

|

SELFIE (Assessment Practices) |

DigCompEdu areas and variables |

M |

IQR |

|

I use digital technology to assess students’

abilities |

(4) Assessment strategies |

4.89 |

0 |

|

I use digital technology to facilitate

appropriate feedback for students |

(4) Assessment strategies |

4.50 |

1 |

|

(4) Feedback, planning

and decision-making |

5 |

0 |

|

|

I use digital technology so that students

reflect on their learning |

(3) Self-regulated learning |

4.71 |

0 |

|

(4) Assessment strategies |

4.5 |

1 |

|

|

(4) Feedback, planning

and decision-making |

4.75 |

0 |

|

|

I use digital technology so that students are able to make observations about their classmates’ work |

(3) Collaborative learning |

4.53 |

1 |

|

(4) Assessment strategies |

4.79 |

0 |

|

|

(4) Feedback, planning

and decision-making |

4.5 |

1 |

|

|

Our management team supports me in using digital

technology for assessment purposes |

(4) Assessment strategies |

4.6 |

.5 |

|

I use digital data about specific students to

improve their learning experience |

(4) Analysing evidence |

4.67 |

.75 |

|

(4) Feedback, planning

and decision-making |

4.77 |

0 |

|

|

SELFIE (Student Digital Competence) |

DigCompEdu areas and variables |

M |

IQR |

|

Students at our centre learn how to use internet

safely |

(6) Responsible use |

4.79 |

0 |

|

Students at our centre learn how to use internet

responsibly |

(6) Responsible use |

5 |

0 |

|

Students at our centre learn how to check

whether information on the internet is reliable and accurate |

(6) Information and media literacy |

5 |

0 |

|

Students at our centre learn how to create

digital content |

(6) Content creation |

4.94 |

0 |

|

Students at our centre learn how to communicate

using digital technology |

(6) Communication and digital collaboration |

4.95 |

0 |

|

Students at our centre learn how to code or

program |

(6) Content creation |

4.57 |

1 |

|

Students at our centre learn how to solve

technical problems that come up when using digital technology |

(6) Problem-solving |

4.94 |

0 |

This first round helped us

identify potentially valid links (n = 77) based on average levels (M ≥

4.5) and consensus with an interquartile range below 1 (IQR ≤ 1).

3.1.2. Round Two

We then contacted participants

(n = 20) once again by e-mail to share the results from the first round. This

time, we blocked the cells with low averages (M ≤ 2.5). Moreover, we

colour-coded the checkboxes to indicate the links with significant consensus.

Regardless of this, we also gave them the option the score all the checkboxes

again. The results (n = 19) can be viewed at the following link.

The following table shows all

links where the average was equal to or above 4.5 (M ≥ 4.5) and an

interquartile range below 1 (IQR ≤ 1) after the second round.

Table 4

Averages (M) for the correspondence between SELFIE and DigCompEDU items, and consensus levels, obtained after the

second round

|

SELFIE (Leadership) |

DigCompEdu areas and variables |

M |

IQR |

|

(*) Our management team includes teachers in the

development of the centre’s digital strategy |

(1) Professional collaboration |

4.55 |

1 |

|

(*) I get support from our management team when

trying new teaching methods with digital technology |

(1) Professional collaboration |

4.71 |

.64 |

|

At our centre we respect copyright and user

licences when using digital technology for teaching and learning |

(2) Selecting digital resources |

4.75 |

1 |

|

(2) Creating and modifying digital resources |

4.62 |

.45 |

|

|

(2) Managing, protecting, sharing digital

resources |

4.96 |

0 |

|

|

SELFIE (Collaboration and Networking) |

DigCompEdu areas and variables |

M |

IQR |

|

(*) At our centre we assess our progress in

teaching and learning with digital technology |

(4) Assessment strategies |

4.6 |

1 |

|

(4) Analysing evidence |

4.8 |

.75 |

|

|

(4) Feedback, planning and decision-making |

4.6 |

1 |

|

|

(*) At our centre we discuss the advantages and

disadvantages of teaching and learning with digital technology |

(1) Reflective practice |

4.71 |

.62 |

|

At our centre we use digital technology when collaborating

with other organisations |

(1) Professional collaboration |

4.72 |

.4 |

|

At our centre we collaborate with other centres

and/or organisations to support the use of digital technology |

(1) Professional collaboration |

4.54 |

.56 |

|

SELFIE (Continuing Professional Development) |

DigCompEdu areas and variables |

M |

IQR |

|

Our management team supports us in sharing

experiences at the centre on teaching with digital technology |

(1) Reflective practice |

4.7 |

.43 |

|

(1) Continuing professional development |

4.68 |

.45 |

|

|

SELFIE (Pedagogy: Supports and Resources) |

DigCompEdu areas and variables |

M |

IQR |

|